この記事では、話題の大規模言語モデル(LLM)について基礎から実践まで包括的に解説しています。LLMとは何か、ChatGPTや生成AIとの違い、トークン化からデコードまでの詳細な仕組み、GPT-4やBERT等の主要モデルの特徴、カスタマーサポートやコード生成等の具体的活用事例、そして精度や安全性の課題まで網羅。AI初心者から企業導入を検討する方まで、LLMに関する疑問が解決できる実用的な内容となっています。

目次

大規模言語モデル(LLM)とは何か

近年、AI技術の急速な発展により「LLM」という言葉を耳にする機会が増えています。LLMとは「Large Language Model(大規模言語モデル)」の略称で、人工知能が人間のような自然な言語理解と生成を可能にする革新的な技術です。この技術は、私たちの日常生活からビジネス現場まで幅広い領域で活用され始めており、その影響力は計り知れません。

言語モデルの基本概念

言語モデルの基本概念を理解するためには、まず「言語モデル」そのものの定義から始める必要があります。言語モデルとは、人間の言語パターンを学習し、文章の生成や理解を行うAIシステムのことを指します。

言語モデルの核となる仕組みは、大量のテキストデータから言語の統計的パターンを学習することにあります。具体的には、以下のような処理を行います:

- 単語や文章の出現頻度を分析

- 文脈における単語の関係性を把握

- 文法構造や意味的な関連性を学習

- 次に続く単語や文章を予測

この学習プロセスにより、言語モデルは人間が書いたかのような自然な文章を生成したり、質問に対して適切な回答を提供したりできるようになります。現代のLLMは、インターネット上の膨大なテキストデータ、書籍、論文、ニュース記事などから学習を行い、幅広い知識と言語能力を獲得しています。

また、言語モデルは単なる文章生成だけでなく、翻訳、要約、質疑応答、コード生成など多様なタスクに対応できる汎用性を持っています。この多機能性こそが、LLMが注目される大きな理由の一つとなっています。

従来の言語モデルとの違い

LLMと従来の言語モデルには、規模と性能において劇的な違いがあります。この違いを理解することで、なぜLLMが革新的な技術として注目されているのかが明確になります。

最も顕著な違いは、学習に使用されるパラメータ数の圧倒的な差です。従来の言語モデルが数百万から数億のパラメータで構成されていたのに対し、現代のLLMは数千億から数兆のパラメータを持ちます。この規模の違いにより、以下のような性能向上が実現されています:

| 比較項目 | 従来の言語モデル | 大規模言語モデル(LLM) |

|---|---|---|

| パラメータ数 | 数百万〜数億 | 数千億〜数兆 |

| 学習データ量 | 限定的なデータセット | インターネット規模の膨大なデータ |

| 対応タスク | 特定用途に特化 | 汎用的な多様なタスク |

| 文脈理解 | 短い文脈のみ | 長大な文脈を理解 |

従来の言語モデルは、特定の用途に特化して設計されることが多く、翻訳なら翻訳、質問応答なら質問応答といった具合に、個別のタスクごとに異なるモデルが必要でした。しかし、この方式では新しいタスクに対応するたびに新たなモデルの開発と学習が必要となり、効率性に課題がありました。

一方、LLMは一つのモデルで多様なタスクに対応できる汎用性を実現しています。これは「創発的能力」と呼ばれる現象で、モデルのサイズが一定の閾値を超えると、明示的に学習していないタスクに対しても優れた性能を発揮するようになります。この特性により、LLMは従来では考えられなかった柔軟性と応用範囲を持つ言語モデルとして注目を集めています。

LLMと関連技術との違い

LLM(Large Language Model)は近年急速に発展している技術ですが、関連する他の技術との違いを正しく理解することが重要です。生成AI、ChatGPT、自然言語処理、機械学習といった技術は互いに関連しながらも、それぞれ異なる特徴と役割を持っています。

生成AIとの関係性

LLMとは生成AIの一分野であり、密接な関係性を持っています。生成AIは、テキスト、画像、音声、動画など様々なデータを生成する人工知能技術の総称です。一方、LLMは特にテキスト生成に特化した大規模言語モデルを指します。

生成AIの全体像を見ると、以下のような分類が可能です:

- テキスト生成AI(LLMが該当)

- 画像生成AI(DALL-E、Stable Diffusionなど)

- 音声生成AI

- 動画生成AI

- コード生成AI

つまり、LLMは生成AIのテキスト分野における代表的な技術と位置づけることができます。両者の関係性は、生成AIが上位概念、LLMが下位概念という階層構造になっています。

ChatGPTとの違い

ChatGPTとLLMの違いは、技術の種類と具体的な製品・サービスの違いとして理解できます。LLMは大規模言語モデル全般を指す技術概念ですが、ChatGPTはOpenAI社が開発した特定のAIチャットボットサービスです。

具体的な違いは以下の通りです:

| 項目 | LLM | ChatGPT |

|---|---|---|

| 性質 | 技術概念・手法 | 具体的な製品・サービス |

| 範囲 | 大規模言語モデル全般 | OpenAIの特定モデル |

| 利用形態 | 様々な実装が可能 | チャットインターフェース |

ChatGPTは内部的にGPT(Generative Pre-trained Transformer)というLLMを使用しており、LLM技術を活用した応用例の一つと考えることができます。他にも、Claude、Bard、LLaMAなど、様々なLLMベースのサービスが存在します。

自然言語処理(NLP)との違い

LLMと自然言語処理(NLP:Natural Language Processing)の関係は、手法と分野の違いとして捉えることが重要です。NLPは人間の言語をコンピュータで処理・理解するための学問分野全体を指し、LLMはその分野で使用される特定の手法の一つです。

従来のNLP技術との主な違いは以下の通りです:

- 規模の違い:従来のNLPモデルは比較的小規模だったが、LLMは数十億から数兆のパラメータを持つ

- 学習方法の違い:従来は個別タスクごとの学習が主流だったが、LLMは大量のテキストで事前学習を行う

- 汎用性の違い:従来のNLPは特定タスクに特化していたが、LLMは様々なタスクに対応可能

- 性能の違い:LLMは従来手法を大幅に上回る性能を実現

LLMはNLP分野における革新的な手法として位置づけられ、自然言語処理の可能性を大きく広げています。

機械学習との違い

LLMと機械学習の関係は、具体的手法と包括的分野の関係として理解できます。機械学習は、データからパターンを学習してタスクを実行するAI技術全般を指す分野であり、LLMはその機械学習技術を活用した特定の応用例です。

機械学習の体系における位置づけは以下のようになります:

- 機械学習(最上位分野)

- 教師あり学習

- 教師なし学習

- 強化学習

- 深層学習(ディープラーニング)

- 深層学習(機械学習の一分野)

- CNN(畳み込みニューラルネットワーク)

- RNN(再帰型ニューラルネットワーク)

- Transformer

- LLM(Transformerアーキテクチャを使用した深層学習モデル)

LLMは機械学習の中でも特に深層学習技術を基盤とし、Transformerアーキテクチャを採用した大規模なニューラルネットワークです。つまり、機械学習という大きな傘の下で発展した技術の一つがLLMということになります。

大規模言語モデルの動作原理

LLM(Large Language Model:大規模言語モデル)とは、膨大なテキストデータを学習して人間のような自然な言語処理を実現するAIシステムです。その動作原理は複数の段階的なプロセスから構成されており、データの収集から最終的な文章生成まで、高度な技術的メカニズムが組み合わされています。

データ収集と前処理

LLMの学習における最初のステップは、大規模なテキストデータの収集と前処理です。この段階では、インターネット上の記事、書籍、論文、辞書など、多様なソースから数十億から数兆の単語に及ぶテキストデータが収集されます。

収集されたデータは品質向上のために徹底的な前処理が行われます。具体的には以下の処理が実施されます:

- 重複コンテンツの除去

- 低品質なテキストのフィルタリング

- 個人情報やセンシティブな情報の削除

- 言語の識別と分類

- 文字エンコーディングの統一

この前処理段階でデータの質が最終的なLLMの性能を大きく左右するため、細心の注意を払って実行されます。

トークン化プロセス

前処理されたテキストデータは、次にトークン化と呼ばれる処理を通じて、コンピュータが理解できる形式に変換されます。トークン化とは、連続したテキストを意味のある最小単位(トークン)に分割する処理です。

現代のLLMでは、主にByte Pair Encoding(BPE)やSentencePieceといった手法が採用されています。これらの手法では:

- 文字レベルでの初期分割

- 頻出する文字列の組み合わせを識別

- 効率的なサブワード単位での分割

- 未知語に対する柔軟な対応

例えば「machine learning」という単語は、「mach」「ine」「learn」「ing」のようなサブワード単位に分割される場合があります。この手法により、語彙の多様性を保ちながら効率的な処理が可能となります。

ベクトル化処理

トークン化されたデータは、ニューラルネットワークで処理するために数値ベクトルに変換されます。この処理がベクトル化(エンベディング)です。各トークンは高次元の実数ベクトルとして表現され、意味的に類似した単語は近い位置に配置されます。

ベクトル化の過程では以下の要素が重要な役割を果たします:

- 位置エンコーディング:単語の順序情報を保持

- 次元数:一般的に512から数千次元のベクトル

- 初期化方法:ランダム初期化から事前学習済みの重みまで

- 正規化処理:ベクトルの大きさを統一

このベクトル化により、「王様」から「男性」を引いて「女性」を足すと「女王」に近いベクトルが得られるような、意味的な関係性が数学的に表現されます。

ニューラルネットワークによる学習

ベクトル化されたデータは、Transformerアーキテクチャと呼ばれるニューラルネットワーク構造で学習されます。この学習プロセスでは、大量の計算資源を使用して数週間から数ヶ月にわたる訓練が行われます。

学習過程の主要な要素には以下があります:

| 要素 | 説明 | 重要性 |

|---|---|---|

| 自己注意機構 | 文脈内の単語間の関係性を学習 | 高 |

| 多層構造 | 複雑な言語パターンの階層的学習 | 高 |

| 並列処理 | 効率的な計算とスケーラビリティ | 中 |

| 残差接続 | 勾配消失問題の解決 | 中 |

学習では「次の単語を予測する」というタスクを通じて、言語の統計的パターンと意味的関係を同時に獲得していきます。

文脈理解メカニズム

LLMの最も革新的な特徴の一つが、長い文脈を理解する能力です。従来の言語モデルとは異なり、現代のLLMは数千から数万トークンにわたる長い文脈を同時に処理できます。

文脈理解は主に以下のメカニズムによって実現されています:

自己注意機構により、各単語は文中の他のすべての単語との関係性を計算し、文脈に応じた適切な意味表現を動的に調整します。これにより、同じ単語でも文脈によって異なる意味を持つ現象(多義性)を適切に処理できます。

具体的な処理フローは以下の通りです:

- 入力文の全トークンを同時に処理

- 各トークン間の関連度を計算

- 重要な関係性に注意を集中

- 文脈に応じた表現を生成

この仕組みにより、代名詞の参照解決や長距離依存関係の理解が可能となっています。

デコード処理と出力生成

学習されたLLMが実際に文章を生成する際には、デコード処理と呼ばれる複雑なプロセスが実行されます。このプロセスでは、与えられた入力プロンプトに基づいて、最適な次の単語を選択し続けることで、coherentな文章を生成します。

デコード処理には複数の手法が存在し、それぞれ異なる特徴を持ちます:

- Greedy Decoding:最も確率の高い単語を常に選択

- Beam Search:複数の候補を並行して探索

- Top-k Sampling:上位k個の候補からランダム選択

- Top-p Sampling:累積確率に基づく動的な候補絞り込み

- Temperature Scaling:確率分布の調整による創造性制御

実際の出力生成では、これらの手法を組み合わせることで、正確性と創造性のバランスを取った自然な文章生成を実現しています。また、出力の品質を向上させるために、反復的な改善や一貫性チェックも行われます。

ファインチューニング手法

事前学習されたLLMを特定のタスクや用途に最適化するプロセスがファインチューニングです。この手法により、汎用的な言語理解能力を保ちながら、特定の分野や用途に特化した性能向上を図ることができます。

主要なファインチューニング手法には以下があります:

| 手法 | 特徴 | 適用場面 |

|---|---|---|

| 教師あり学習 | ラベル付きデータでの追加学習 | 分類、翻訳、要約タスク |

| 強化学習 | 人間のフィードバックによる最適化 | 対話システム、創作支援 |

| Few-shot Learning | 少数の例からの迅速な適応 | 新規ドメインへの適用 |

| Parameter-Efficient Tuning | パラメータの一部のみを調整 | 計算資源の制約がある場面 |

特に人間のフィードバックからの強化学習(RLHF:Reinforcement Learning from Human Feedback)は、ChatGPTなどの対話型AIで採用されており、人間の価値観や好みに合わせた出力生成を可能にしています。

ファインチューニングの効果は適用する手法とデータの質に大きく依存するため、目的に応じた適切な手法選択が重要となります。

Transformerアーキテクチャの分類

LLM(Large Language Model)の基盤技術であるTransformerアーキテクチャは、その構造によって大きく3つのタイプに分類されます。それぞれ異なる特徴と用途を持ち、現在主流となっているLLMの多くがこれらのアーキテクチャを採用しています。この分類を理解することで、各LLMの特性や適用分野をより深く把握できるでしょう。

エンコーダ型モデル

エンコーダ型モデルは、Transformerアーキテクチャのエンコーダ部分のみを使用したLLMです。このタイプのモデルは、入力されたテキスト全体を双方向に理解することができ、文脈の前後関係を同時に把握する能力に優れています。

エンコーダ型モデルの主な特徴として、以下の点が挙げられます:

- 双方向注意機構により、文章の前後の文脈を同時に参照可能

- マスク言語モデリング(MLM)による事前学習を実施

- テキスト分類や感情分析などのタスクに適している

- 文章の意味理解に特化した設計

代表的なエンコーダ型LLMには、BERTやRoBERTa、DeBERTaなどがあります。これらのモデルは自然言語理解タスクにおいて高い性能を発揮し、検索エンジンの改善や文書分類システムなどで広く活用されています。

デコーダ型モデル

デコーダ型モデルは、Transformerのデコーダ部分のみを使用したLLMで、現在最も注目を集めているアーキテクチャです。このタイプのモデルは、自然なテキスト生成能力に特化しており、人間らしい文章を作成することができます。

デコーダ型モデルの核となる特徴は以下の通りです:

- 自己回帰的な生成方式により、一つずつ単語を予測

- 因果的注意機構で未来の情報を参照せず、自然な順序で生成

- 次の単語予測(Next Token Prediction)による事前学習

- 長文の生成や対話タスクに適している

このアーキテクチャを採用したLLMには、GPTシリーズやLLaMA、Claude等があります。これらのモデルは文章生成、要約、翻訳、プログラミング支援など幅広いタスクで優秀な性能を示し、現在のLLMブームの中心的存在となっています。

エンコーダ・デコーダ型モデル

エンコーダ・デコーダ型モデルは、Transformerの完全な構造を使用したLLMで、入力の理解と出力の生成を分離して処理する特徴があります。このアーキテクチャは、入力と出力の形式が大きく異なるタスクに特に適しています。

エンコーダ・デコーダ型モデルの主要な特徴を以下に示します:

- エンコーダで入力テキストを完全に理解し、内部表現に変換

- デコーダでエンコーダの出力を参照しながら新しいテキストを生成

- 入力と出力の長さや構造が異なるタスクに対応可能

- 条件付きテキスト生成に優れた性能を発揮

| 特徴 | 適用例 | 利点 |

|---|---|---|

| 双方向エンコーディング | 機械翻訳、要約 | 入力の完全な理解 |

| 条件付き生成 | 質問応答、対話システム | 文脈に応じた適切な出力 |

| 柔軟な入出力 | テキスト変換タスク | 様々な形式に対応 |

代表的なエンコーダ・デコーダ型LLMには、T5やBARTなどがあります。これらのモデルは機械翻訳や文書要約、質問応答システムなどで高い性能を示し、特に入力を深く理解した上で的確な出力を生成する必要があるタスクで重要な役割を果たしています。

主要な大規模言語モデルの種類

LLM(Large Language Model)は、現在様々な企業や研究機関によって開発されており、それぞれ異なる特徴や強みを持っています。これらのモデルは自然言語処理の分野で革新的な進歩をもたらし、私たちの日常生活やビジネスシーンに大きな影響を与えています。

主要なLLMは大きく分けて、OpenAIが開発するGPT系列、Googleが手がける多様なモデル群、そしてその他の注目すべきモデルに分類できます。それぞれのモデルは独自のアプローチと技術的特徴を持ち、異なる用途や目的に最適化されています。

GPT系列モデル

OpenAIが開発するGPT(Generative Pre-trained Transformer)系列は、現在最も広く知られているLLMの一つです。トランスフォーマーアーキテクチャをベースとした生成型言語モデルとして、テキスト生成において革新的な性能を示しています。

GPT-3の特徴

GPT-3は2020年にリリースされ、1750億個のパラメータを持つ大規模言語モデルとして注目を集めました。このモデルの最大の特徴は、少数の例を示すだけで様々なタスクを実行できる「Few-shot Learning」能力です。

- 自然な文章生成と対話能力

- プログラミングコードの生成

- 翻訳や要約などの言語処理タスク

- 創作活動やアイデア生成のサポート

GPT-3は特定のタスクに向けた追加の学習を必要とせず、プロンプトエンジニアリングによって多様な用途に活用できる点が革新的でした。

GPT-4の進化点

GPT-4は前世代から大幅な性能向上を果たし、マルチモーダル機能を実装したことが最大の進化点です。テキストだけでなく画像も理解できるようになり、より複雑で高度なタスクに対応可能となりました。

| 機能 | GPT-3 | GPT-4 |

|---|---|---|

| 入力形式 | テキストのみ | テキスト + 画像 |

| 推論能力 | 基本的 | 高度な論理的推論 |

| 創造性 | 良好 | より高い創造性 |

また、GPT-4は安全性の面でも改善が図られ、有害なコンテンツの生成を抑制する機能が強化されています。

GPT-4oの最新機能

GPT-4oは「omni」を意味し、音声、テキスト、画像を統合的に処理できる最新モデルです。リアルタイムでの音声対話が可能になり、より自然な人間とAIの対話体験を実現しています。

- リアルタイム音声対話機能

- 感情を込めた音声生成

- 複数の言語での同時処理

- 高速なレスポンス時間

GPT-4oは従来のテキストベースの対話から一歩進んで、まるで人間同士が会話しているような自然なやり取りを可能にしています。

Googleが開発したモデル

Googleは検索エンジンとして培った自然言語処理の技術を活かし、多様なアプローチでLLMの研究開発を進めています。同社のモデルは理解に重点を置いたものから生成に特化したものまで幅広く展開されています。

BERTの仕組み

BERT(Bidirectional Encoder Representations from Transformers)は、双方向の文脈理解を特徴とする画期的なモデルです。従来の言語モデルが左から右へ順次処理していたのに対し、BERTは文章全体の文脈を同時に考慮します。

BERTは「マスクされた言語モデル」という手法を使用し、文章中の一部の単語を隠して、前後の文脈から予測する学習を行います。

この仕組みにより、BERTは以下の分野で優れた性能を発揮します:

- 検索クエリの意図理解

- 文書分類と感情分析

- 質問応答システム

- 言語間の意味的類似性判定

LaMDAの特性

LaMDA(Language Model for Dialogue Applications)は、対話に特化したGoogleの言語モデルです。自然で流暢な会話を実現することを目的として設計されており、特に対話の継続性と一貫性に優れています。

LaMDAの主な特性として、安全性と事実性を重視した設計が挙げられます。対話中に不適切な内容や誤情報を生成するリスクを最小化するため、複数の安全フィルターが組み込まれています。また、様々なトピックについて興味深く有益な対話を維持する能力も備えています。

PaLMの性能

PaLM(Pathways Language Model)は、Googleが開発した5400億パラメータを持つ大規模言語モデルです。Pathwaysシステム上で動作し、多様なタスクを効率的に処理できる設計となっています。

PaLMの注目すべき性能には以下があります:

- 多言語理解と生成能力の向上

- 数学的推論問題の解決能力

- プログラミングコードの理解と生成

- 常識推論タスクでの高い精度

特に、PaLMは少数の例から学習する能力が高く、新しいタスクに対しても迅速に適応できる特徴があります。

Geminiの機能

Geminiは、Googleが開発した最新のマルチモーダルAIモデルです。テキスト、画像、音声、動画を統合的に理解し、処理できる能力を持っています。Ultra、Pro、Nanoの3つのサイズで展開され、用途に応じて選択可能です。

- 高度な推論と問題解決能力

- 複雑な数学・科学問題の解答

- プログラミング支援とコード生成

- 創造的な文章・アイデア生成

- 多言語でのコミュニケーション

Geminiは特に専門的な知識を要する分野での性能が高く、研究や教育分野での活用が期待されています。

その他の注目モデル

OpenAIやGoogle以外にも、革新的なLLMを開発している企業や研究機関が数多く存在します。これらのモデルは独自のアプローチや特化した機能を持ち、LLM市場の多様性を支えています。

Claudeの特徴

Anthropic社が開発するClaudeは、安全性と有用性のバランスを重視した設計が特徴的なLLMです。「Constitutional AI」という手法を用いて、人間の価値観に沿った応答を生成するよう学習されています。

Claudeの主要な特徴:

- 長文の文書処理能力(最大100,000トークン)

- 詳細で論理的な分析と説明

- 倫理的配慮を重視した応答

- 創作活動における優れた支援能力

特に学術研究や企業の文書分析において、その正確性と信頼性が高く評価されています。Claudeは害のある内容の生成を避けながら、建設的で有益な対話を維持することに長けています。

LLaMAの開発背景

Meta(旧Facebook)が開発するLLaMA(Large Language Model Meta AI)は、研究コミュニティへの貢献を目的として開発されました。比較的少ないパラメータ数でも高い性能を実現することを目標とし、効率的なモデル設計が特徴です。

LLaMAの開発背景には以下の理念があります:

学術研究者や開発者がアクセスしやすいモデルを提供し、AI研究の民主化を推進する

このモデルは7B、13B、30B、65Bの異なるサイズで提供され、研究目的での利用が可能です。オープンな研究環境の構築により、LLM技術の発展と普及に貢献しています。

NVIDIA NeMoの強み

NVIDIA NeMoは、企業向けのAI開発プラットフォームとして設計されたフレームワークです。大規模言語モデルの開発、訓練、展開を効率的に行うためのツールセットを提供しています。

NVIDIA NeMoの主要な強み:

| 分野 | 機能 | メリット |

|---|---|---|

| モデル訓練 | 分散並列処理 | 高速な学習 |

| カスタマイズ | ドメイン特化調整 | 業界特化モデル |

| 展開 | 最適化エンジン | 効率的な推論 |

特に製造業、金融、ヘルスケアなどの専門分野において、企業固有のデータを活用したカスタムLLMの構築を支援しています。NeMoは高性能なGPUリソースを最大限活用し、大規模モデルの効率的な運用を実現しています。

LLMが得意とする業務領域

LLM(Large Language Model)は、膨大なテキストデータで学習された大規模言語モデルとして、現代のビジネスシーンにおいて多様な業務領域で活用されています。これらのモデルは自然言語処理技術の発展により、人間の言語理解に近い能力を持ち、様々な業務プロセスの効率化と品質向上に貢献しています。以下では、LLMが特に威力を発揮する主要な業務領域について詳しく解説します。

文章作成と要約

LLMの最も代表的な機能の一つが、高品質な文章作成と効率的な要約作業です。従来、人間が時間をかけて行っていた文章作成業務を、LLMは短時間で高い精度を保ちながら実行できます。

文章作成においては、マーケティング資料、プレスリリース、商品説明文、メール文面など、幅広いコンテンツの生成が可能です。LLMは指定されたトーンや文体に合わせて文章を調整することができ、ターゲット読者に応じた適切な表現を選択します。また、SEO対策を意識したキーワード配置や、読みやすい構成での文章作成も得意としています。

要約機能では、長大な文書やレポートから重要なポイントを抽出し、コンパクトで理解しやすい形にまとめることができます。これにより、会議資料の準備時間短縮や、膨大な情報の迅速な把握が実現されます。特に、複数の文書を横断した包括的な要約や、特定の観点に焦点を当てた要約など、用途に応じた柔軟な対応が可能です。

多言語翻訳機能

グローバル化が進む現代において、LLMの多言語翻訳機能は国際的なビジネス展開に欠かせない機能となっています。従来の機械翻訳システムと比較して、文脈や nuance をより正確に理解し、自然で読みやすい翻訳を提供します。

LLMは主要な言語間での翻訳において、単純な単語の置き換えではなく、文章全体の意味や文化的背景を考慮した翻訳を行います。ビジネス文書、技術文書、マーケティング資料など、専門性の高い文書についても、適切な専門用語を使用した精度の高い翻訳が可能です。

また、リアルタイムでの翻訳対応により、国際会議や多言語でのコミュニケーションが円滑に進められます。メール対応、契約書の翻訳、製品マニュアルの多言語化など、様々な場面で活用され、企業の国際競争力向上に貢献しています。さらに、翻訳の品質についても継続的な学習により向上し続けているため、より自然で正確な翻訳結果が期待できます。

文章校正と編集

文章の品質向上において、LLMは高度な校正・編集機能を提供し、プロフェッショナルレベルの文章品質を実現します。単純な誤字脱字の修正から、文章構造の最適化まで、包括的な編集サポートを行います。

文法チェック機能では、複雑な文法規則に基づいた正確な判定を行い、適切な修正案を提示します。また、表現の一貫性確保、冗長な表現の削除、より適切な語彙の提案など、文章の読みやすさと説得力を向上させる編集提案も行います。

さらに、文章のトーンや文体の統一、ターゲット読者に応じた表現の調整、論理的な構成への改善提案など、高次レベルの編集作業もサポートします。これにより、企業の広報資料、提案書、報告書などの重要文書において、一貫した品質と専門性を保持することが可能になります。編集プロセスの効率化により、コンテンツ制作のスピードアップと品質向上を同時に実現できます。

レポート作成支援

ビジネスにおいて重要な意思決定の基盤となるレポート作成において、LLMはデータ分析から文書化まで一貫したサポートを提供し、高品質なレポートの効率的な作成を実現します。

データ分析レポートでは、数値データや統計情報を基に、トレンドの分析、パターンの特定、将来予測などを含む包括的なレポートを生成します。LLMは複雑なデータセットから重要な洞察を抽出し、ビジネス関係者にとって理解しやすい形で表現することができます。

市場調査レポート、競合分析レポート、業績評価レポートなど、様々な種類のビジネスレポートに対応し、それぞれの目的に応じた構成と内容で作成します。また、グラフや表の作成支援、エグゼクティブサマリーの生成、推奨事項の提案など、レポートに必要な要素を包括的にサポートします。これにより、アナリストや管理職の業務負荷を大幅に軽減し、より戦略的な業務に集中できる環境を提供します。

質問応答システム

カスタマーサポートや社内ヘルプデスクにおいて、LLMベースの質問応答システムは24時間体制での高品質なサポートを実現し、顧客満足度と業務効率の向上に大きく貢献しています。

このシステムは、自然言語で投げかけられる多様な質問に対して、適切で分かりやすい回答を瞬時に生成します。製品の使用方法、トラブルシューティング、サービス内容の説明など、幅広い問い合わせに対応し、人間のオペレーターと同等またはそれ以上の対応品質を提供します。

また、質問の文脈や背景を理解し、関連する追加情報の提供や、より詳細な説明への誘導など、単純な一問一答を超えた対話的なサポートが可能です。社内向けには、人事制度、業務手順、システムの使用方法などに関する従業員からの質問に対して、即座に正確な情報を提供し、生産性の向上を支援します。学習機能により、過去の質問と回答の蓄積から継続的に改善され、より精度の高い対応が実現されます。

プログラムコード生成

ソフトウェア開発の現場において、LLMのプログラムコード生成機能は開発効率の飛躍的な向上とコード品質の改善を実現し、開発者の生産性を大幅に向上させています。

LLMは自然言語での要求仕様書からプログラムコードを自動生成することができ、Python、JavaScript、Java、C++など主要なプログラミング言語に対応しています。関数の実装、クラスの設計、アルゴリズムの構築など、様々なレベルのコード生成が可能で、開発者の意図を正確に理解したコードを提供します。

また、既存コードのリファクタリング、バグの修正提案、コードレビューの自動化、テストケースの生成など、開発プロセス全体をサポートします。コメントの自動生成やドキュメント作成支援により、保守性の高いコードベースの構築も可能です。さらに、セキュリティベストプラクティスに従ったコードの生成や、パフォーマンス最適化の提案など、品質向上に直結する機能も提供し、企業のソフトウェア開発力強化に貢献しています。

大規模言語モデルの制約と課題

LLM(Large Language Model)は革新的な技術として注目を集めていますが、その優れた能力の一方で、様々な制約や課題も抱えています。これらの課題は、LLMを実用的に活用する上で理解しておくべき重要なポイントです。技術的な限界から倫理的な問題まで、多岐にわたる課題について詳しく見ていきましょう。

出力精度と一貫性の問題

LLMの出力は確率的な性質を持つため、同じ質問に対しても異なる回答が生成される場合があります。この不一致は、ビジネスや学術的な用途において大きな問題となることがあります。

特に以下のような問題が指摘されています:

- 事実とは異なる情報を自信を持って提示する「ハルシネーション」現象

- 論理的矛盾を含む回答の出力

- コンテキストの理解不足による不適切な応答

- 長い会話における文脈の保持能力の限界

これらの問題は、LLMが訓練データから統計的パターンを学習しているものの、真の理解や推論能力を持たないことに起因しています。そのため、重要な判断や専門的な分析には人間の監視と検証が不可欠です。

感情や倫理判断の限界

LLMは人間の感情や複雑な倫理的判断を完全に理解することができません。テキストパターンから感情的な表現を模倣することはできますが、実際に感情を体験したり、道徳的な価値観を内在化したりすることはありません。

この限界は以下のような場面で顕著に現れます:

- 微妙なニュアンスを含む人間関係のアドバイス

- 文化的背景による価値観の違いへの対応

- 複雑な倫理的ジレンマに対する判断

- 個人の感情状態に応じた適切な対応

特に、カウンセリングや心理的サポートを必要とする分野では、LLMの限界を理解した上で適切な人間の専門家による介入が重要になります。

高度専門分野での制約

LLMは幅広い知識を持っていますが、高度に専門化された分野においては限界があります。医学、法律、工学などの分野では、最新の研究成果や実務経験に基づく判断が求められるため、LLMだけに依存することは危険です。

専門分野における主な制約として以下が挙げられます:

| 分野 | 主な制約 |

|---|---|

| 医療 | 診断の責任、個別症例への対応、薬事法規制 |

| 法律 | 判例の解釈、地域法の適用、法的責任の所在 |

| 工学 | 安全基準の適用、現場固有の制約、認証要件 |

これらの分野では、LLMを補助的なツールとして活用しつつ、最終的な判断は資格を持った専門家が行うことが重要です。

不適切コンテンツの対策

LLMは訓練データに含まれる様々な情報から学習するため、時として不適切なコンテンツを生成するリスクがあります。これは、偏見、差別的表現、有害な情報の拡散といった深刻な社会問題につながる可能性があります。

現在、多くのLLM開発者が以下のような対策を実施しています:

- コンテンツフィルタリングシステムの導入

- 人間によるフィードバック学習(RLHF)の活用

- 訓練データの精査と品質管理の強化

- 出力内容のリアルタイム監視システム

しかし、これらの対策にも完璧性はなく、常に新たな回避方法や想定外のケースが発見される可能性があります。利用者側でも適切な監視と判断が求められます。

セキュリティ面での懸念

LLMの普及に伴い、セキュリティ面での様々な懸念が浮上しています。これらの問題は技術的な脆弱性から悪意のある利用まで多岐にわたり、慎重な対応が必要です。

主要なセキュリティリスクには以下があります:

プロンプトインジェクション攻撃:悪意のある指示を巧妙に埋め込むことで、LLMに意図しない動作をさせる攻撃手法

- 機密情報の意図しない漏洩

- フィッシング詐欺やソーシャルエンジニアリングへの悪用

- 偽情報やディープフェイクテキストの大量生成

- システムへの不正アクセスの足がかりとしての利用

これらのリスクに対処するため、適切なアクセス制御、監査ログの記録、定期的なセキュリティ評価が重要になります。また、組織レベルでのLLM利用ガイドラインの策定と従業員教育も欠かせません。

LLMの発展の歴史

LLM(Large Language Model:大規模言語モデル)とは何かを理解するためには、その発展の歴史を振り返ることが重要です。現在のLLMが持つ高度な自然言語処理能力は、長年にわたる研究開発の積み重ねによって実現されました。ここでは、LLMがどのように進化してきたのか、その歴史的な変遷を詳しく見ていきましょう。

初期の自然言語処理技術(1950年代~1980年代)

LLMの歴史は、1950年代の初期コンピュータ時代まで遡ります。この時期の自然言語処理は、ルールベースのアプローチが主流でした。研究者たちは文法規則や辞書を手動で作成し、コンピュータに言語を理解させようと試みていました。

- 1950年:アラン・チューリングがチューリングテストを提案

- 1960年代:ELIZAなどの初期対話システムが開発

- 1970年代~1980年代:エキスパートシステムの発展

しかし、これらの手法は柔軟性に欠け、複雑な言語現象を扱うのが困難でした。

統計的手法の台頭(1990年代~2000年代)

1990年代に入ると、統計的機械学習手法が自然言語処理分野に導入されました。この時期は、データドリブンなアプローチへの転換点となりました。

| 年代 | 主要な技術 | 特徴 |

|---|---|---|

| 1990年代 | 統計的機械翻訳 | 大量のテキストデータから確率的モデルを学習 |

| 2000年代前半 | n-gramモデル | 単語の出現確率を統計的に計算 |

| 2000年代後半 | トピックモデル | 文書の潜在的なトピックを発見 |

ニューラルネットワークの復活(2010年代前半)

2010年代に入ると、深層学習(ディープラーニング)の技術革新により、ニューラルネットワークが再び注目を集めました。この時期のLLMとは何かを考える上で、以下の技術発展が重要な転換点となりました。

- Word2Vec(2013年):単語をベクトル表現として学習する手法の確立

- Sequence-to-Sequence(2014年):エンコーダー・デコーダーアーキテクチャの導入

- 注意機構(Attention)(2015年):文脈情報をより効果的に活用する仕組み

Transformerアーキテクチャの登場(2017年)

2017年にGoogleの研究チームが発表したTransformerは、現代のLLMの基盤となる革命的なアーキテクチャです。「Attention Is All You Need」という論文で紹介されたこの技術は、従来の循環ニューラルネットワーク(RNN)に代わる新しいアプローチを提示しました。

Transformerアーキテクチャは、自己注意機構(Self-Attention)により、文章内の任意の位置間の関係を直接モデル化することを可能にしました。

大規模言語モデルの爆発的発展(2018年~現在)

Transformerの登場以降、LLMは急速な発展を遂げました。この時期の発展は、モデルサイズの大規模化と事前学習手法の洗練が特徴的です。

主要なマイルストーン

- BERT(2018年):双方向の文脈理解を実現

- GPT(2018年):生成型事前学習モデルの先駆け

- GPT-2(2019年):15億パラメータの大規模化

- GPT-3(2020年):1750億パラメータへの飛躍的拡大

- ChatGPT(2022年):一般ユーザーへの普及開始

技術的進歩の要因

現在のLLMとは何かを理解する上で、以下の要因が発展を支えていることを認識することが重要です:

- 計算資源の向上:GPUやTPUなどの専用ハードウェアの発展

- データの大規模化:インターネット上の膨大なテキストデータの活用

- 学習手法の改良:事前学習とファインチューニングの組み合わせ

- 評価手法の確立:ベンチマークタスクによる客観的な性能評価

現在の動向と未来への展望

現在のLLMは、マルチモーダル対応や効率化の方向に発展しています。テキストだけでなく、画像や音声などの異なるデータ形式を統合的に処理する能力が求められており、LLMとは何かという定義も拡張されつつあります。

また、計算コストの削減や環境負荷の軽減を目指した研究も活発に行われており、より効率的なアーキテクチャや学習手法の開発が進んでいます。これらの技術革新により、LLMはさらに身近で実用的な技術として社会に浸透していくことが期待されています。

ビジネス活用事例と応用分野

LLM(Large Language Model)は現代のビジネスシーンにおいて革新的な変化をもたらしており、様々な業界で実用的な活用が進んでいます。企業の生産性向上やコスト削減、新たな価値創造において重要な役割を果たしており、その応用範囲は日々拡大しています。ここでは、LLMがどのような分野で具体的に活用されているのか、その代表的な事例と効果について詳しく解説します。

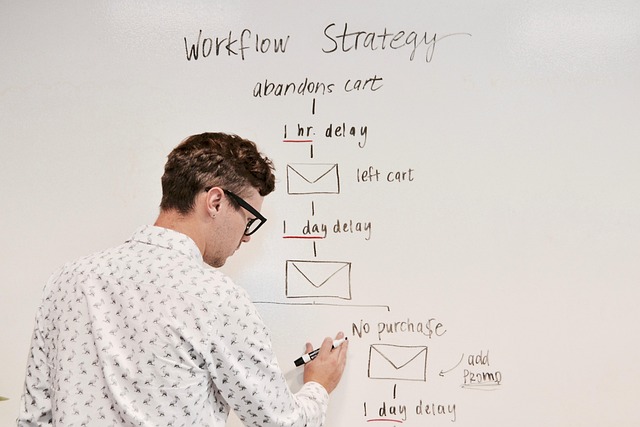

カスタマーサポートの自動化

LLMを活用したカスタマーサポートの自動化は、多くの企業で導入が進んでいる代表的な活用事例です。従来の定型的な応答しかできないチャットボットとは異なり、LLMは顧客の複雑な質問に対しても自然で適切な回答を提供できます。

具体的な活用方法として、まず24時間365日対応可能な自動応答システムの構築が挙げられます。顧客からの問い合わせ内容を理解し、FAQデータベースや製品情報を参照しながら、個別の状況に応じた回答を生成します。また、問い合わせの緊急度や複雑さを判断し、必要に応じて人間のオペレーターにエスカレーションする機能も実装できます。

さらに、多言語対応も大きなメリットの一つです。LLMは複数の言語に対応できるため、グローバル企業では各国の顧客に対して母国語でのサポートを提供することが可能になります。これにより、顧客満足度の向上と同時に、各地域での専門スタッフ配置コストの削減も実現できます。

文書処理業務の効率化

ビジネスにおける文書処理業務は時間とコストがかかる重要な作業ですが、LLMの導入により大幅な効率化が可能になっています。特に大量の文書を扱う法務、人事、営業部門において、その効果は顕著に現れています。

契約書の作成と審査業務では、LLMが標準的な契約書テンプレートの自動生成や、既存契約書の条項チェックを行います。リスクの高い条項の特定や、業界標準との比較分析も自動化でき、法務担当者の負担を大幅に軽減します。また、契約書の要点を抽出して要約を作成することで、関係者間での情報共有も効率化されます。

報告書や提案書の作成においても、LLMは強力なツールとなります。データや情報を入力することで、構造化された読みやすい文書を自動生成し、必要に応じて表やグラフの説明文も併せて作成します。さらに、既存文書の翻訳や多言語展開、文書間の整合性チェックなど、従来は専門スキルが必要だった作業も自動化できるようになりました。

マーケティング活動の支援

デジタルマーケティングの分野において、LLMは創造性と分析力を兼ね備えた強力な支援ツールとして活用されています。コンテンツ制作から戦略立案まで、マーケティング活動の全般にわたって効果的な支援を提供します。

コンテンツマーケティングでは、ブログ記事やSNS投稿の自動生成が主要な活用方法です。ターゲット顧客のペルソナや商品特性を入力することで、魅力的で説得力のあるコンテンツを短時間で作成できます。また、SEO対策を考慮したキーワード最適化や、各SNSプラットフォームの特性に合わせた投稿形式の調整も自動で行えます。

メールマーケティングにおいても、LLMは個別顧客に最適化されたパーソナライズメールの作成を支援します。顧客の購買履歴や行動データを分析し、それぞれの関心事に合わせた内容のメールを自動生成することで、開封率やコンバージョン率の向上が期待できます。さらに、A/Bテスト用の複数バージョンの作成や、効果測定のための分析レポート生成も可能です。

市場調査とデータ分析

市場調査とデータ分析の分野では、LLMが大量の情報処理と洞察の抽出において革新的な変化をもたらしています。従来は専門のアナリストが長時間をかけて行っていた作業を、より効率的かつ包括的に実行できるようになりました。

競合他社の分析では、公開情報やニュース記事の自動収集と分析が可能になります。LLMは企業のプレスリリース、財務報告書、製品情報などを総合的に分析し、競合の戦略動向や市場ポジションを把握します。また、ソーシャルメディアでの言及やカスタマーレビューを分析することで、ブランドイメージや顧客満足度の比較も行えます。

消費者インサイトの抽出においても、LLMの能力は非常に有効です。アンケート回答やインタビュー記録、オンラインレビューなどの定性データを分析し、消費者の潜在的なニーズや不満点を特定します。さらに、トレンド予測や市場機会の発見についても、過去のデータパターンと現在の市場動向を組み合わせて分析し、実用的な洞察を提供します。

アプリケーション開発支援

ソフトウェア開発の現場において、LLMは開発者の生産性向上と品質改善に大きく貢献しています。コーディングから設計、テストまで、開発プロセスの各段階で効果的な支援を提供し、開発チーム全体の効率化を実現しています。

要件定義と設計フェーズでは、自然言語による要件記述から技術仕様書の自動生成が可能になります。ビジネス要件を入力することで、システム設計書やAPI仕様書、データベース設計書などの技術文書を作成し、開発チーム内での認識統一を支援します。また、既存システムとの連携要件や非機能要件についても、業界のベストプラクティスを参考にした提案を行います。

実装段階においても、LLMは強力な開発パートナーとして機能します。複雑なアルゴリズムの実装支援や、異なるプログラミング言語間でのコード変換、ライブラリやフレームワークの使用方法に関するガイダンスなど、開発者が直面する様々な技術的課題に対して即座に支援を提供します。さらに、コードレビューの自動化やリファクタリング提案により、コード品質の向上も支援します。

チャットボットとコンテンツ生成

企業のデジタル戦略において、チャットボットとコンテンツ生成は顧客エンゲージメント向上の重要な要素となっています。LLMを活用することで、より自然で価値のある顧客体験を提供し、ブランドとの継続的な関係構築が可能になります。

インテリジェントチャットボットの開発では、文脈を理解した自然な対話が実現できます。単純な質問応答だけでなく、顧客の購買履歴や過去の問い合わせ内容を踏まえた個別対応が可能になり、まるで人間の担当者と話しているような体験を提供します。また、感情分析機能により顧客の満足度や不満を察知し、適切なタイミングでサポートスタッフにエスカレーションすることもできます。

コンテンツ生成においては、企業のブランドボイスやトーンに合わせた一貫性のあるコンテンツ制作が強みです。商品説明文、FAQ、ブログ記事、プレスリリースなど、様々な形式のコンテンツを企業の方針に沿って自動生成できます。さらに、ターゲット顧客や配信チャネルに応じて内容や表現を調整し、最適化されたメッセージを配信することで、マーケティング効果の最大化を図れます。

プログラム開発とバグ検出

ソフトウェア品質の向上とメンテナンス効率化において、LLMは開発者にとって欠かせないツールとなっています。コード生成からバグ検出まで、開発プロセス全体を通じて高度な技術支援を提供し、より堅牢で保守性の高いシステム構築を支援します。

自動コード生成機能では、仕様書や疑似コードから実装可能なプログラムコードを生成します。複数のプログラミング言語に対応し、プロジェクトの技術スタックや設計パターンに合わせたコードを作成できます。また、単体テストコードの自動生成により、テスト駆動開発(TDD)の実践も効率化され、品質の高いソフトウェア開発が実現できます。

バグ検出と修正支援においても、LLMの能力は非常に有効です。静的解析では発見困難な論理的なバグや、パフォーマンスの問題、セキュリティの脆弱性などを特定し、修正方法の提案も行います。さらに、レガシーシステムのモダナイゼーションにおいても、古いコードの解析と新しい技術への移行支援を提供し、システムの長期的な保守性向上に貢献します。コードドキュメンテーションの自動生成により、開発チーム内での知識共有も促進され、プロジェクト全体の生産性向上が期待できます。

代表的なLLM活用サービス

LLM(大規模言語モデル)とは何かを理解する上で、実際にどのようなサービスが展開されているかを知ることは非常に重要です。現在、多くの企業がLLM技術を活用した革新的なサービスを提供しており、私たちの日常生活や業務に大きな変化をもたらしています。ここでは、特に注目度が高く、多くのユーザーに利用されている代表的なLLM活用サービスについて詳しく解説します。

ChatGPTの機能

ChatGPTは、OpenAI社が開発したLLMベースの対話型AIサービスとして、世界中で最も知名度の高いサービスの一つです。このサービスは、自然な会話形式でユーザーとやり取りを行い、様々なタスクをサポートします。

ChatGPTの主要機能には、テキスト生成、質問応答、文章の要約、翻訳、プログラミング支援などがあります。特に注目すべきは、ユーザーの質問や要求に対して、文脈を理解しながら適切な回答を生成する能力です。

- 自然な対話形式での質問応答

- 創作活動のサポート(小説、詩、エッセイなど)

- ビジネス文書の作成支援

- プログラミングコードの生成と解説

- 学習支援と教育コンテンツの提供

- 多言語での翻訳と言語学習支援

さらに、ChatGPTは継続的な会話の文脈を保持する機能を持っており、一つの対話セッション内で複数の関連する質問に対して一貫性のある回答を提供できます。これにより、複雑なプロジェクトの相談や段階的な問題解決が可能になっています。

Copilotの特徴

Microsoft Copilotは、同社が提供するAIアシスタントサービスで、特にOffice製品との統合において優れた特徴を示しています。このサービスは、LLM技術を活用してユーザーの生産性向上を支援することを主な目的としています。

Copilotの最大の特徴は、既存のMicrosoft製品との深い統合にあります。Word、Excel、PowerPoint、Outlook、Teamsなどの馴染みのあるアプリケーション内で直接AI支援を受けることができ、業務効率の大幅な向上が期待できます。

| 統合アプリケーション | 主な機能 |

|---|---|

| Word | 文書作成支援、校正、要約 |

| Excel | データ分析、グラフ作成、数式生成 |

| PowerPoint | プレゼンテーション作成、デザイン提案 |

| Outlook | メール作成支援、スケジュール管理 |

また、Copilotは企業環境での利用を想定したセキュリティとプライバシー保護にも力を入れており、組織のデータガバナンスに準拠した形でAI機能を提供します。これにより、企業ユーザーも安心してLLM技術の恩恵を受けることができます。

Geminiの活用法

GoogleのGeminiは、同社が開発した次世代のLLMサービスで、マルチモーダル機能を特徴とする革新的なAIプラットフォームです。テキストだけでなく、画像、音声、動画など複数の形式のデータを統合的に処理できる点が他のLLMサービスとの大きな違いです。

Geminiの活用法は多岐にわたり、マルチモーダルな情報処理能力を活かした様々な用途で利用されています。特に、視覚的な情報とテキスト情報を組み合わせた分析や、複合的なコンテンツ制作において優れた性能を発揮します。

- 画像解析とテキスト生成の連携:写真やイラストを分析し、それに基づいた詳細な説明文や創作コンテンツを生成

- 教育分野での活用:図表や写真を含む教材の理解支援、視覚的な学習コンテンツの作成

- ビジネス分析:グラフやチャートの解析、プレゼンテーション資料の内容理解と改善提案

- クリエイティブワーク:デザインやアートワークに対するフィードバック、創作活動のインスピレーション提供

また、GeminiはGoogleの他のサービスとの連携も強みの一つです。Google Workspace、Google Cloud、YouTube、Google検索などとの統合により、包括的なデジタル体験を提供し、ユーザーの様々なニーズに対応できる柔軟性を持っています。

これらの代表的なLLM活用サービスは、それぞれ異なる強みと特徴を持ちながら、LLM技術の可能性を実証し続けています。ユーザーは自身の用途や環境に応じて最適なサービスを選択することで、AI技術の恩恵を最大限に活用することができるでしょう。

LLM運用に必要なIT環境

LLM(Large Language Model)とは大規模言語モデルのことで、膨大なテキストデータから学習した高度な自然言語処理AIです。LLMを実際に運用するためには、その処理能力の高さに対応できる十分なIT環境を整備する必要があります。特に計算処理能力、メモリ容量、ストレージ性能など、従来のシステムとは異なる要件を満たす必要があるため、事前の環境設計が重要となります。

GPU要件

LLMの運用において最も重要な要素がGPU(Graphics Processing Unit)です。LLMは並列処理が可能な大量の計算を必要とするため、CPUよりもGPUの方が圧倒的に効率的な処理が可能となります。

企業レベルでLLMを運用する場合、NVIDIA A100やH100といったデータセンター向けGPUが推奨されます。これらのGPUは80GB以上の大容量VRAM を搭載しており、大規模なモデルパラメータを一度にメモリ上に展開できます。中規模の運用であれば、NVIDIA RTX 4090やA40なども選択肢として考えられますが、VRAMの制約により処理可能なモデルサイズに限界があります。

複数のGPUを組み合わせた分散処理環境の構築も重要な検討事項です。モデルの規模によっては単一GPUでは処理しきれないため、NVLinkやInfiniBandを使用した高速なGPU間通信が可能な構成を選択する必要があります。また、GPUの冷却システムも十分に検討し、安定稼働を確保する必要があります。

サーバー仕様

LLM運用に適したサーバー仕様の選定では、GPU性能を最大限に活用できるバランスの取れた構成が求められます。CPUについては、Intel Xeon Platinum シリーズやAMD EPYC シリーズといった高性能プロセッサが適しています。

メインメモリ(RAM)は最低でも512GB以上、可能であれば1TB以上の容量を確保することが推奨されます。これはモデルデータの前処理、バッチ処理、結果の後処理などでGPU VRAM以外にも大量のメモリが必要となるためです。メモリ速度についても、DDR5-4800以上の高速メモリを選択することで、データ転送のボトルネックを回避できます。

ストレージ構成では、高速なNVMe SSDの採用が必須です。特にモデルの読み込み時間を短縮するため、PCIe 4.0対応の高速SSDを複数組み合わせたRAID構成が効果的です。容量については、使用するモデルサイズにもよりますが、10TB以上の容量を確保しておくことが安全です。また、データの冗長性確保のため、定期的なバックアップ体制の構築も忘れてはなりません。

その他必要機器

LLM運用環境を支える周辺機器についても、システム全体の安定性と性能に大きく影響するため慎重な選定が必要です。ネットワーク環境では、大容量データの転送が頻繁に発生するため、10GbE以上の高速ネットワーク接続が推奨されます。

電源システムは特に重要な要素です。高性能GPUを複数搭載したサーバーは消費電力が非常に大きく、単一サーバーで1000W以上の電力消費となることも珍しくありません。UPS(無停電電源装置)の導入により、突然の停電からシステムを保護し、データの整合性を維持する必要があります。また、電源効率の高いPlatinum認証以上の電源ユニットを選択することで、運用コストの削減も図れます。

冷却システムについては、GPU の発熱量が非常に大きいため、十分な冷却能力を持つ空調設備が必要です。ラック型サーバーの場合は、前面から背面への効率的なエアフローを確保し、適切な温度管理を行う必要があります。監視システムとしては、温度、電力消費、GPU使用率などをリアルタイムで監視できるツールの導入が推奨されます。

セキュリティ面では、ファイアウォール、侵入検知システム、アクセス制御システムなどの導入により、機密性の高いLLMモデルとデータを適切に保護する体制を整える必要があります。

今後の展望と未来予測

LLM(大規模言語モデル)の技術は急速に進歩しており、今後数年間でさらなる革新が期待されています。現在のGPTシリーズやBERTなどの成功を基盤として、LLMはより高度な機能と幅広い応用分野への展開が予測されています。

技術的な進化の方向性

LLMの技術的進化は、主に以下の方向性で進むと考えられています。まず、モデルの効率化と軽量化が重要な課題となっており、より少ないコンピュータリソースで高性能を実現する技術の開発が進んでいます。

- パラメータ数の最適化による処理速度向上

- 量子化技術によるメモリ使用量削減

- 分散処理技術の発展による大規模運用の実現

- エッジデバイスでの軽量LLM運用技術

また、マルチモーダル対応が進み、テキストだけでなく画像、音声、動画などの複数のデータ形式を統合的に処理できるLLMの開発が加速しています。これにより、より人間に近い理解能力と表現力を持つAIシステムが実現されるでしょう。

産業界への影響と応用拡大

LLMの産業応用は今後さらに拡大し、既存のビジネスモデルを大きく変革する可能性があります。自動化できる業務範囲の拡大により、多くの企業で生産性向上と業務効率化が実現されると予測されています。

| 業界 | 予想される変化 | 実現時期予測 |

|---|---|---|

| 教育 | 個別化学習システムの普及 | 2-3年以内 |

| 医療 | 診断支援・薬剤開発の高度化 | 3-5年以内 |

| 金融 | リスク分析・投資判断の自動化 | 2-4年以内 |

| 製造業 | 品質管理・予防保全の最適化 | 3-5年以内 |

特に注目されているのは、創造性を要求される分野でのLLM活用です。コンテンツ制作、デザイン、研究開発などの領域で、人間とLLMの協働による新しい働き方が確立されていくでしょう。

社会への長期的インパクト

LLMの普及は社会構造にも大きな変化をもたらすと予測されています。労働市場においては、既存の職種の変化や新しいスキルの必要性が生じる一方で、創造性や人間らしさを活かした新たな職業領域の創出も期待されています。

専門家の間では、LLMの発展により「人間とAIの協働時代」が本格化し、単純な作業の自動化から高度な知的作業の支援へとシフトしていくとの見解が共有されています。

教育分野では、個人の学習スピードや理解度に合わせたカスタマイズ教育が可能になり、従来の一律的な教育システムから脱却した新しい学習環境が構築されると考えられています。また、言語の壁を越えたコミュニケーションの実現により、グローバルな知識共有と協力がより活発になることも期待されています。

課題と対策の必要性

LLMの発展と普及に伴い、解決すべき課題も明確になってきています。プライバシー保護、情報の真偽判定、AIの判断に対する説明責任などの問題は、技術の発展と並行して取り組むべき重要な課題です。

- 倫理的なAI開発ガイドラインの策定と遵守

- バイアスの除去と公平性の確保

- セキュリティ対策の強化と継続的な改善

- 法的枠組みの整備と国際的な協調

これらの課題に対応するため、技術開発者、政策立案者、学術研究者、そして社会全体が連携して取り組む必要があります。LLMの恩恵を最大化しながらリスクを最小化するための包括的なアプローチが求められており、今後5年間がその基盤構築の重要な時期となるでしょう。