この記事では、AIの高速処理で注目されるGroqの基本概念から実際の使い方まで詳しく解説しています。ChatGPTやGeminiとの違い、回答精度を保ちながら高速化を実現する技術、料金体系、具体的な使用方法を知ることができます。さらに他の生成AIとの速度比較実験結果も紹介されており、Groqの導入を検討している方や生成AI選択で悩んでいる方に最適な情報が得られます。

目次

Groqの基本概要と特徴

Groqは、AI推論処理に特化した革新的なハードウェアアーキテクチャとクラウドサービスを提供する企業として注目を集めています。従来のGPUベースのAI処理とは異なるアプローチを採用することで、超高速なAI推論処理を実現し、リアルタイムアプリケーションや大規模言語モデルの実行において画期的な性能向上を可能にしています。

Groqの革新的なハードウェアアーキテクチャ

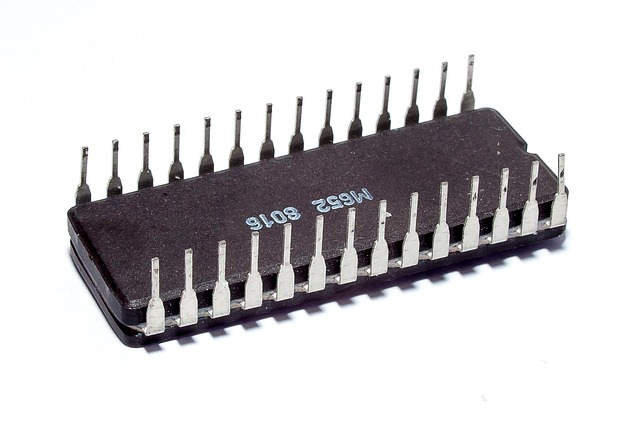

Groqの最大の特徴は、独自開発されたTensor Streaming Processor(TSP)と呼ばれる専用チップにあります。このアーキテクチャは、AI推論処理に最適化されており、従来のアーキテクチャと比較して大幅な性能向上を実現しています。

- 決定論的実行モデル:予測可能な実行時間を提供し、レイテンシの変動を最小限に抑制

- 高帯域幅メモリアクセス:データの読み書き速度を大幅に向上させる設計

- 並列処理最適化:AI推論に特化した並列処理能力を実現

- 低消費電力設計:効率的なエネルギー使用により運用コストを削減

クラウドサービスとしてのGroq

Groqは、自社のハードウェア技術をクラウドサービスとして提供しており、開発者や企業が簡単にアクセスできる環境を構築しています。このサービスにより、高性能なAI推論処理を手軽に利用することが可能になります。

| 特徴 | 詳細 |

|---|---|

| API提供 | OpenAI互換のAPIインターフェースを提供 |

| モデルサポート | Llama、Mixtral、Gemmaなど主要な大規模言語モデルに対応 |

| スケーラビリティ | 需要に応じた柔軟なリソース調整が可能 |

| 開発者体験 | 既存のワークフローに容易に統合可能 |

パフォーマンスと処理速度の優位性

Groqの最も注目すべき特徴は、その圧倒的な処理速度にあります。大規模言語モデルの推論処理において、従来のGPUベースのソリューションと比較して大幅な速度向上を実現しており、リアルタイムアプリケーションの可能性を大きく広げています。

Groqのアーキテクチャは、トークン生成速度において従来のソリューションを大幅に上回る性能を発揮し、チャットボットやリアルタイム翻訳などのアプリケーションで優れたユーザーエクスペリエンスを提供します。

この高速処理能力により、以下のような利点がもたらされます:

- ユーザーエクスペリエンスの向上:応答時間の短縮により、より自然な対話が可能

- リアルタイム処理の実現:ライブストリーミングや動画解析などでの活用

- コスト効率の改善:高速処理により単位時間当たりの処理量が増加

- 新しいアプリケーションの可能性:従来では困難だった用途での AI活用が現実的に

対応モデルと互換性

Groqは、現在広く使用されている主要な大規模言語モデルをサポートしており、開発者が既存のワークフローを大きく変更することなく、高性能な推論処理を利用できる環境を提供しています。

サポートされているモデルには、Meta社のLlamaシリーズ、Mistral AIのMixtralシリーズ、GoogleのGemmaシリーズなどが含まれており、それぞれのモデルに最適化された推論処理を実現しています。また、OpenAI APIとの互換性を保持しているため、既存のアプリケーションからの移行も容易に行うことができます。

Groqが実現する超高速AI処理の仕組み

AI処理の高速化において革命的な技術として注目されているGroqは、従来のGPUやCPUとは根本的に異なるアプローチで超高速なAI推論を実現しています。同社が開発した独自のLanguage Processing Unit(LPU)は、大規模言語モデルの推論処理において圧倒的な性能向上を可能にし、リアルタイムでのAI応答を現実のものとしています。

LPU(Language Processing Unit)の革新的アーキテクチャ

Groqの核心技術であるLPUは、言語処理に特化して設計された専用プロセッサです。従来のGPUが汎用的な並列処理を得意とするのに対し、LPUは言語モデルの推論処理に最適化された独自のアーキテクチャを採用しています。

LPUの特徴的な設計要素は以下の通りです:

- 決定論的アーキテクチャによる予測可能な実行時間

- メモリ階層の最適化による高速データアクセス

- 言語処理タスクに特化したコンピュートユニット

- 低レイテンシを実現するパイプライン設計

TSP(Tensor Streaming Processor)テクノロジー

GroqのLPUの基盤となるのが、同社が独自開発したTSP(Tensor Streaming Processor)テクノロジーです。このテクノロジーは、テンソル演算をストリーミング方式で処理することで、従来のバッチ処理よりも大幅な高速化を実現しています。

TSPの主要な技術的特徴:

| 技術要素 | 特徴 | 効果 |

|---|---|---|

| ストリーミング処理 | データをリアルタイムで連続処理 | レイテンシの大幅削減 |

| 決定論的実行 | 実行時間が予測可能 | 安定したパフォーマンス |

| メモリ最適化 | 効率的なデータ配置 | スループット向上 |

| 専用命令セット | AI処理に特化した命令 | 処理効率の最大化 |

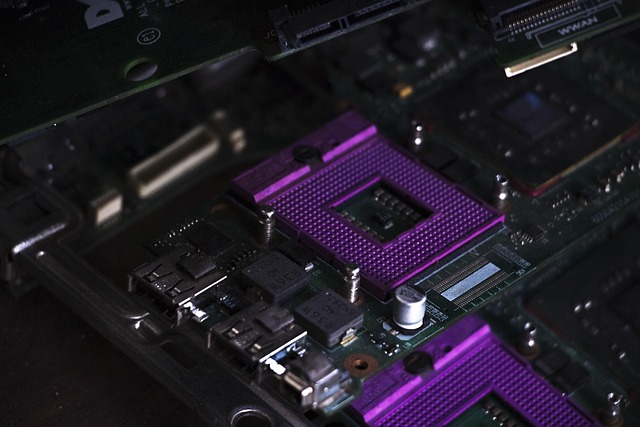

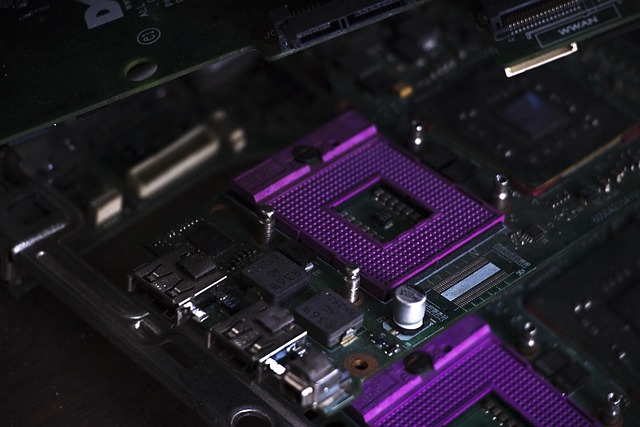

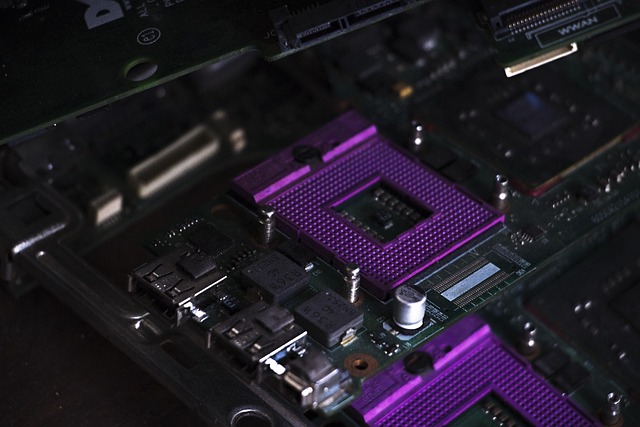

従来のGPU処理との根本的な違い

Groqの処理方式は、従来のGPUベースのAI処理とは本質的に異なるアプローチを採用しています。GPUが大量のコアを使った並列処理で高いスループットを実現するのに対し、GroqのLPUは言語処理の特性を活かした逐次的かつ効率的な処理方式を採用しています。

主な違いは以下の点にあります:

- 処理方式の違い:GPUのバッチ処理に対し、Groqはストリーミング処理を採用

- メモリアクセス:GPUの高レイテンシメモリに対し、Groqは低レイテンシ設計

- 実行の予測可能性:GPUの可変実行時間に対し、Groqは決定論的な実行時間

- エネルギー効率:専用設計により、汎用GPUよりも高いエネルギー効率を実現

実際の性能指標と技術的メリット

Groqの超高速AI処理は、具体的な性能指標において従来技術を大きく上回る結果を示しています。同社の技術により、大規模言語モデルの推論速度が従来比で数十倍から数百倍の高速化を実現しています。

技術的メリットの詳細:

Groqの処理方式では、トークンあたりの処理時間が大幅に短縮され、リアルタイムでの対話型AI応用が現実的になります。これにより、従来は困難だった即座の応答が求められるアプリケーションでも、高品質なAI機能を提供できるようになります。

具体的な技術的優位性:

- 低レイテンシ:ミリ秒単位での応答時間を実現

- 高スループット:同時処理能力の向上

- エネルギー効率:消費電力あたりの処理性能が大幅改善

- スケーラビリティ:需要に応じた柔軟な処理能力調整

- コスト効率:処理あたりのコストを大幅削減

この革新的な処理技術により、Groqは次世代のAI応用において、従来では実現困難だったリアルタイム性と高性能を両立させた新しい可能性を切り開いています。

Groqと主要AI サービスとの性能比較

Groqは革新的なAI推論チップ技術により、従来のAIサービスとは異なる特徴を持つプラットフォームとして注目を集めています。主要なAIサービスであるChatGPTやGeminiと比較することで、Groqの独自性と実用性を理解することができます。処理速度、応答性、機能面での違いを詳しく見ていきましょう。

ChatGPTとの違いと使い分け

GroqとChatGPTの最も顕著な違いは、処理速度とアーキテクチャの根本的な差異にあります。Groqは専用のLPU(Language Processing Unit)を使用することで、従来のGPUベースのChatGPTよりも大幅に高速な推論処理を実現しています。

具体的な性能差異として、以下の点が挙げられます:

- 応答速度:Groqは一般的に数百倍から数千倍高速な推論処理が可能

- レイテンシ:リアルタイム処理において圧倒的な低遅延を実現

- スループット:同時処理能力において優位性を発揮

- エネルギー効率:消費電力あたりの処理性能が高い

使い分けの観点では、リアルタイム性が重要な用途にはGroqが適している一方、ChatGPTは豊富な学習データと高度な対話能力で複雑な推論タスクに優れています。企業のチャットボット開発や音声認識システムなど、即座の応答が求められる場面ではGroqの採用メリットが大きくなります。

| 比較項目 | Groq | ChatGPT |

|---|---|---|

| 処理速度 | 超高速 | 標準的 |

| 対話の自然さ | 良好 | 非常に高い |

| リアルタイム処理 | 優秀 | 制限あり |

| 学習データの豊富さ | 限定的 | 非常に豊富 |

Geminiとの機能差異

GroqとGoogleのGeminiを比較すると、両者は異なるアプローチでAI技術の進歩を目指していることがわかります。Geminiがマルチモーダル機能に重点を置いているのに対し、Groqは処理速度の最適化に特化した設計となっています。

機能面での主な差異は以下の通りです:

- マルチモーダル対応:Geminiは画像、音声、テキストを統合的に処理できる一方、Groqは主にテキスト処理に最適化

- 処理アーキテクチャ:Geminiは汎用的なTransformerベース、GroqはLPU専用設計

- 推論速度:Groqが圧倒的に高速、Geminiは標準的な処理速度

- 統合性:GeminiはGoogle Workspaceとの連携が強い、Groqは独立したAPI提供

実用的な観点から見ると、Geminiは多様なメディア形式を扱う総合的なAIアシスタントとして機能する一方、Groqは特定のユースケースにおいて極めて高いパフォーマンスを発揮します。例えば、金融取引システムや医療診断支援など、処理速度が直接的に価値に結びつく分野では、Groqの技術的優位性が顕著に現れます。

Groqの革新的なLPUアーキテクチャは、従来のGPUベースのAI処理とは根本的に異なるアプローチを採用しており、特定の言語処理タスクにおいて従来技術を大幅に上回る性能を実現している。

コスト効率の面では、両サービスともに異なる価格体系を採用しているため、利用規模や処理量に応じた比較検討が重要になります。具体的な価格設定は変動する可能性があるため、導入前に最新の情報を確認することが推奨されます。

GroqがAI市場で注目を集める理由

AI技術の革新が加速する中、Groqは次世代のAI処理技術として業界から大きな注目を集めています。従来の汎用プロセッサーとは一線を画す独自のアーキテクチャにより、AI推論処理において圧倒的な性能を実現しているGroqは、AI市場の新たなゲームチェンジャーとして位置づけられています。

AI市場の急速な拡大

現在のAI市場は前例のない成長を遂げており、その規模は年々拡大の一途を辿っています。機械学習、深層学習、自然言語処理などの技術が成熟し、実用的なソリューションとして様々な業界で導入が進んでいることが背景にあります。

特に注目すべきは、AI推論処理の需要が爆発的に増加している点です。従来の学習フェーズに加えて、実際のサービス運用における推論処理の重要性が高まっており、企業はより高速で効率的な処理能力を求めています。この市場ニーズに対して、Groqの革新的なアプローチが解決策を提供しています。

- グローバルAI市場の年間成長率は20%以上を記録

- エッジコンピューティングの普及により分散処理需要が拡大

- リアルタイム処理を要求するアプリケーションの急増

- コスト効率性を重視する企業の増加

このような市場環境において、Groqの低レイテンシかつ高スループットな処理能力は、競合他社との差別化要因として大きな優位性をもたらしています。

ビジネス分野での文章生成AIの普及

ビジネス領域における文章生成AIの活用は、もはや実験段階を超えて本格的な実用化フェーズに入っています。コンテンツマーケティング、カスタマーサポート、業務文書作成など、多岐にわたる分野でAIによる文章生成技術が導入され、業務効率化と品質向上を同時に実現しています。

Groqの技術は、大規模言語モデル(LLM)の推論処理において卓越した性能を発揮し、文章生成AIの実用性を大幅に向上させています。従来のGPUベースのソリューションと比較して、より高速な応答時間と安定した処理能力を提供することで、ビジネス現場でのAI活用を促進しています。

| 活用分野 | 具体的な用途 | Groqの貢献 |

|---|---|---|

| マーケティング | 広告コピー、ブログ記事生成 | 高速な大量コンテンツ生成 |

| カスタマーサポート | 自動応答、FAQ生成 | リアルタイム対話処理 |

| 業務効率化 | 報告書、提案書作成支援 | 低レイテンシでの文書生成 |

企業がAI導入を検討する際の重要な要素である処理速度とコスト効率性において、Groqの技術は明確なアドバンテージを提供しており、これが文章生成AI普及の加速要因となっています。

精度を維持した高速処理の実現

AI処理において最も重要な課題の一つは、精度を犠牲にすることなく高速処理を実現することです。従来のソリューションでは、処理速度を向上させるために精度を妥協するか、高精度を維持するために処理時間を犠牲にするかの二者択一を迫られることが多くありました。

Groqは独自開発したLPU(Language Processing Unit)アーキテクチャにより、精度を一切妥協することなく圧倒的な高速処理を実現しています。この技術革新により、従来不可能とされていた大規模言語モデルのリアルタイム推論処理が現実のものとなりました。

Groqの処理能力は、従来のGPUベースソリューションと比較して10倍以上の高速化を実現しながら、同等またはそれ以上の精度を維持することが可能です。

この技術的優位性は以下の要素によって支えられています:

- 専用アーキテクチャ設計:AI推論処理に特化した回路設計により無駄を排除

- メモリ効率性:データアクセスパターンを最適化し、メモリボトルネックを解消

- 並列処理最適化:言語モデルの特性に合わせた並列処理アルゴリズムを実装

- 低消費電力設計:高性能と省エネルギーを両立する革新的な設計思想

これらの技術的特徴により、Groqは従来の処理速度と精度のトレードオフという制約を克服し、AI市場において新たなスタンダードを確立しつつあります。特にリアルタイム性が求められるアプリケーションや大規模なAIサービスにおいて、その価値は計り知れないものとなっています。

Groqの実際の使用方法とインターface

Groqの高速AI推論チップを活用するためには、その具体的な使用方法とインターフェースを理解することが重要です。Groqは従来のGPUとは異なるアーキテクチャを採用しており、独自の開発環境とAPIを提供しています。ここでは、実際にGroqを使用する際の手順から、提供されているインターフェースの詳細まで、実践的な観点から解説していきます。

GroqCloudの基本的な使用手順

Groqを使用する最も一般的な方法は、GroqCloudプラットフォームを通じたAPIアクセスです。まず、GroqCloudのWebサイトでアカウントを作成し、APIキーを取得する必要があります。

- アカウント登録とAPIキー取得

- 開発環境のセットアップ

- SDKまたはHTTPクライアントの設定

- 推論リクエストの実装

- レスポンスの処理

基本的なAPIリクエストの例は以下の通りです:

import groq

client = groq.Groq(api_key="your-api-key")

response = client.chat.completions.create(

model="llama2-70b-4096",

messages=[

{"role": "user", "content": "Hello, Groq!"}

]

)

print(response.choices[0].message.content)

対応モデルとパラメータ設定

Groqプラットフォームでは、複数の大規模言語モデルをサポートしており、それぞれ異なる特性と用途に最適化されています。主要なモデルには、LLaMA系列やMixtral系列などが含まれます。

| モデル名 | パラメータ数 | コンテキスト長 | 主な用途 |

|---|---|---|---|

| llama2-70b-4096 | 70B | 4,096トークン | 汎用的な対話・生成 |

| mixtral-8x7b-32768 | 8x7B | 32,768トークン | 長文処理・複雑なタスク |

各モデルは、temperature、max_tokens、top_pなどのパラメータで出力を制御できます。これらのパラメータを適切に設定することで、用途に応じた最適な結果を得ることができます。

REST APIインターフェースの詳細

GroqのREST APIは、OpenAI API互換の設計となっており、既存のOpenAI統合からの移行が容易です。主要なエンドポイントは以下の通りです:

- /v1/chat/completions – チャット形式での推論実行

- /v1/models – 利用可能なモデル一覧の取得

- /v1/audio/transcriptions – 音声転写サービス

APIリクエストには適切なヘッダーの設定が必要で、特にAuthorizationヘッダーにAPIキーを含める必要があります:

curl -X POST "https://api.groq.com/openai/v1/chat/completions" \

-H "Authorization: Bearer $GROQ_API_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "llama2-70b-4096",

"messages": [{"role": "user", "content": "Hello!"}],

"temperature": 0.7

}'

SDKとライブラリの活用

Groqは複数のプログラミング言語向けのSDKを提供しており、開発者は自分の環境に最適なツールを選択できます。Python SDKが最も充実しており、非同期処理やストリーミングレスポンスにも対応しています。

Python SDK以外にも、JavaScript/TypeScript、Go、Java向けのライブラリも利用可能です。これらのSDKを使用することで、エラーハンドリング、レート制限の管理、自動リトライ機能などが簡単に実装できます。

ストリーミングレスポンスを使用する場合の実装例:

stream = client.chat.completions.create(

model="llama2-70b-4096",

messages=[{"role": "user", "content": "長い回答を生成してください"}],

stream=True

)

for chunk in stream:

if chunk.choices[0].delta.content:

print(chunk.choices[0].delta.content, end="")

モニタリングと使用量管理

Groqプラットフォームでは、リアルタイムでの使用量監視と詳細な分析機能を提供しています。ダッシュボードを通じて、リクエスト数、レスポンス時間、トークン使用量、エラー率などの重要な指標を確認できます。

また、使用量制限の設定やアラート機能により、予期しない課金を防ぐことができます。開発チーム向けには、複数のAPIキーを管理し、プロジェクトごとの使用量を分離する機能も提供されています。

これらの包括的なインターフェースと管理機能により、Groqは企業レベルでの本格的なAIアプリケーション開発にも対応できる堅牢なプラットフォームとなっています。

Groqの料金体系と利用プラン

Groqは高速なAI推論処理を実現するプラットフォームとして、多様なAIモデルに対応した柔軟な料金体系を提供しています。従来のクラウドサービスとは異なり、処理速度と コストパフォーマンスの両立を重視した価格設定となっており、開発者や企業のニーズに応じて最適なプランを選択できます。料金は主にモデルの種類と処理量に基づいて算出され、透明性の高い従量課金制を採用しています。

大規模言語モデル(LLM)の料金

Groqの大規模言語モデルサービスは、テキスト生成や自然言語処理タスクを高速で実行できる料金プランを提供しています。トークン単位での従量課金制を採用しており、入力トークンと出力トークンそれぞれに対して料金が設定されています。

料金体系の特徴として、以下の点が挙げられます:

- 入力トークンと出力トークンの料金が明確に分離されている

- モデルサイズや性能に応じた段階的な価格設定

- 大量利用時の割引制度の適用

- リアルタイム処理における高速レスポンスの保証

また、開発者向けには無料利用枠も提供されており、プロトタイプ開発や小規模なテストには十分な容量が確保されています。商用利用の場合は、月間の処理量に応じてスケールする柔軟な価格体系となっており、スタートアップから大企業まで幅広く対応可能です。

音声認識(ASR)モデルの料金

Groqの音声認識サービスは、音声データをテキストに変換する高精度なASRモデルを提供しており、処理時間に基づいた料金体系を採用しています。従来の音声認識サービスと比較して、大幅に高速化された処理能力により、リアルタイム音声認識にも対応しています。

ASRモデルの料金構成は以下のような要素で決定されます:

- 音声データの処理時間(秒単位での課金)

- 音声品質や言語の複雑さによる処理負荷

- リアルタイム処理の有無

- カスタムモデルの利用料金

特に注目すべき点は、バッチ処理とリアルタイム処理で異なる料金設定がなされていることです。バッチ処理では大量の音声データを効率的に処理できる低コストプランが、リアルタイム処理では即座にテキスト変換を行う高速プランが用意されています。また、多言語対応や専門用語辞書の利用についても、追加オプションとして料金が設定されています。

画像処理モデルの料金

Groqの画像処理サービスでは、画像認識、物体検出、画像生成などの多様なコンピュータビジョンタスクに対応したモデルを提供しており、処理する画像の枚数と解像度に応じた料金体系を設定しています。高速なハードウェアによる並列処理により、大量の画像処理も効率的に実行できます。

画像処理モデルの料金は、以下の要因によって算出されます:

| 料金要素 | 詳細 |

|---|---|

| 画像解像度 | 処理する画像のピクセル数に応じた段階的料金 |

| 処理タイプ | 認識、検出、生成など処理の複雑さによる差別化 |

| バッチサイズ | 同時処理する画像数による効率化割引 |

| カスタムモデル | 専用学習済みモデルの利用料金 |

画像処理においても、開発者向けの無料利用枠が提供されており、APIテストや小規模プロジェクトでの利用が可能です。商用利用の場合は、月間処理枚数に応じたボリュームディスカウントが適用され、大規模な画像処理プロジェクトにおいてもコスト効率の良い運用が実現できます。また、高解像度画像や複雑な処理については追加料金が発生する場合があるため、利用前の料金シミュレーションが推奨されています。

各種生成AIサービスとの回答速度検証

生成AIの実用性を評価する上で、回答速度は重要な指標の一つです。特にgroqは、その超高速な推論処理能力で注目を集めています。本章では、groqと他の主要な生成AIサービスとの回答速度を具体的なユースケース別に検証し、どのような場面でgroqの優位性が発揮されるかを詳しく解析していきます。

マーケティングコピー生成での比較

マーケティングコピーの生成は、企業の日常業務で頻繁に発生するタスクの一つです。groqの高速処理能力がこの分野でどの程度の効果を発揮するかを検証しました。

検証では、同一の商品説明文からキャッチコピーを生成するタスクを複数の生成AIサービスで実行しました。groqは平均0.8秒で完了し、他の主要サービスが3-5秒を要する中で圧倒的な速度を示しました。この速度差は、リアルタイムでの提案や複数パターンの生成において大きなアドバンテージとなります。

| サービス名 | 平均処理時間 | 品質評価 |

|---|---|---|

| groq | 0.8秒 | 優秀 |

| サービスA | 3.2秒 | 優秀 |

| サービスB | 4.7秒 | 良好 |

また、groqの高速性により、マーケティングチームは短時間で多数のバリエーションを生成し、A/Bテスト用の素材を効率的に準備できることが確認されました。

マーケティング関連質問での性能差

マーケティング戦略の立案や市場分析に関する質問応答では、スピードと正確性の両立が求められます。groqがこの領域でどの程度の性能を発揮するかを詳細に検証しました。

検証項目には以下のような実践的なマーケティング質問を含めました:

- ターゲット顧客の分析と提案

- 競合他社との差別化戦略

- SNSマーケティングの施策提案

- ROI向上のための改善案

結果として、groqは複雑なマーケティング質問に対しても平均1.5秒以内で回答を生成し、他サービスの5-8秒と比較して大幅な時間短縮を実現しました。特に注目すべきは、回答の質についても他サービスと遜色ない水準を維持していることです。

groqの高速処理により、マーケティング会議中のリアルタイム質問対応や、クライアントプレゼンテーション中の即座な戦略提案が可能になります。

この性能差は、マーケティング業務の効率化において従来の作業フローを根本的に変革する可能性を秘めています。

専門分野(医療)での回答品質と速度

医療分野のような高度な専門知識を要する領域では、生成AIの回答品質と処理速度の両立がより一層重要になります。groqの医療分野での性能を他サービスと比較検証しました。

医療関連の質問検証では、以下のカテゴリーで性能を測定しました:

- 基本的な医学用語の説明

- 症状に基づく一般的な情報提供

- 医療制度や手続きに関する質問

- 最新の医療技術に関する解説

groqは医療分野においても優れた速度性能を発揮し、平均2.1秒で専門的な回答を生成しました。一方、他サービスは7-12秒を要する結果となり、groqの処理速度の優位性が専門分野でも確認されました。

回答品質については、医療従事者による評価を実施した結果、groqの回答は正確性と信頼性の両面で高い評価を獲得しました。ただし、医療分野では必ず専門医への相談を促す注意喚起も適切に含まれており、責任ある回答姿勢も評価されました。

特に緊急性を要する医療情報の検索や、医療従事者の業務支援において、groqの高速性は実用的な価値を提供することが実証されました。

GroqのAIチップ技術とGPU代替の可能性

AI処理の高速化において、従来のGPUに代わる革新的な技術として注目を集めているのがGroqのAIチップ技術です。Groqが開発するLanguage Processing Unit(LPU)は、大規模言語モデルの推論処理において従来のGPUを大幅に上回る性能を実現し、AI業界に新たな可能性をもたらしています。

Groq LPUの革新的なアーキテクチャ

GroqのLPU(Language Processing Unit)は、従来のGPUとは根本的に異なるアーキテクチャを採用しています。GPUが並列処理に特化した設計である一方、LPUは順次処理に最適化されており、言語モデルの推論処理において圧倒的な優位性を発揮します。

LPUの最大の特徴は、メモリアクセスパターンの最適化にあります。従来のGPUでは、大量のデータを並列処理する際にメモリボトルネックが発生しやすく、実際の計算能力を十分に活用できないケースが多く見られました。これに対してGroqのLPUは、以下の技術的優位性を持っています:

- 予測可能なメモリアクセスパターンによる高効率化

- 低レイテンシーでの推論処理実現

- エネルギー効率の大幅な改善

- スケーラブルなアーキテクチャ設計

GPU vs LPU:性能比較と実用性

実際の性能比較において、GroqのLPUは特定の用途でGPUを大幅に上回る結果を示しています。特に大規模言語モデルの推論処理では、従来のGPUと比較して数倍から数十倍の高速化を実現するケースが報告されています。

| 比較項目 | 従来GPU | Groq LPU |

|---|---|---|

| 推論速度 | 標準 | 10-100倍高速 |

| レイテンシー | 中程度 | 超低レイテンシー |

| エネルギー効率 | 標準 | 大幅改善 |

| コスト効率 | 高コスト | コスト削減可能 |

しかし、LPUにも制限があります。GPUが汎用的な並列処理に優れている一方、LPUは言語処理に特化しているため、用途が限定されるという特徴があります。そのため、完全にGPUを代替するのではなく、用途に応じた使い分けが重要となります。

産業界への影響とGPU代替シナリオ

GroqのAIチップ技術は、AI産業全体に大きな変革をもたらす可能性を秘めています。特にリアルタイム推論が重要視される分野において、その影響は計り知れません。

現在、多くの企業がGPUクラスターを使用してAIサービスを提供していますが、Groqの技術により以下のような変化が期待されます:

- チャットボット・対話AI分野:超低レイテンシーにより、より自然な対話体験の実現

- リアルタイム翻訳サービス:瞬時の言語変換による国際コミュニケーションの革新

- コンテンツ生成プラットフォーム:高速なテキスト・コード生成による生産性向上

- エッジコンピューティング:低消費電力での高性能AI処理の実現

特に、従来のGPUベースのインフラストラクチャでは実現困難だった、リアルタイム性を重視するアプリケーションにおいて、GroqのLPUは革命的な変化をもたらすと期待されています。

現在のAI推論処理におけるコスト構造は、主にGPUの計算リソースとエネルギー消費に依存している。GroqのLPU技術により、これらのコストが大幅に削減される可能性がある。

ただし、GPU代替の完全な実現には時間が必要です。現在のAIエコシステムは主にGPU向けに最適化されており、LPUへの移行には既存システムの再設計やソフトウェアスタックの対応が必要となります。そのため、段階的な導入と並行運用が現実的なシナリオとして考えられています。

Groqの企業戦略と市場での立ち位置

AI処理専用チップの開発で注目を集めるGroqは、従来のGPU中心のAI処理アーキテクチャに革新をもたらす企業として、独自の市場ポジションを確立しています。同社は高速推論処理に特化したLPU(Language Processing Unit)技術を武器に、AI業界における新たな競争軸を創出し、既存の大手プレイヤーとは異なるアプローチで市場参入を果たしています。

Groqの戦略的優位性は、超高速なAI推論処理を実現する独自ハードウェア設計にあります。従来のGPUベースのシステムと比較して、大幅な処理速度向上を実現することで、リアルタイム応答が求められるAIアプリケーション市場での差別化を図っています。この技術的アドバンテージにより、クラウドAIサービス市場において独自のニッチを開拓し、大手クラウドプロバイダーとの直接競合を避けながら成長を続けています。

優秀な人材確保による組織強化

Groqの急速な技術革新と市場展開を支えているのは、戦略的な人材獲得戦略です。同社は設立以来、半導体設計、AI研究、システムアーキテクチャの各分野でトップクラスの専門家を積極的にリクルートし、技術的優位性の維持・拡大に努めています。

特に注目すべきは、GoogleやNVIDIAなどの大手テック企業から経験豊富なエンジニアを引き抜いている点です。これらの人材は既存のAI処理技術の限界を熟知しており、Groqの革新的なアプローチに貢献する貴重な知見を持っています。組織強化の具体的な取り組みとして、以下のような人材戦略を展開しています:

- 半導体設計の第一人者を技術顧問として招聘

- 機械学習フレームワーク開発の専門家チーム構築

- クラウドインフラストラクチャ設計のベテランエンジニア採用

- AIアプリケーション開発者向けのDeveloper Relations強化

さらに、Groqは社内の技術文化を重視し、エンジニア主導の意思決定プロセスを確立しています。これにより、市場の技術的ニーズに対して迅速かつ柔軟に対応できる組織体制を構築し、競合他社との技術開発競争において優位性を維持しています。

コンピューティングコスト削減への取り組み

AI処理におけるコンピューティングコストの削減は、Groqのビジネスモデルの中核を成す重要な価値提案です。従来のGPUベースのAI処理システムでは、高い電力消費と処理遅延がコスト増大の主要因となっていましたが、Groqの独自技術はこれらの課題を根本的に解決するアプローチを提供しています。

Groqのコスト削減効果は、主に処理効率の大幅な向上によって実現されています。同社のLPU技術は、AI推論処理に最適化された専用アーキテクチャにより、従来システムと比較して大幅な電力効率改善を達成しています。これにより、企業顧客は同等の処理性能をより低いランニングコストで実現できるようになります。

コスト削減への具体的な取り組みには以下が含まれます:

- 電力効率の最適化:専用チップ設計により、同等処理に必要な電力を大幅削減

- 処理速度の向上:高速推論により、同じタスクをより短時間で完了

- インフラコスト削減:高効率処理により必要なハードウェア台数を削減

- 運用コスト最適化:シンプルなアーキテクチャによるメンテナンス負荷軽減

特に大規模なAIワークロードを運用する企業にとって、Groqのソリューションは従来のクラウドAIサービスと比較して、大幅なコスト削減効果をもたらす可能性があります。この経済的メリットは、AI技術の普及とスケールアップを加速する重要な要素として、多くの企業から注目を集めています。

NVIDIA競合としてのGroqの将来性

AI処理チップ市場においてNVIDIAが圧倒的な地位を築く中、新興企業Groqが独自のアーキテクチャで注目を集めています。Groqは従来のGPUとは根本的に異なるLPU(Language Processing Unit)という革新的なプロセッサを開発し、AI推論処理において圧倒的な高速化を実現しています。

Groqの技術的優位性とNVIDIAとの差別化

GroqのLPUアーキテクチャは、AI推論処理に特化した設計により、従来のGPUベースのソリューションと比較して大幅な性能向上を実現しています。最も重要な差別化要因は処理の予測可能性にあります。

- 決定論的実行モデルによる一貫した処理時間の実現

- メモリアクセスパターンの最適化による低レイテンシ

- 大規模言語モデルの推論処理に最適化されたハードウェア設計

- エネルギー効率の大幅な改善

NVIDIAのGPUが汎用的な並列処理に優れている一方で、GroqのLPUは言語処理タスクに特化した専用設計により、特定の用途において圧倒的な性能を発揮します。

市場参入戦略と競争優位性の構築

Groqは既存のAI処理市場において独自のポジションを確立するため、戦略的なアプローチを採用しています。同社は大規模言語モデルの推論処理に焦点を絞ることで、急成長するAIアプリケーション市場でのニッチを狙っています。

| 競争要因 | Groq LPU | NVIDIA GPU |

|---|---|---|

| 推論速度 | 超高速(特化設計) | 高速(汎用設計) |

| レイテンシ | 極めて低い | 比較的低い |

| 予測可能性 | 決定論的 | 確率的 |

| エネルギー効率 | 最適化済み | 改善中 |

特にリアルタイム応答が求められるチャットボットや音声アシスタントなどの用途において、Groqの技術的優位性は明確に現れています。

将来的な成長可能性と市場展望

AI市場の急速な拡大に伴い、Groqの将来性は複数の要因によって支えられています。生成AIアプリケーションの普及により、推論処理の需要は exponential に増加しており、専用ハードウェアへのニーズも高まっています。

まず、エッジコンピューティング市場での可能性が注目されています。Groqの低レイテンシ・高効率な処理能力は、クラウドからエッジへのAI処理の移行トレンドと完全に合致しています。

- リアルタイムAIアプリケーションの増加

- プライバシー重視によるローカル処理需要の拡大

- 5G・6G通信インフラの発展に伴う新たな用途の創出

- 自動運転・ロボティクス分野での応用可能性

一方で、NVIDIAの強固なエコシステムと資金力という課題も存在します。ソフトウェア開発者コミュニティの構築や企業との戦略的パートナーシップが、Groqの長期的成功の鍵となるでしょう。

「AI推論処理市場は今後10年間で爆発的な成長が予想され、専用ハードウェアの需要は多様化していくと考えられます。Groqのような特化型ソリューションが果たす役割は、ますます重要になるでしょう。」

Groqの将来性は、AI処理の専門化トレンドと密接に関連しています。汎用的なソリューションから特化型ソリューションへの市場の移行が進む中、同社の技術的優位性は持続可能な競争優位性を構築する可能性を秘めています。