PythonでAI開発を始めたい初心者向けに、開発の5つのステップから実践的な学習方法まで解説します。機械学習の基礎知識、NumPyやPandasなどの必須ライブラリ、データ準備からモデル作成・検証までの具体的な手順が学べます。なぜPythonがAI開発に適しているのか、独学での実現可能性、効果的な勉強法についても詳しく紹介し、AI開発の第一歩を踏み出すための悩みを解決します。

“`html

目次

PythonとAI(人工知能)の基礎知識

AI開発の世界に足を踏み入れる際、Pythonという言語が圧倒的な支持を集めています。しかし、そもそもPythonとは何なのか、AIとはどのような技術なのか、基礎的な知識を正しく理解することが重要です。このセクションでは、PythonとAI開発に関わる基本的な概念について、初心者の方にも分かりやすく解説していきます。

Pythonとは何か

Pythonは、1991年にオランダ人プログラマーのGuido van Rossumによって開発されたプログラミング言語です。シンプルで読みやすい文法が特徴で、初心者から上級者まで幅広く利用されています。

Pythonの最大の特徴は、コードの可読性の高さにあります。他のプログラミング言語と比較して、英語に近い自然な記述ができるため、プログラミング初心者でも理解しやすいという利点があります。また、インデント(字下げ)を使ってコードのブロックを表現するため、視覚的にも構造が把握しやすくなっています。

現在Pythonは、Web開発、データ分析、AI開発、科学技術計算など、多岐にわたる分野で活用されています。特にAI開発においては事実上の標準言語として位置づけられており、世界中の研究者や開発者がPythonを使ってAIシステムを構築しています。

- 文法がシンプルで学習コストが低い

- 豊富なライブラリとフレームワークが利用可能

- クロスプラットフォーム対応で様々な環境で動作

- 大規模なコミュニティによるサポート体制

- オープンソースで無償利用が可能

AI(人工知能)の定義と概要

AI(Artificial Intelligence:人工知能)とは、人間の知的な振る舞いをコンピュータで再現する技術のことを指します。具体的には、学習、推論、判断、認識といった人間の知的活動を、コンピュータプログラムによって実現しようとする研究分野です。

AIの概念自体は1950年代から存在していましたが、近年のコンピュータ性能の飛躍的な向上と大量のデータ活用が可能になったことで、実用的なAIシステムが次々と登場しています。現在では、画像認識、音声認識、自然言語処理、推薦システムなど、私たちの日常生活の様々な場面でAI技術が活用されています。

AIは大きく分けて以下のように分類されます。

- 弱いAI(特化型AI):特定のタスクに特化したAIで、現在実用化されているほとんどのAIがこれに該当します

- 強いAI(汎用AI):人間のようにあらゆるタスクに対応できる汎用的なAIで、現時点では実現されていません

また、AIを実現するための具体的な手法として、機械学習やディープラーニングといった技術が中心的な役割を果たしています。これらの技術により、コンピュータはデータからパターンを学習し、未知のデータに対しても適切な判断や予測を行えるようになります。

機械学習とディープラーニングの違い

AIを実現するための主要な技術として、機械学習とディープラーニングがありますが、これらは似て非なるものです。それぞれの特徴と違いを正しく理解することが、AI開発を進める上で重要になります。

機械学習(Machine Learning)は、データからパターンやルールを自動的に学習する技術の総称です。従来のプログラミングでは人間が明示的にルールを記述する必要がありましたが、機械学習ではデータを与えることでコンピュータ自身がルールを見つけ出します。

機械学習では、人間が特徴量(データの重要な特性)を選択・設計する必要があります。例えば、スパムメールを判定するシステムを作る場合、「特定のキーワードが含まれているか」「送信者のアドレス形式」など、判断に必要な要素を人間が定義します。

一方、ディープラーニング(Deep Learning:深層学習)は、機械学習の一手法であり、人間の脳の神経回路を模したニューラルネットワークを多層化した技術です。特徴量の抽出までも自動的に学習できる点が最大の特徴です。

| 比較項目 | 機械学習 | ディープラーニング |

|---|---|---|

| 特徴量の設計 | 人間が手動で設計 | 自動的に学習 |

| 必要なデータ量 | 比較的少量でも可能 | 大量のデータが必要 |

| 計算コスト | 比較的低い | 高い(GPU等が必要) |

| 精度 | タスクによる | 複雑なタスクで高精度 |

| 解釈性 | 比較的高い | ブラックボックス化しやすい |

画像認識や音声認識など、複雑で高次元のデータを扱う場合には、ディープラーニングが優れた性能を発揮します。一方、データ量が限られている場合や、結果の解釈性が重要な場合には、従来の機械学習手法が適していることもあります。

AI・機械学習・ディープラーニングの関係性

AI、機械学習、ディープラーニングの関係性を正しく理解することで、AI開発の全体像が見えてきます。これらは別々の技術ではなく、包含関係にある概念です。

最も大きな概念がAI(人工知能)です。AIは人間の知的活動をコンピュータで再現するという広範な研究分野全体を指します。この中には、ルールベースのシステムや探索アルゴリズムなど、様々なアプローチが含まれます。

機械学習は、AIを実現するための主要な手法の一つです。データから自動的にパターンを学習することで、明示的なプログラミングなしに問題を解決します。現代のAIシステムの多くは機械学習に基づいて構築されています。

そして、ディープラーニングは機械学習の一種であり、多層のニューラルネットワークを用いた学習手法です。特に2012年以降、画像認識コンテストで圧倒的な成績を収めたことをきっかけに、AI技術の飛躍的な進歩を牽引してきました。

この関係性は、以下のように表現できます。

- AI(人工知能):最も広い概念で、人間の知的活動を模倣する技術全般

- 機械学習:AIの部分集合で、データから学習する手法

- ディープラーニング:機械学習の部分集合で、多層ニューラルネットワークを用いる手法

Pythonを使ったAI開発では、これらすべての階層において強力なツールが提供されています。ルールベースのAIシステムから、最先端のディープラーニングモデルまで、Pythonを使えば幅広いAI技術を実装することが可能です。

このような関係性を理解することで、「AIを開発したい」という目標に対して、どのようなアプローチを選択すべきか、どのPythonライブラリを使用すべきかといった判断が的確にできるようになります。問題の性質やデータの特性に応じて、適切な技術を選択することが成功の鍵となります。

“`

“`html

AI開発にPythonが選ばれる理由

AI開発の現場では、プログラミング言語の中でもPythonが圧倒的なシェアを誇っています。その背景には、技術的な優位性だけでなく、開発者を取り巻くエコシステム全体の充実があります。ここでは、なぜPythonがAI開発のデファクトスタンダードとなったのか、その具体的な理由を詳しく解説します。

豊富なライブラリとフレームワークの存在

PythonがAI開発で選ばれる最大の理由の一つは、機械学習やディープラーニングに特化した豊富なライブラリとフレームワークが揃っていることです。

数値計算のためのNumPyやPandas、機械学習のためのscikit-learn、深層学習のためのTensorFlowやPyTorchなど、目的に応じた強力なツールが無償で利用できます。これらのライブラリは高度に最適化されており、複雑な数学的処理を数行のコードで実装できるため、開発者はアルゴリズムの細部よりも問題解決に集中できます。

また、これらのライブラリは相互に連携しやすい設計になっており、データの前処理から学習、評価までを一貫したワークフローで構築できる点も大きな利点です。このエコシステムの充実度は他の言語では実現できないレベルに達しています。

初心者にも読み書きしやすいコードの特徴

Pythonの文法はシンプルで直感的に理解しやすいという特徴があります。英語に近い記述方法と明確なインデントによる構造化により、プログラミング初心者でもコードの意味を理解しやすくなっています。

他の言語では複雑な記述が必要な処理も、Pythonでは少ないコード量で実現できます。例えば、変数の型宣言が不要な動的型付けや、セミコロンなどの記号を省略できる仕様により、コードの可読性が高まります。これは特にAI開発において重要です。なぜなら、研究者やデータサイエンティストの中にはプログラミングが専門ではない人も多く、彼らでも扱いやすい言語が求められるからです。

コードの保守性や共同開発のしやすさも評価されており、チーム開発においても一貫したコード品質を保ちやすい言語となっています。

科学技術計算分野での優位性

Pythonは元々科学技術計算の分野で広く採用されてきた歴史があり、AI開発に必要な数学的処理やデータ解析の基盤が整っています。

行列計算、統計処理、微分積分などの高度な数学的操作を効率的に実行できるライブラリが充実しており、AI開発で頻繁に使用される線形代数やベクトル演算を高速に処理できます。特にNumPyは、C言語で実装された高速な演算処理を提供しており、大量のデータを扱うAI開発において性能面でも実用的です。

また、データの可視化ツールも豊富で、学習過程の分析やモデルの評価結果を視覚的に確認できる環境が整っています。こうした科学技術計算のエコシステムが既に確立されていたことが、AI分野でのPython採用を加速させました。

大手企業での採用実績と信頼性

GoogleやFacebook(Meta)、Microsoftといった世界的なテクノロジー企業がPythonをAI開発の主要言語として採用している事実は、信頼性の証明となっています。

Googleが開発したTensorFlowや、Facebookが開発したPyTorchなど、業界をリードするディープラーニングフレームワークがPythonで提供されています。これらの企業は自社のAIサービスやプロダクト開発にPythonを活用しており、実際のビジネスレベルで十分な性能と信頼性が実証されています。

国内においても、大手IT企業やスタートアップ企業の多くがPythonを採用しており、求人市場においてもPythonスキルを持つAIエンジニアの需要は高まり続けています。このような実績は、技術選定において重要な判断材料となります。

充実した情報量とコミュニティのサポート

Pythonには世界中に巨大な開発者コミュニティが存在し、問題解決のための情報が豊富に蓄積されています。

Stack OverflowやGitHub、Qiitaなどのプラットフォームには、AI開発に関する質問と回答が大量に投稿されており、初心者が直面する問題のほとんどは既に解決策が公開されています。また、公式ドキュメントや技術ブログ、YouTubeの解説動画など、学習リソースも日本語・英語ともに充実しています。

オープンソースコミュニティの活発な活動により、ライブラリやフレームワークは継続的に改善され、最新の研究成果も迅速に実装されて公開されます。このようなコミュニティのサポート体制は、開発者が孤立せず、常に最新の情報にアクセスできる環境を提供しています。

オープンソースで無料で始められる環境

Python本体およびAI開発に必要なほぼすべてのライブラリはオープンソースとして無償で提供されており、コストをかけずに開発を始められます。

商用利用においてもライセンス料が不要なため、個人の学習からスタートアップの製品開発、大企業のシステム構築まで、あらゆる規模のプロジェクトで採用できます。また、Google Colaboratoryのような無料のクラウド開発環境も提供されており、高価なGPUマシンを購入しなくても本格的なディープラーニング開発が可能です。

このような参入障壁の低さは、AI技術の民主化に大きく貢献しており、多様なバックグラウンドを持つ人々がAI開発に参加できる環境を生み出しています。初期投資を抑えながら技術検証や概念実証を行えることは、ビジネス面でも大きなメリットとなります。

“`

“`html

機械学習の基本的なしくみ

機械学習は、AI開発における中核的な技術であり、Pythonを使ったAI開発を理解する上で欠かせない要素です。コンピュータがデータから自動的にパターンを学習し、予測や判断を行えるようにする技術で、学習方法によっていくつかの種類に分類されます。ここでは、機械学習の基本的なしくみと、実践で必要となるデータの扱い方やモデルの評価方法について解説していきます。

教師あり学習の概要

教師あり学習は、正解ラベル付きのデータを使ってモデルを学習させる手法です。入力データと対応する正解(出力)のペアを大量に用意し、その関係性をコンピュータに学習させます。例えば、メールがスパムかどうかを判定するシステムを作る場合、過去のメールデータに「スパム」「スパムではない」というラベルを付けて学習させることで、新しいメールに対しても判定できるようになります。

教師あり学習は大きく2つのタイプに分類されます。1つ目は分類問題で、データをいくつかのカテゴリーに分ける作業です。画像が猫か犬かを判定したり、顧客が商品を購入するかどうかを予測したりする場合に使われます。2つ目は回帰問題で、連続的な数値を予測する作業です。不動産の価格予測や売上予測などがこれに該当します。

Pythonでは、scikit-learnなどのライブラリを使って、線形回帰、ロジスティック回帰、決定木、ランダムフォレスト、サポートベクターマシンなど、様々な教師あり学習のアルゴリズムを簡単に実装できます。

教師なし学習の概要

教師なし学習は、正解ラベルがないデータから、隠れたパターンや構造を発見する手法です。データそのものの特徴や関係性を分析し、意味のあるグループ分けや次元削減を行います。事前に正解を用意する必要がないため、大量の未分類データを活用できる点が特徴です。

代表的な教師なし学習の手法として、クラスタリングがあります。これは似た特徴を持つデータを自動的にグループ化する技術で、顧客セグメンテーションや画像のグループ分けなどに活用されます。K-means法や階層的クラスタリングなどのアルゴリズムがよく使われます。

もう1つの重要な手法が次元削減です。高次元のデータから重要な特徴だけを抽出し、より少ない変数で表現する技術で、データの可視化や計算効率の向上に役立ちます。主成分分析(PCA)やt-SNEなどが代表的なアルゴリズムです。その他にも、異常検知やアソシエーション分析など、様々な用途で教師なし学習が活用されています。

強化学習の概要

強化学習は、試行錯誤を通じて最適な行動を学習する手法です。エージェント(学習主体)が環境と相互作用しながら、報酬を最大化するような行動方針を獲得していきます。教師あり学習のように正解データを与えるのではなく、行動の結果に対する「報酬」という形でフィードバックを与える点が特徴的です。

強化学習の基本的な構造は、エージェント、環境、状態、行動、報酬の5つの要素から成り立っています。エージェントは現在の状態を観察し、その状態で取るべき行動を選択します。行動の結果、環境の状態が変化し、エージェントは報酬を受け取ります。このプロセスを繰り返すことで、長期的に最も高い報酬が得られる行動方針を学習していきます。

強化学習は、ゲームAI、ロボット制御、自動運転、金融取引の最適化など、幅広い分野で応用されています。AlphaGoが囲碁のトッププロ棋士に勝利したことでも注目を集めました。Pythonでは、OpenAI GymやStable Baselines3などのライブラリを使って、強化学習のアルゴリズムを実装できます。Q学習、Deep Q-Network(DQN)、Policy Gradientなど、様々なアルゴリズムが開発されています。

学習用データと検証用データの分け方

機械学習モデルを適切に構築するためには、データを学習用と検証用に分割することが非常に重要です。すべてのデータを学習に使ってしまうと、モデルが学習データに過剰適合(過学習)してしまい、未知のデータに対する予測性能が低下する可能性があります。

一般的なデータ分割の方法として、ホールドアウト法があります。これは全データをランダムに学習用と検証用(テスト用)に分割する方法で、典型的には学習用70~80%、検証用20~30%の割合で分けます。Pythonのscikit-learnライブラリでは、train_test_split関数を使って簡単にデータを分割できます。

より精度の高い評価を行いたい場合は、交差検証(クロスバリデーション)という手法を用います。データを複数のグループに分割し、そのうち1つを検証用、残りを学習用として使用します。これを各グループが1度ずつ検証用になるように繰り返し、平均的な性能を評価します。k分割交差検証が一般的で、kには5や10がよく使われます。

さらに本格的な開発では、データを学習用、検証用、テスト用の3つに分割することもあります。検証用データでモデルのパラメータ調整を行い、最終的な性能評価は一度も学習に使っていないテスト用データで行うことで、より客観的な評価が可能になります。

モデルの評価方法

機械学習モデルの性能を適切に評価することは、実用的なAIシステムを構築する上で不可欠です。評価指標は問題の種類(分類か回帰か)や目的によって使い分ける必要があります。

分類問題の基本的な評価指標として、正解率(Accuracy)があります。全予測のうち正解した割合を示しますが、データに偏りがある場合は適切な評価にならないことがあります。例えば、100件中95件が正常で5件が異常のデータで「すべて正常」と予測しても正解率95%となってしまいます。

そのため、より詳細な評価には適合率(Precision)、再現率(Recall)、F値などが使われます。適合率は「陽性と予測したもののうち実際に陽性だった割合」、再現率は「実際の陽性のうち正しく検出できた割合」を示します。F値はこれら2つの調和平均です。また、混同行列(Confusion Matrix)を用いることで、どのような誤りが多いのかを視覚的に把握できます。

回帰問題では、平均二乗誤差(MSE)、平均絶対誤差(MAE)、決定係数(R²スコア)などが使われます。MSEは予測値と実際の値の差の二乗の平均で、大きな誤差をより重視します。MAEは差の絶対値の平均で、外れ値の影響を受けにくい指標です。R²スコアは0から1の値を取り、1に近いほどモデルの説明力が高いことを示します。

Pythonでは、scikit-learnのmetricsモジュールを使って、これらの評価指標を簡単に計算できます。複数の評価指標を組み合わせて総合的に判断することで、モデルの性能を多角的に評価し、実用に耐えるAIシステムを構築できます。

“`

“`html

深層学習(ディープラーニング)の基礎

深層学習は、現代のAI技術の中核を担う重要な技術です。画像認識、音声認識、自然言語処理など、さまざまな分野で目覚ましい成果を上げています。PythonでAI開発を行う際には、この深層学習の基本的な仕組みを理解することが欠かせません。ここでは、深層学習の概念から実際の学習プロセスまで、体系的に解説していきます。

深層学習とは何か

深層学習(ディープラーニング)とは、人間の脳神経回路を模倣した多層のニューラルネットワークを用いる機械学習の手法です。従来の機械学習では人間が特徴量を手動で設計する必要がありましたが、深層学習では大量のデータからモデル自身が自動的に特徴を抽出・学習できる点が画期的です。

深層学習の「深層」という言葉は、ニューラルネットワークの層が多層構造になっていることを示しています。一般的に、隠れ層が2層以上あるネットワークを深層ニューラルネットワークと呼びます。層を深くすることで、より複雑なパターンや抽象的な概念を学習できるようになります。

深層学習が注目を集めるようになった背景には、以下の3つの要因があります。

- 計算能力の向上: GPUの発展により、大規模な計算が高速に実行できるようになった

- 大量データの利用可能性: インターネットの普及により、学習に必要な膨大なデータが入手可能になった

- アルゴリズムの改良: 逆誤差伝播法やドロップアウトなど、効果的な学習手法が開発された

Pythonで深層学習を実装する際は、TensorFlowやKerasといったフレームワークを使用することで、複雑な計算処理を効率的に記述できます。

ニューラルネットワークの構造

ニューラルネットワークは、人間の脳の神経細胞(ニューロン)の働きを数学的にモデル化したものです。入力層、隠れ層、出力層という3種類の層で構成され、各層は複数のノード(ニューロン)から成り立っています。

ニューラルネットワークの基本構造は以下の通りです。

- 入力層: 学習データを受け取る層で、画像データであればピクセル値、数値データであれば各特徴量がノードに入力されます

- 隠れ層: 入力層と出力層の間に位置し、データの特徴を抽出・変換する役割を担います。深層学習では複数の隠れ層を持ちます

- 出力層: 最終的な予測結果や分類結果を出力する層です

各ノード間は「重み」と呼ばれるパラメータで結ばれています。ノードでは、前の層からの入力値に重みを掛けて合計し、さらに「バイアス」と呼ばれる値を加えた後、活性化関数を通して次の層へ出力します。

活性化関数は、ニューラルネットワークに非線形性を与える重要な要素です。代表的な活性化関数には以下のものがあります。

| 活性化関数 | 特徴 | 主な用途 |

|---|---|---|

| ReLU(Rectified Linear Unit) | 入力が正の値ならそのまま出力、負なら0を出力 | 隠れ層で最も一般的に使用される |

| Sigmoid | 出力を0~1の範囲に変換 | 二値分類の出力層 |

| Softmax | 複数の出力を確率分布に変換 | 多クラス分類の出力層 |

| tanh | 出力を-1~1の範囲に変換 | 隠れ層での使用 |

Pythonでニューラルネットワークを構築する際は、これらの層と活性化関数を組み合わせてモデルを設計します。

深層学習の学習プロセス

深層学習における学習とは、大量の訓練データを用いてニューラルネットワークの重みとバイアスを最適化するプロセスです。この学習は、誤差逆伝播法(Backpropagation)と勾配降下法(Gradient Descent)という2つの主要なアルゴリズムによって実現されます。

深層学習の学習プロセスは、以下のステップで進行します。

- 順伝播(Forward Propagation): 入力データをネットワークに入力し、各層を順に計算して出力層まで値を伝播させます

- 損失の計算: 出力層の予測値と正解ラベルを比較し、損失関数を用いて誤差を計算します

- 逆伝播(Backward Propagation): 計算した誤差を出力層から入力層へ逆向きに伝播させ、各層の重みに対する勾配を求めます

- パラメータの更新: 計算した勾配を使って、重みとバイアスを更新します

- 反復: 上記のプロセスを全ての訓練データに対して繰り返し実行します

訓練データ全体を1回学習することを「1エポック」と呼びます。実際の深層学習では、数十から数百エポックの学習を行うことが一般的です。

また、効率的に学習を進めるために「ミニバッチ学習」という手法が用いられます。これは、訓練データを小さなバッチに分割し、バッチごとにパラメータを更新する方法です。Pythonで実装する際は、バッチサイズを32、64、128などに設定することが多くあります。

学習の進行状況を監視するため、訓練データとは別に検証データを用意し、定期的にモデルの性能を評価することも重要です。これにより、過学習(オーバーフィッティング)を防ぐことができます。

損失関数と重みの更新

損失関数(Loss Function)は、モデルの予測値と正解値の差異を数値化する関数であり、深層学習における学習の指標となります。損失関数の値を最小化することが、深層学習の最終目標です。

タスクの種類によって適切な損失関数は異なります。代表的な損失関数には以下のものがあります。

- 平均二乗誤差(MSE: Mean Squared Error): 回帰問題で使用され、予測値と実際の値の差の二乗の平均を計算します

- 交差エントロピー誤差(Cross Entropy): 分類問題で使用され、予測された確率分布と正解ラベルとの差を測定します

- 二値交差エントロピー(Binary Cross Entropy): 二値分類問題に特化した損失関数です

- カテゴリカル交差エントロピー: 多クラス分類問題で使用されます

重みの更新には、最適化アルゴリズムと呼ばれる手法が用いられます。基本的な勾配降下法では、以下の式で重みを更新します。

新しい重み = 現在の重み - 学習率 × 勾配学習率(Learning Rate)は、1回の更新でどれだけ重みを変化させるかを決定する重要なハイパーパラメータです。学習率が大きすぎると最適解を飛び越えてしまい、小さすぎると学習に時間がかかるという問題があります。

Pythonでの深層学習実装では、基本的な勾配降下法の改良版である以下の最適化アルゴリズムがよく使用されます。

| 最適化アルゴリズム | 特徴 |

|---|---|

| SGD(確率的勾配降下法) | ランダムに選んだデータで勾配を計算し更新する基本的な手法 |

| Momentum | 過去の勾配情報を利用して更新の慣性を持たせる |

| Adam | 学習率を自動調整し、多くの問題で良好な性能を発揮する人気の手法 |

| RMSprop | 各パラメータごとに学習率を適応的に調整する |

| AdaGrad | パラメータごとに異なる学習率を設定する |

Pythonのディープラーニングフレームワークでは、これらの最適化アルゴリズムが実装されており、簡単に利用できます。一般的には、最初にAdamを試してみることが推奨されています。

また、過学習を防ぐための正則化手法として、L1正則化、L2正則化、ドロップアウトなどがあり、これらを損失関数に組み込むことで、より汎化性能の高いモデルを構築できます。

“`

“`html

AI開発で使われる主要なPythonライブラリ

PythonによるAI開発では、目的に応じた専門的なライブラリを活用することで効率的な実装が可能になります。データの前処理から機械学習モデルの構築、深層学習の実装、結果の可視化まで、各段階で最適化されたツールが揃っています。ここでは、AI開発の現場で実際に使われている主要なPythonライブラリについて、それぞれの特徴と用途を詳しく解説します。

NumPy(数値計算ライブラリ)

NumPyは、Pythonにおける数値計算の基盤となるライブラリであり、AI開発に欠かせない存在です。多次元配列(ndarray)を効率的に扱う機能を提供し、大量のデータを高速に処理できる点が最大の特徴となっています。

NumPyの主な機能には以下のようなものがあります。

- 多次元配列オブジェクトによる効率的なデータ管理

- ベクトル演算や行列演算の高速処理

- 統計関数、線形代数計算、乱数生成などの数学関数

- 他のライブラリとの優れた互換性

AI開発では、画像データを配列として扱ったり、機械学習モデルの計算処理を高速化したりする際にNumPyが活用されます。C言語で実装されているため、純粋なPythonコードと比較して数十倍から数百倍の処理速度を実現できます。

Pandas(データ解析ライブラリ)

Pandasは、データの読み込みから加工、分析までを一貫して行えるデータ解析に特化したライブラリです。表形式のデータを扱うDataFrameという独自のデータ構造を持ち、ExcelやCSVファイルのような構造化データを直感的に操作できます。

Pandasが提供する主要な機能は次の通りです。

- CSV、Excel、SQLデータベースなど多様な形式のデータ読み込み

- 欠損値の処理や重複データの削除

- データのフィルタリング、並び替え、集計

- 複数のデータセットの結合やマージ

- 時系列データの処理

AI開発の前処理段階では、Pandasを使ってデータのクレンジングや特徴量エンジニアリングを行います。直感的なコードで複雑なデータ操作が可能なため、データサイエンティストの生産性を大きく向上させるライブラリとして広く利用されています。

Matplotlib(データ可視化ライブラリ)

Matplotlibは、Pythonで最も広く使われているデータ可視化のための総合ライブラリです。グラフや図表を作成する豊富な機能を持ち、データの分布や傾向を視覚的に把握するために活用されます。

Matplotlibで作成できる主な可視化の種類には以下があります。

- 折れ線グラフ、棒グラフ、散布図などの基本的なグラフ

- ヒストグラム、箱ひげ図などの統計的な図表

- ヒートマップや3Dプロットなどの高度な可視化

- 複数のグラフを組み合わせた複合図

AI開発では、データの分布確認、モデルの学習曲線の可視化、予測結果と実測値の比較など、さまざまな場面でMatplotlibが使われます。視覚的にデータやモデルの挙動を理解することで、問題点の早期発見や改善方針の決定が容易になります。また、研究成果の発表や報告書作成の際にも、高品質なグラフを生成できる点が評価されています。

scikit-learn(機械学習ライブラリ)

scikit-learnは、機械学習の実装に特化した最も人気の高いライブラリの一つです。分類、回帰、クラスタリングなど、主要な機械学習アルゴリズムを統一されたインターフェースで提供し、初心者から専門家まで幅広く利用されています。

scikit-learnの主な特徴と機能は以下の通りです。

- 線形回帰、決定木、ランダムフォレスト、サポートベクターマシンなど多様なアルゴリズム

- データの前処理機能(正規化、標準化、エンコーディング)

- モデルの評価指標と交差検証の機能

- 次元削減やテキスト処理のツール

- パイプライン機能による処理の連結

scikit-learnは一貫性のあるAPIデザインを採用しており、fit()メソッドでモデルを学習し、predict()メソッドで予測を行うという統一された操作方法が特徴です。これにより、異なるアルゴリズムを試す際も最小限のコード変更で対応できます。ドキュメントも充実しており、豊富なサンプルコードが用意されているため、機械学習の学習教材としても最適です。

TensorFlow(深層学習フレームワーク)

TensorFlowは、Googleが開発した大規模な深層学習に対応した包括的なフレームワークです。研究開発から本番環境への展開まで、幅広い用途に対応できる柔軟性と拡張性を持ち、世界中の企業や研究機関で採用されています。

TensorFlowの主要な特徴は次の通りです。

- GPU・TPUによる高速な並列計算のサポート

- 大規模データセットに対応した分散学習機能

- モデルの保存と読み込みの標準化

- TensorBoard による学習過程の可視化

- モバイルデバイスやWebブラウザへの展開機能(TensorFlow Lite、TensorFlow.js)

TensorFlowは本番環境での運用を重視した設計となっており、学習したモデルをさまざまなプラットフォームに展開できる点が強みです。画像認識、自然言語処理、音声認識など、複雑な深層学習タスクに対応できる豊富なツールとAPIが用意されています。バージョン2.0以降では使いやすさが大幅に改善され、初心者でも扱いやすくなっています。

Keras(深層学習フレームワーク)

Kerasは、シンプルで直感的な深層学習の実装を可能にする高水準APIフレームワークです。現在はTensorFlowに統合されており、TensorFlowの標準APIとして位置づけられています。複雑な深層学習モデルを少ないコード量で構築できる点が最大の特徴です。

Kerasの主な利点には以下のようなものがあります。

- わかりやすいレイヤーベースのモデル構築方法

- 数行のコードでニューラルネットワークを定義可能

- CNNやRNN、LSTMなど主要なネットワーク構造のサポート

- 学習済みモデル(転移学習用)の豊富なラインナップ

- カスタムレイヤーや損失関数の柔軟な定義

Kerasはプロトタイピングの速度を重視しており、アイデアを素早く実装して検証できる環境を提供します。Sequential APIを使えば、レイヤーを順番に積み重ねるだけでモデルを作成でき、Functional APIを使えばより複雑な構造も表現可能です。教育現場でも広く採用されており、深層学習の入門に最適なフレームワークとして評価されています。

Gradio(UIライブラリ)

Gradioは、機械学習モデルのデモ用インターフェースを簡単に作成できるUIライブラリです。わずか数行のコードでWebベースの対話的なアプリケーションを構築でき、作成したAIモデルを他者と共有したり、動作を確認したりする際に非常に便利です。

Gradioの特徴的な機能は以下の通りです。

- 画像、テキスト、音声など多様な入出力形式への対応

- コード数行でWebインターフェースを自動生成

- 公開用の一時的な共有リンクの自動生成

- Jupyter Notebook上での直接実行

- 複数の入力や出力を組み合わせた複雑なUIの構築

AI開発では、モデルの動作確認やステークホルダーへのデモンストレーション、ユーザーテストの実施などにGradioが活用されます。プログラミングの知識がない人でも使えるインターフェースを迅速に提供できるため、開発したAIモデルの価値を効果的に伝えることができます。近年では教育現場や研究発表での利用も増えており、AIの成果を可視化するツールとして注目されています。

“`

“`html

AI開発で使われるPythonフレームワーク

AI開発においては、機械学習ライブラリだけでなく、アプリケーション開発を効率化するフレームワークも重要な役割を果たします。PythonにはAIモデルを実用的なサービスとして展開するための多様なフレームワークが存在し、開発の目的や規模に応じて最適なものを選択できます。ここでは、AI開発で特に使用頻度の高い主要なPythonフレームワークについて解説します。

LangChain

LangChainは、大規模言語モデル(LLM)を活用したアプリケーション開発に特化したフレームワークです。ChatGPTやGPT-4などのLLMを組み込んだサービスを構築する際に、複雑な処理を簡潔に記述できることから、生成AI開発において急速に普及しています。

LangChainの主な特徴は以下の通りです。

- 複数のLLMを統一的なインターフェースで扱える

- プロンプトテンプレートの管理が容易

- 外部データソースとの連携機能が充実

- チェーン機能により複数の処理を連結できる

- メモリ機能で会話の文脈を保持できる

実用例としては、チャットボット開発、文書検索システム、質問応答システムなどがあり、RAG(Retrieval-Augmented Generation)パターンの実装にも広く活用されています。OpenAI、Anthropic、Google、Hugging Faceなど多様なLLMプロバイダーに対応しているため、柔軟なAIアプリケーション開発が可能です。

FastAPI

FastAPIは、モダンで高速なWeb APIを構築するためのフレームワークです。AI開発においては、機械学習モデルをAPIとして公開する際の標準的な選択肢として広く採用されています。

FastAPIが特にAI開発で好まれる理由は以下の通りです。

- 非同期処理に対応し、高速なレスポンスが可能

- 型ヒントを活用した自動バリデーション機能

- 自動的にAPI仕様書(OpenAPI)を生成

- シンプルで直感的な記述方法

- Pydanticによるデータ検証が標準装備

具体的な活用例としては、画像認識APIの構築、自然言語処理モデルのエンドポイント作成、リアルタイム予測サービスの提供などが挙げられます。TensorFlowやPyTorchで学習したモデルをpickleやONNX形式で読み込み、RESTful APIとして外部から利用できる形にする際に、FastAPIの軽量性と高速性が大きな利点となります。

Django

Djangoは、フルスタックのWebアプリケーションフレームワークとして長い歴史を持つPythonの代表的なフレームワークです。AI開発においては、機械学習機能を含む大規模なWebアプリケーションを構築する際に選ばれることが多くあります。

DjangoをAI開発で利用する利点は以下の通りです。

- 認証・セッション管理などの機能が標準装備

- データベース操作を簡潔に記述できるORM機能

- 管理画面が自動生成される

- セキュリティ対策が充実している

- 大規模開発に適した構造化された設計

実際のAI開発では、ユーザー管理機能を持つ画像分類サービス、履歴を保存する予測分析ダッシュボード、複数の機械学習モデルを統合した業務システムなどの開発に適しています。Django REST frameworkと組み合わせることで、フロントエンドとバックエンドを分離したモダンなAIアプリケーションの構築も可能です。

Flask

Flaskは、軽量でシンプルなマイクロWebフレームワークです。AI開発においては、プロトタイプ作成や小規模なモデル公開に最適な選択肢として広く利用されています。

FlaskがAI開発で重宝される理由は以下の通りです。

- 最小限の構成で素早く開発を始められる

- 必要な機能だけを追加できる柔軟性

- 学習コストが低く初心者にも扱いやすい

- 豊富な拡張機能(Flask-CORS、Flask-SQLAlchemyなど)

- 軽量なため小規模なAIアプリケーションに最適

実用場面では、デモ用のAIアプリケーション、社内向けの予測ツール、研究用の機械学習インターフェースなどの開発に活用されています。例えば、scikit-learnで学習したモデルをPickle形式で保存し、Flaskで簡単なWeb UIを作成して予測結果を表示するといったシンプルなML as a Serviceの実装が数十行のコードで実現できます。Djangoと比較して機能は少ないものの、その分習得が容易で、迅速なプロトタイピングに向いています。

“`

“`html

PythonによるAI開発の手順

PythonでAI開発を進める際には、計画的なアプローチが成功の鍵となります。初心者から経験者まで共通して押さえるべき開発の流れを理解することで、効率的にプロジェクトを進めることができます。ここでは、AI開発における実践的な手順を段階的に解説していきます。

開発目的の明確化

AI開発の最初のステップは、何を解決したいのか、どのような価値を提供したいのかを明確にすることです。目的が曖昧なままプログラミングを始めてしまうと、開発の方向性を見失い、無駄な工数が発生してしまいます。

具体的には以下のような項目を定義します:

- 解決すべき課題や問題の特定

- AIによって達成したい目標の設定

- 予測したい対象や分類したいカテゴリの決定

- 必要な精度やパフォーマンスの基準

- 開発期間や利用可能なリソースの確認

例えば、「顧客の離脱を予測したい」という目的であれば、どの程度の精度が必要か、どのようなデータが利用可能か、予測結果をどう活用するかまで具体化することが重要です。この段階での丁寧な検討が、後の開発工程をスムーズに進める土台となります。

学習用データの準備と収集

AIモデルの性能は、学習に使用するデータの質と量に大きく左右されます。適切なデータを準備することは、AI開発において最も重要かつ時間のかかるプロセスの一つです。

データの準備には以下のステップが含まれます:

- データソースの特定: 社内データベース、公開データセット、APIからの取得、Webスクレイピングなど、データの入手方法を決定します

- データの収集: 必要な量のデータを収集します。一般的に、数百から数千以上のサンプルが必要になることが多いです

- データクレンジング: 欠損値の処理、異常値の除去、重複データの削除などを行います

- データの加工: 数値化、正規化、カテゴリ変数のエンコーディングなど、モデルが扱える形式に変換します

- データの分割: 学習用、検証用、テスト用にデータセットを分割します

データの品質が低い場合、どれだけ優れたアルゴリズムを使用してもモデルの精度は向上しません。そのため、この工程には十分な時間と注意を払う必要があります。

Pythonのインストールと環境構築

AI開発を始めるには、Pythonの実行環境とAI開発に必要なライブラリを整える必要があります。適切な環境構築により、開発中のトラブルを最小限に抑えることができます。

環境構築の主な手順は以下の通りです:

- Pythonのインストール: 公式サイトから最新の安定版Pythonをダウンロードしてインストールします

- 仮想環境の作成: venvやAnacondaを使用して、プロジェクトごとに独立した環境を構築します

- 必要なライブラリのインストール: pip や conda コマンドを使ってNumPy、Pandas、scikit-learn、TensorFlowなどをインストールします

- 開発環境の選択: Jupyter Notebook、VS Code、PyCharmなど、使いやすいエディタやIDEを設定します

# 仮想環境の作成例

python -m venv ai_project_env

# 仮想環境の有効化(Windows)

ai_project_env\Scripts\activate

# 必要なライブラリのインストール

pip install numpy pandas scikit-learn matplotlib

環境構築の段階でつまずく初心者も多いですが、一度正しく構築できれば、その後の開発は格段にスムーズになります。特にライブラリのバージョン管理は重要で、互換性の問題を避けるために requirements.txt などでバージョンを記録しておくことをおすすめします。

学習済みモデルの構築

準備したデータを使って、実際にAIモデルを学習させるフェーズです。このステップでは、問題の性質に応じて適切なアルゴリズムを選択し、Pythonコードで実装していきます。

モデル構築の流れは以下のようになります:

- アルゴリズムの選択: 分類問題か回帰問題か、データの特性などを考慮してアルゴリズムを決定します

- モデルの定義: scikit-learnやTensorFlowなどのライブラリを使用してモデルを定義します

- ハイパーパラメータの設定: 学習率、層の数、ニューロン数など、モデルの動作を制御するパラメータを設定します

- 学習の実行: fit()メソッドなどを使用して、学習用データでモデルをトレーニングします

# scikit-learnを使った簡単な例

from sklearn.ensemble import RandomForestClassifier

# モデルの定義

model = RandomForestClassifier(n_estimators=100, random_state=42)

# モデルの学習

model.fit(X_train, y_train)

初めてのモデル構築では、まずシンプルなアルゴリズムから始めることが推奨されます。複雑なモデルは精度が高い可能性がありますが、理解と調整が難しくなるため、段階的にアプローチすることが効果的です。

モデルの検証と調整

構築したモデルが実際にどの程度の性能を発揮するかを評価し、必要に応じて改善を行うプロセスです。この段階での丁寧な検証が、実用的なAIシステムの開発には不可欠です。

検証と調整には以下の作業が含まれます:

- 性能評価: 検証用データを使って、精度、適合率、再現率、F値などの指標でモデルを評価します

- 過学習の確認: 学習用データでの性能と検証用データでの性能を比較し、過学習が発生していないかチェックします

- ハイパーパラメータの調整: グリッドサーチやランダムサーチなどの手法を用いて、最適なパラメータを探索します

- 特徴量の見直し: モデルの性能が不十分な場合、入力データの特徴量を追加・削除・変換します

- アルゴリズムの変更: 必要に応じて別のアルゴリズムを試します

初回の学習で満足のいく結果が得られることは稀です。この検証と調整のサイクルを何度も繰り返すことで、徐々にモデルの精度が向上していきます。特に、ビジネス要件を満たす精度が得られるまで、根気強く改善を続けることが重要です。

製品・サービスへの実装

検証を終えて十分な性能が確認できたモデルを、実際の製品やサービスに組み込む最終段階です。開発環境で動作するモデルを、本番環境でも安定して稼働させるための作業を行います。

実装フェーズで行うべき作業は以下の通りです:

- モデルの保存: pickleやjoblibなどを使用してモデルをファイルとして保存します

- APIの構築: FlaskやFastAPIなどのフレームワークを使用して、モデルを呼び出すためのAPIを構築します

- デプロイ環境の準備: クラウドサービスやオンプレミスサーバーに、本番環境を構築します

- パフォーマンステスト: 応答速度や同時処理数など、本番環境での性能を検証します

- 監視体制の構築: モデルの予測精度やシステムの稼働状況を継続的にモニタリングする仕組みを整えます

- 再学習の仕組み: データの変化に対応するため、定期的にモデルを再学習する体制を構築します

実装後も、ユーザーからのフィードバックや新しいデータを活用して、継続的にモデルを改善していく姿勢が重要です。AI開発は一度作って終わりではなく、運用しながら育てていくプロセスであることを理解しておきましょう。

“`

“`html

機械学習モデルの実践

PythonでAI開発を行う際、機械学習モデルの実装は避けて通れない重要なステップです。ここでは、実務でもよく使われる代表的な機械学習アルゴリズムの実装方法や、データの前処理、そしてモデルの性能を正しく評価するための指標について解説します。実際のコードを動かしながら学ぶことで、理論だけでなく実践的なスキルを身につけることができます。

ロジスティック回帰の実装方法

ロジスティック回帰は、分類問題に用いられる機械学習の基本的なアルゴリズムです。scikit-learnライブラリを使用することで、わずか数行のコードで実装が可能となっています。

Pythonでのロジスティック回帰の実装は、以下のような流れで行います。まず、scikit-learnから`LogisticRegression`クラスをインポートし、モデルのインスタンスを作成します。次に、訓練データを用いて`fit()`メソッドでモデルを学習させ、`predict()`メソッドで予測を行います。

from sklearn.linear_model import LogisticRegression

from sklearn.model_selection import train_test_split

# データの分割

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# モデルの作成と学習

model = LogisticRegression()

model.fit(X_train, y_train)

# 予測の実行

predictions = model.predict(X_test)ロジスティック回帰は、シンプルでありながら高い解釈性を持つため、医療診断やマーケティング分野での顧客行動予測など、結果の説明が重要な場面で広く活用されています。また、計算コストが低いため、大規模データの初期分析にも適しています。

ランダムフォレストの実装方法

ランダムフォレストは、複数の決定木を組み合わせたアンサンブル学習の手法で、高い予測精度と過学習への耐性を持つアルゴリズムです。Pythonのscikit-learnでは、`RandomForestClassifier`や`RandomForestRegressor`を使用して簡単に実装できます。

ランダムフォレストの基本的な実装手順は以下の通りです。まず必要なクラスをインポートし、ハイパーパラメータを設定してモデルを作成します。決定木の数や最大深度などのパラメータを調整することで、モデルの性能を最適化できます。

from sklearn.ensemble import RandomForestClassifier

# ランダムフォレストモデルの作成

rf_model = RandomForestClassifier(

n_estimators=100, # 決定木の数

max_depth=10, # 木の最大深度

random_state=42

)

# モデルの学習

rf_model.fit(X_train, y_train)

# 予測と特徴量の重要度取得

predictions = rf_model.predict(X_test)

feature_importance = rf_model.feature_importances_ランダムフォレストの大きな利点は、特徴量の重要度を可視化できる点です。これにより、予測に最も影響を与えている要因を特定でき、ビジネス上の意思決定に役立てることができます。また、欠損値に対する頑健性も高く、実務での使用頻度が非常に高いアルゴリズムです。

データフレームの操作と前処理

機械学習モデルの精度は、データの品質に大きく依存します。PythonのPandasライブラリを使用したデータフレームの操作と前処理は、AI開発における最も重要な工程の一つです。適切な前処理を行うことで、モデルの予測精度を大幅に向上させることができます。

データ前処理の主な作業には以下のようなものがあります。

- 欠損値の処理:データに含まれる欠損値を削除するか、平均値や中央値で補完します。`dropna()`や`fillna()`メソッドを使用します。

- 外れ値の検出:統計的手法やIQR(四分位範囲)を用いて、異常な値を特定して除外または修正します。

- カテゴリ変数のエンコーディング:文字列データを数値に変換します。ラベルエンコーディングやワンホットエンコーディングを使用します。

- 特徴量のスケーリング:StandardScalerやMinMaxScalerを用いて、異なる尺度の特徴量を正規化します。

- データの結合と分割:`merge()`や`concat()`でデータを結合し、必要な形式に整形します。

import pandas as pd

from sklearn.preprocessing import StandardScaler

# データの読み込み

df = pd.read_csv('data.csv')

# 欠損値の確認と処理

print(df.isnull().sum())

df = df.fillna(df.mean())

# カテゴリ変数のエンコーディング

df = pd.get_dummies(df, columns=['category_column'])

# 数値の標準化

scaler = StandardScaler()

df[['feature1', 'feature2']] = scaler.fit_transform(df[['feature1', 'feature2']])前処理の段階でデータの偏りやノイズを適切に処理しないと、モデルの学習が正しく行われず、予測精度が低下するため、十分な時間をかけてデータを理解し、適切な処理を施すことが重要です。

予測精度の評価指標

機械学習モデルの性能を正しく評価するためには、適切な評価指標を選択することが不可欠です。問題の種類(分類問題か回帰問題か)や、ビジネス上の目的によって、最適な評価指標は異なります。

分類問題における主な評価指標には以下のようなものがあります。

| 評価指標 | 説明 | 使用場面 |

|---|---|---|

| 正解率(Accuracy) | 全体の予測のうち正解した割合 | データのクラスバランスが良い場合 |

| 適合率(Precision) | 陽性と予測したもののうち実際に陽性だった割合 | 誤検知のコストが高い場合 |

| 再現率(Recall) | 実際の陽性のうち正しく陽性と予測できた割合 | 見逃しのコストが高い場合 |

| F1スコア | 適合率と再現率の調和平均 | バランスの取れた評価が必要な場合 |

| AUC-ROC | ROC曲線の下側面積 | モデルの総合的な性能評価 |

from sklearn.metrics import accuracy_score, precision_score, recall_score, f1_score, roc_auc_score

from sklearn.metrics import confusion_matrix, classification_report

# 各種評価指標の計算

accuracy = accuracy_score(y_test, predictions)

precision = precision_score(y_test, predictions)

recall = recall_score(y_test, predictions)

f1 = f1_score(y_test, predictions)

# 詳細なレポート出力

print(classification_report(y_test, predictions))

# 混同行列の作成

cm = confusion_matrix(y_test, predictions)

print(cm)回帰問題では、平均二乗誤差(MSE)、平均絶対誤差(MAE)、決定係数(R²スコア)などが使用されます。これらの指標は、予測値と実際の値の誤差を定量化します。

from sklearn.metrics import mean_squared_error, mean_absolute_error, r2_score

# 回帰問題の評価指標

mse = mean_squared_error(y_test, predictions)

mae = mean_absolute_error(y_test, predictions)

r2 = r2_score(y_test, predictions)

print(f"MSE: {mse}")

print(f"MAE: {mae}")

print(f"R²スコア: {r2}")評価指標を適切に選択し、単一の指標だけでなく複数の指標を組み合わせて総合的に判断することで、モデルの真の性能を把握できます。特に不均衡データでは、正解率だけでは誤った判断をしてしまう可能性があるため、注意が必要です。

“`

“`html

画像認識AIの開発

画像認識はAI技術の中でも特に実用化が進んでいる分野です。PythonとディープラーニングのフレームワークKerasやTensorFlowを活用することで、画像分類や物体検出などの画像認識AIを比較的容易に開発できます。本セクションでは、Pythonを用いた画像認識AIの開発について、デジタル画像データの基本的な取り扱い方から、実際にモデルを構築して未知データに対する予測を行うまでの一連のプロセスを解説します。

デジタル画像データの取り扱い

Pythonで画像認識AIを開発する際には、まずデジタル画像データがどのような形式で表現されているかを理解する必要があります。コンピュータ上の画像は数値の配列として扱われ、この数値データをAIモデルに入力することで学習や予測が可能になります。

デジタル画像はピクセルと呼ばれる最小単位の集合で構成されており、各ピクセルは色情報を数値で保持しています。グレースケール画像の場合は0~255の範囲で明るさが表現され、カラー画像ではRGB(赤・緑・青)の3つのチャンネルがそれぞれ0~255の値を持ちます。例えば、100×100ピクセルのカラー画像は、100×100×3の3次元配列として表現されます。

Pythonでこうしたデジタル画像データを取り扱う際には、以下のようなライブラリを活用します。

- NumPy:画像を多次元配列として操作するための基本ライブラリ

- Pillow(PIL):画像ファイルの読み込み、保存、基本的な加工を行うライブラリ

- OpenCV:高度な画像処理機能を持つコンピュータビジョンライブラリ

- Matplotlib:画像データの可視化や確認に使用するライブラリ

画像認識AIに入力する前には、データの前処理が重要です。画像サイズの統一、正規化(ピクセル値を0~1の範囲に変換)、データ拡張(回転・反転などで訓練データを増やす)などの処理を施すことで、モデルの学習効率と精度が向上します。

画像分類モデルの作成手順

画像分類は、入力された画像が何のカテゴリに属するかを判定するタスクです。Pythonを用いた画像分類モデルの作成は、段階的なステップを踏むことで効率的に進められます。

まず最初のステップは、学習用データセットの準備です。画像を各カテゴリごとにフォルダ分けし、訓練データと検証データに分割します。一般的には訓練データに全体の70~80%を、検証データに20~30%を割り当てます。

次に、KerasやTensorFlowを使用してニューラルネットワークモデルを構築します。画像認識には畳み込みニューラルネットワーク(CNN)が広く用いられます。以下が基本的な構築手順です。

- モデルアーキテクチャの定義:畳み込み層、プーリング層、全結合層を組み合わせてネットワーク構造を設計

- コンパイル:最適化アルゴリズム(Adamなど)、損失関数(交差エントロピーなど)、評価指標(正解率など)を指定

- 学習の実行:fit()メソッドを使用して訓練データでモデルを学習させる

- 評価と調整:検証データでモデルの性能を評価し、必要に応じてハイパーパラメータを調整

# Kerasを使った基本的な画像分類モデルの例

from tensorflow import keras

from tensorflow.keras import layers

model = keras.Sequential([

layers.Conv2D(32, (3, 3), activation='relu', input_shape=(128, 128, 3)),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activation='relu'),

layers.MaxPooling2D((2, 2)),

layers.Flatten(),

layers.Dense(64, activation='relu'),

layers.Dense(10, activation='softmax')

])

model.compile(optimizer='adam',

loss='categorical_crossentropy',

metrics=['accuracy'])実際の開発では、VGG16、ResNet、MobileNetなどの事前学習済みモデルを利用する転移学習の手法も有効です。これにより少ないデータ量でも高精度なモデルを構築できます。

外部データの読み込み方法

画像認識AIを開発する際、外部に保存されている画像データを効率的に読み込む方法を理解しておくことが重要です。Pythonには様々な画像データの読み込み手法があり、データセットの規模や形式に応じて適切な方法を選択する必要があります。

最も基本的な方法は、Pillowライブラリを使った個別ファイルの読み込みです。Image.open()関数で画像を読み込み、NumPy配列に変換して処理を行います。

from PIL import Image

import numpy as np

# 画像の読み込み

img = Image.open('sample.jpg')

# NumPy配列に変換

img_array = np.array(img)

print(img_array.shape) # (高さ, 幅, チャンネル数)大量の画像データを扱う場合は、KerasのImageDataGeneratorやTensorFlowのtf.data APIを活用することで、メモリ効率の良いバッチ処理が可能になります。これらのツールは画像の自動読み込みとデータ拡張を同時に行えます。

from tensorflow.keras.preprocessing.image import ImageDataGenerator

# データジェネレータの設定

datagen = ImageDataGenerator(

rescale=1./255,

rotation_range=20,

horizontal_flip=True

)

# ディレクトリから画像を読み込み

train_generator = datagen.flow_from_directory(

'data/train',

target_size=(128, 128),

batch_size=32,

class_mode='categorical'

)また、外部の公開データセットを利用する場合には、以下のような手法があります。

- Keras Datasetsモジュール:MNIST、CIFAR-10などの標準的なデータセットを簡単に読み込める

- TensorFlow Datasets:より多様なデータセットにアクセス可能

- Kaggleからのダウンロード:Kaggle APIを使って豊富な画像データセットを取得

- URLからの直接ダウンロード:requestsライブラリを使ってWeb上の画像を取得

CSVファイルに画像のパスとラベルが記載されている場合は、Pandasで読み込んでからループ処理で画像を取得する方法も有効です。データの読み込み段階でエラーハンドリングを実装しておくと、破損したファイルによる学習中断を防ぐことができます。

未知データに対する予測

画像認識AIモデルの最終目的は、学習時には見たことのない未知のデータに対して正確な予測を行うことです。学習が完了したモデルを使って新しい画像を分類する手順を理解することで、実用的なAIアプリケーションの開発が可能になります。

未知データに対する予測を実行する際の基本的な流れは以下の通りです。

- 学習済みモデルの読み込み:保存したモデルをロードする

- 画像の前処理:予測対象の画像を学習時と同じ形式に変換

- 予測の実行:predict()メソッドを使って分類結果を取得

- 結果の解釈:出力された確率値から最も可能性の高いクラスを判定

from tensorflow import keras

import numpy as np

from PIL import Image

# 学習済みモデルの読み込み

model = keras.models.load_model('my_model.h5')

# 新しい画像の読み込みと前処理

img = Image.open('unknown_image.jpg')

img = img.resize((128, 128)) # モデルの入力サイズに合わせる

img_array = np.array(img) / 255.0 # 正規化

img_array = np.expand_dims(img_array, axis=0) # バッチ次元を追加

# 予測の実行

predictions = model.predict(img_array)

predicted_class = np.argmax(predictions[0])

confidence = predictions[0][predicted_class]

print(f"予測クラス: {predicted_class}")

print(f"確信度: {confidence:.2%}")予測結果の信頼性を評価することも重要です。出力される確率値が低い場合や、複数のクラスで確率が拮抗している場合は、モデルが判断に迷っていることを示します。実用的なシステムでは、確信度が一定の閾値を下回る場合は「判定不能」として人間の確認を促すなどの対策を講じることが推奨されます。

また、複数の画像をまとめて予測する場合は、バッチ処理を活用することで処理速度を向上させることができます。大量の画像に対する予測を行う際は、GPUを活用することで処理時間を大幅に短縮できます。

予測結果を可視化して確認することも有効です。MatplotlibやPillowを使って、元の画像と予測結果、確信度を一緒に表示することで、モデルの判断根拠を直感的に理解できます。さらに高度な分析として、Grad-CAMなどの手法を用いて、モデルが画像のどの部分に注目して判断を下しているかを可視化することも可能です。

“`

“`html

PythonでAI開発できる具体的な事例

Pythonを活用したAI開発は、私たちの生活やビジネスのあらゆる場面で実用化されています。理論や技術の学習も重要ですが、実際にどのような分野でPythonによるAI技術が活用されているのかを知ることで、学習のモチベーション向上や開発の方向性を定めることができます。ここでは、現代社会において特に注目されているPythonによるAI開発の具体的な事例を紹介します。

自動運転技術への応用

自動運転技術は、PythonとAIを組み合わせた最も先進的な応用事例の一つです。自動車に搭載されたカメラやセンサーから取得した膨大な画像データをリアルタイムで解析し、道路状況、歩行者、他の車両、交通標識などを認識する必要があります。

この分野では、TensorFlowやPyTorchといったPythonの深層学習フレームワークが中心的な役割を果たしています。畳み込みニューラルネットワーク(CNN)を用いた画像認識モデルにより、車両は周囲の環境を正確に把握できるようになります。さらに、強化学習を活用することで、AIが運転シミュレーション環境の中で試行錯誤を繰り返し、最適な運転判断を学習していきます。

TeslaやWaymoなどの企業では、Pythonベースの開発環境を用いて、何百万マイルもの走行データから学習したAIモデルを構築しています。これらのモデルは、急な飛び出しへの対応や複雑な交差点での判断など、人間のドライバーと同等以上の能力を目指して日々進化を続けています。

顔認証システムの実現

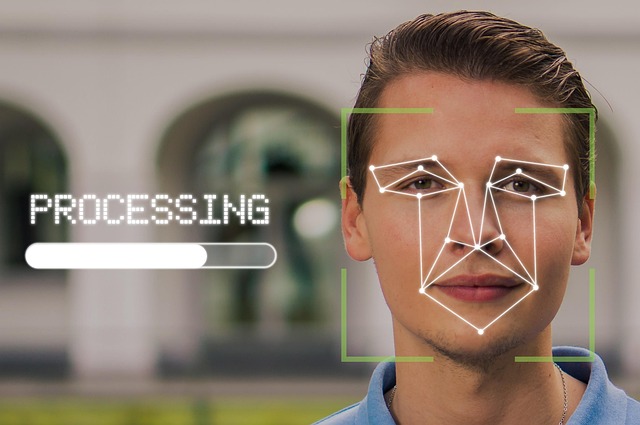

顔認証システムは、セキュリティ分野やスマートフォンのロック解除など、身近な場面で広く活用されているAI技術です。Pythonで開発された顔認証システムは、高精度かつ高速な本人確認を可能にしています。

顔認証の実装には、まずOpenCVというPythonのコンピュータビジョンライブラリを使って顔の検出を行います。次に、検出された顔画像から特徴量を抽出し、深層学習モデルによって個人を識別します。代表的な手法としては、FaceNetやDeepFaceなどのアルゴリズムがあり、これらはPythonで実装可能です。

実際の応用例としては、空港での入国審査システム、オフィスビルの入退室管理、スマートフォンの顔認証ロック、さらには犯罪捜査における容疑者の特定支援など、多岐にわたります。特にdlibやface_recognitionといったPythonライブラリを使用することで、比較的少ないコード量で高精度な顔認証システムを構築できるため、多くの開発者に支持されています。

株価や仮想通貨の予測分析

金融市場における株価や仮想通貨の価格予測は、PythonとAIの組み合わせが大きな成果を上げている分野です。過去の価格データ、取引量、経済指標、ニュース記事などの多様なデータを機械学習モデルに学習させることで、将来の価格動向を予測しようとする試みが世界中で行われています。

この分野では、時系列データの分析に特化したLSTM(長短期記憶ネットワーク)やGRU(ゲート付き回帰ユニット)といったディープラーニングモデルがよく使用されます。PythonのPandasライブラリでデータの前処理を行い、scikit-learnやKerasでモデルを構築し、Matplotlibで予測結果を可視化するという一連の流れを実現できます。

ヘッジファンドや投資会社では、Pythonで開発したアルゴリズムトレーディングシステムを運用し、人間の感情に左右されない客観的な投資判断を行っています。また、個人投資家向けにも、Pythonを使った株価予測のチュートリアルやオープンソースのプロジェクトが数多く公開されており、誰でも機械学習を活用した投資分析に挑戦できる環境が整っています。ただし、市場予測は非常に複雑であり、AIモデルの予測が必ずしも正確とは限らない点には注意が必要です。

医療診断支援システム

医療分野におけるAI活用は、人々の健康と命に直接関わる重要な応用事例です。PythonとAI技術を組み合わせた医療診断支援システムは、医師の診断精度向上や早期発見に大きく貢献しています。

特に画像診断の分野では、X線写真、CT画像、MRI画像などの医療画像から病変を検出するAIモデルが開発されています。肺がん、乳がん、脳腫瘍などの検出において、深層学習モデルは熟練した放射線科医に匹敵する、場合によってはそれを上回る精度を達成していることが研究によって示されています。

PythonのTensorFlowやPyTorchを使って構築された畳み込みニューラルネットワークは、数万から数十万枚の医療画像から病変の特徴を学習し、新しい画像に対して高精度な診断支援を提供します。また、SimpleITKやMedpyといった医療画像専用のPythonライブラリも開発されており、DICOM形式の医療画像を効率的に処理できます。

さらに、遺伝子配列の解析、薬剤の副作用予測、患者の再入院リスク予測など、画像以外の医療データ分析にもPythonが広く活用されています。これらのシステムは医師の判断を補助するツールとして位置づけられ、最終的な診断は医師が行うことで、AIと人間の専門知識を組み合わせた最適な医療提供を実現しています。

“`

“`html

Python初心者向けのAI学習方法

PythonによるAI開発を学び始める際、適切な学習方法を選択することが成功への近道となります。初心者の方は、基礎から段階的に学べる環境を整え、理論と実践をバランスよく組み合わせることが重要です。ここでは、Python初心者がAI開発のスキルを効果的に習得するための具体的な学習方法を紹介します。

入門書籍で基礎を固める

書籍による学習は、PythonとAIの基礎を体系的に理解するための最も確実な方法の一つです。紙の書籍や電子書籍を活用することで、自分のペースで繰り返し学習でき、知識を着実に定着させることができます。

入門書籍を選ぶ際は、以下のポイントを重視すると効果的です。まず、Pythonの基本文法から機械学習の概念まで段階的に解説されている書籍を選びましょう。初心者向けの書籍では、プログラミングの経験がなくても理解できるよう、丁寧な説明とサンプルコードが豊富に掲載されています。また、実際に手を動かしながら学べる演習問題が含まれている書籍は、理論と実践を同時に身につけられるため特におすすめです。

書籍学習のメリットは、インターネット環境に依存せず、いつでもどこでも学習できる点にあります。通勤時間や休憩時間などの隙間時間を活用して、継続的に知識を積み上げることが可能です。さらに、書籍は情報が体系化されているため、全体像を把握しやすく、学習の道筋が明確になります。

オンライン学習サイトの活用

オンライン学習プラットフォームは、動画やインタラクティブなコンテンツを通じて、視覚的かつ実践的にPythonとAIを学べる優れた手段です。多くのサイトでは無料または手頃な価格で質の高い教材が提供されており、初心者でもスムーズに学習を始められます。

Progate

Progateは、ブラウザ上で実際にコードを書きながら学べるオンライン学習サービスです。スライド形式の分かりやすい解説と、すぐに実践できる演習環境が一体化しており、環境構築の手間なく学習を開始できます。

Pythonの基礎コースでは、変数や条件分岐、ループ処理などの基本文法から、クラスやモジュールといった応用的な概念まで段階的に学習できます。特に初心者にとって、ゲーム感覚で楽しみながらプログラミングの基礎を身につけられる点が大きな魅力です。各レッスンは短時間で完結するよう設計されているため、毎日コツコツと継続しやすい学習環境が整っています。

ドットインストール

ドットインストールは、3分程度の短い動画でプログラミングを学べる学習サービスです。一つひとつのレッスンが簡潔にまとめられているため、集中力を保ちながら効率的に学習を進められます。

Pythonの入門レッスンでは、基本的な文法や制御構造、関数の使い方などを実際の画面操作を見ながら学べます。講師が実際にコードを書く様子を観察できるため、コーディングの流れやデバッグの方法など、書籍だけでは分かりにくい実践的なスキルも習得できます。また、機械学習やデータ分析に関連するレッスンも用意されており、Pythonの基礎を習得した後にAI開発へとスムーズにステップアップできます。

Udemy

Udemyは、世界中の専門家が作成した動画講座を購入して学習できるプラットフォームです。PythonとAIに関する講座が豊富に揃っており、初心者向けから上級者向けまで、自分のレベルに合ったコースを選択できます。

Udemyの強みは、実務経験豊富な講師による実践的な内容と、買い切り型で何度でも視聴できる点にあります。多くの講座では、数時間から数十時間にわたる充実したカリキュラムが組まれており、Pythonの基礎からscikit-learnやTensorFlowを使った機械学習・深層学習の実装まで、包括的に学ぶことができます。受講生のレビューや評価を参考にして質の高い講座を選べるため、自分の学習目的に最適なコースを見つけやすいのも魅力です。

プログラミングスクールでの学習

独学に不安を感じる方や、短期間で集中的にスキルを習得したい方には、プログラミングスクールでの学習が効果的な選択肢となります。専門的な指導とサポート体制が整った環境で学ぶことで、挫折を防ぎながら確実にスキルを身につけることができます。

プログラミングスクールでは、現役のエンジニアや専門家から直接指導を受けられるため、疑問点をすぐに解決でき、効率的に学習を進められます。カリキュラムは体系的に設計されており、Pythonの基礎からAI開発の実践まで、必要な知識とスキルを漏れなく習得できます。また、同じ目標を持つ仲間と一緒に学ぶことで、モチベーションを維持しやすく、相互に学び合える環境も魅力です。

多くのスクールでは、オンライン形式や通学形式、あるいは両方を組み合わせた柔軟な受講スタイルを提供しています。働きながら学びたい社会人や、地方在住の方でも、自分のライフスタイルに合わせて学習できる環境が整っています。さらに、ポートフォリオ作成支援や就職・転職サポートなど、キャリア形成まで視野に入れた総合的なサポートを受けられるスクールも多く存在します。

サンプルコードの改変による実践

理論的な知識を習得した後は、実際にコードを書いて動かすことが最も重要な学習ステップとなります。中でもサンプルコードの改変は、初心者が実践力を養うための効果的な方法です。

インターネット上や書籍には、機械学習や画像認識などのサンプルコードが豊富に公開されています。これらのコードをそのまま実行するだけでなく、パラメータを変更したり、データセットを差し替えたりすることで、コードの動作原理を深く理解できます。例えば、画像分類のサンプルコードであれば、学習データの種類を変えてみる、エポック数を調整してみる、モデルの層構造を変更してみるなど、様々な実験を試みることができます。

サンプルコードの改変を通じて、各パラメータが結果にどのような影響を与えるかを体感的に学べるため、単に理論を暗記するよりも遥かに深い理解が得られます。また、エラーが発生した際にデバッグする経験も積めるため、実務で必要とされる問題解決能力も同時に養われます。GitHubなどのコード共有プラットフォームを活用すれば、世界中の開発者が公開している高品質なサンプルコードにアクセスできます。

練習問題への取り組み

知識を確実に定着させ、応用力を身につけるためには、練習問題に積極的に取り組むことが欠かせません。問題を解くプロセスを通じて、学んだ知識を実際にどう活用すればよいかを理解できます。

オンライン学習プラットフォームや書籍の多くには、章末問題や演習課題が用意されています。これらの問題は、その章で学んだ内容を確認し、理解度をチェックするために設計されています。問題に取り組む際は、すぐに解答を見ずに、まず自分で考えて実装してみることが重要です。試行錯誤の過程で、プログラミングの感覚が身につき、論理的思考力も鍛えられます。

また、Kaggleなどのデータサイエンスコンペティションプラットフォームには、初心者向けのチュートリアルや練習用データセットが豊富に用意されています。実際のデータを使った問題に挑戦することで、より実践的なスキルを磨くことができます。他の参加者の解法やディスカッションを参考にすることで、多様なアプローチを学べる点も大きなメリットです。

実際のプロジェクト開発による学習

PythonとAIの学習において最も効果的な方法は、実際のプロジェクトを自分で企画・開発することです。実践的なプロジェクトに取り組むことで、断片的な知識が統合され、本当の意味でのスキルとして定着します。

プロジェクトは、自分の興味や関心に基づいて選ぶと、モチベーションを維持しやすくなります。例えば、趣味の写真を自動分類するアプリ、SNSのテキストから感情を分析するツール、株価予測モデルの構築など、身近なテーマから始めることをおすすめします。プロジェクトの規模は小さくても構いません。重要なのは、問題設定からデータ収集、モデル構築、検証まで、一連のプロセスを自分で経験することです。

プロジェクト開発では、教材では扱われない様々な課題に直面します。データの前処理に予想以上に時間がかかったり、モデルの精度が思うように上がらなかったり、実装時に想定外のエラーが発生したりします。しかし、こうした困難を乗り越える過程こそが、実務で通用する真の実力を養う機会となります。完成したプロジェクトは、自分のポートフォリオとして公開することで、学習の成果を証明できるだけでなく、就職・転職活動でも有利に働きます。

プロジェクト開発を通じて、技術的なスキルだけでなく、プロジェクト管理能力や自己学習能力も向上します。分からないことを自分で調べ、試行錯誤しながら解決策を見つけ出す経験は、AI開発者として成長するための貴重な財産となるでしょう。

“`

“`html

Google Colaboratoryの活用

PythonでAI開発を始める際、ローカル環境の構築に時間をかけることなく、すぐに実践的な学習やモデル開発を始められるツールがあります。それがGoogle Colaboratoryです。特にディープラーニングのような高度な計算処理を必要とするAI開発では、Google Colaboratoryの無料GPU環境が大きな武器となります。ここでは、AI開発におけるGoogle Colaboratoryの具体的な活用方法について解説します。

Google Colaboratoryとは

Google Colaboratory(通称Colab)は、Googleが提供する無料のクラウドベースのPython実行環境です。Webブラウザ上でPythonコードを記述・実行できるため、ローカルマシンにPythonや各種ライブラリをインストールする必要がありません。Jupyter Notebookをベースとしており、コードとその実行結果、説明文を1つのドキュメントにまとめて管理できる特徴があります。

Google Colaboratoryの最大の魅力は、AI開発に必要な主要ライブラリがあらかじめインストールされている点です。NumPy、Pandas、Matplotlib、scikit-learn、TensorFlow、Kerasなど、Python AI開発で頻繁に使用されるライブラリが標準で利用可能です。さらに、Googleドライブとの連携により、作成したノートブックやデータを簡単に保存・共有できるため、チーム開発や学習の継続にも適しています。

基本的な使い方と実行方法

Google Colaboratoryを使い始めるには、Googleアカウントさえあれば準備完了です。Google Driveにアクセスし、「新規」ボタンから「その他」→「Google Colaboratory」を選択することで、新しいノートブックが作成されます。

ノートブックは「セル」と呼ばれる単位でコードを記述します。セルにPythonコードを入力した後、Shift + Enterキーを押すか、セル左側の実行ボタンをクリックすることでコードが実行されます。実行結果はセルの直下に表示され、変数の値やグラフなどを即座に確認できます。

# セルでのコード実行例

import numpy as np

# 配列の作成

data = np.array([1, 2, 3, 4, 5])

print(f"平均値: {np.mean(data)}")

print(f"標準偏差: {np.std(data)}")複数のセルを順番に実行することで、段階的にプログラムを構築できます。各セルは独立して実行できるため、デバッグやコードの修正が効率的に行えます。また、マークダウン形式のテキストセルを追加することで、コードの説明やドキュメントを同じノートブック内に記述できるのも大きな利点です。

ライブラリの導入方法

Google Colaboratoryには多くのライブラリがプリインストールされていますが、標準で含まれていないライブラリを使用したい場合もあります。そのような場合は、pipコマンドを使ってセル内でライブラリをインストールできます。

# ライブラリのインストール例

!pip install transformers

!pip install gradio

!pip install langchainセル内でコマンドを実行する際は、行頭に「!」(エクスクラメーションマーク)を付けます。これによりシェルコマンドとして実行され、ライブラリのインストールが行われます。インストールしたライブラリは、その後のセルで通常通りimport文を使って読み込むことができます。

特定のバージョンのライブラリが必要な場合は、以下のように指定します。

# バージョンを指定したインストール

!pip install tensorflow==2.12.0

!pip install numpy>=1.21.0ただし、ランタイムを再起動するとインストールしたライブラリは消去されるため、セッションごとに再インストールが必要になる点には注意が必要です。

ファイルの読み込み手順

AI開発では学習用データやテスト用データを読み込む必要があります。Google Colaboratoryでファイルを扱う方法は主に3つあります。

1. ローカルファイルのアップロード

最もシンプルな方法は、ローカルPCからファイルを直接アップロードする方法です。以下のコードを実行することで、ファイル選択ダイアログが表示されます。

from google.colab import files

# ファイルのアップロード

uploaded = files.upload()

# アップロードしたファイルの確認

for filename in uploaded.keys():

print(f'アップロード完了: {filename} ({len(uploaded[filename])} bytes)')2. Google Driveのマウント

大容量のデータセットを扱う場合や、繰り返し同じファイルを使用する場合は、Google Driveをマウントする方法が便利です。

from google.colab import drive

# Google Driveをマウント

drive.mount('/content/drive')

# ファイルの読み込み例

import pandas as pd

df = pd.read_csv('/content/drive/MyDrive/data/dataset.csv')

print(df.head())この方法では、認証プロセスを経てGoogle Drive内のファイルに直接アクセスできます。データセットをGoogle Driveに保存しておけば、セッションが切れても再度アップロードする手間が省けます。

3. URLからの直接ダウンロード

公開されているデータセットをURLから直接ダウンロードすることも可能です。

# wgetコマンドでファイルをダウンロード

!wget https://example.com/dataset.csv

# または、requestsライブラリを使用

import requests

url = 'https://example.com/dataset.csv'

response = requests.get(url)

with open('dataset.csv', 'wb') as f:

f.write(response.content)GPU演算機能の利用

深層学習モデルのトレーニングには大量の計算リソースが必要です。Google ColaboratoryではGPUやTPUを無料で利用でき、ローカル環境では数時間かかる処理を数分で完了させることも可能です。

GPU環境を有効にするには、画面上部のメニューから「ランタイム」→「ランタイムのタイプを変更」を選択し、「ハードウェア アクセラレータ」のドロップダウンメニューから「GPU」または「TPU」を選択します。

GPU環境が正しく有効化されているかを確認するには、以下のコードを実行します。

import tensorflow as tf

# GPU利用可能かチェック

print("GPUが利用可能か:", tf.test.is_gpu_available())

print("利用可能なGPUデバイス:", tf.config.list_physical_devices('GPU'))

# CUDA対応の確認

print("CUDAサポート:", tf.test.is_built_with_cuda())GPU環境でのモデルトレーニングは、CPU環境と同じコードで実行できます。TensorFlowやPyTorchなどのフレームワークは、GPUが利用可能な場合は自動的にGPUを使用して計算を行います。

# TensorFlowでのGPU利用例

import tensorflow as tf

# モデルの定義(GPUが自動的に使用される)

model = tf.keras.Sequential([

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy')

# トレーニング時にGPUが使用される

model.fit(X_train, y_train, epochs=10, batch_size=32)使用時の注意点

Google Colaboratoryは非常に便利なツールですが、使用する際にはいくつかの制約と注意点があります。これらを理解しておくことで、より効果的にAI開発を進めることができます。

セッションの時間制限

Google Colaboratoryの無料版では、連続使用時間に制限があります。一定時間(通常12時間)が経過すると、ランタイムが自動的に切断されます。また、90分間操作がない場合も接続が切断されるため、長時間のトレーニングを行う際は注意が必要です。重要なモデルや結果は定期的にGoogle Driveに保存することをおすすめします。

# モデルの定期保存例

import tensorflow as tf

# チェックポイントコールバックの設定

checkpoint_callback = tf.keras.callbacks.ModelCheckpoint(

filepath='/content/drive/MyDrive/models/model_checkpoint.h5',

save_best_only=True,

monitor='val_loss'

)

model.fit(X_train, y_train,

validation_data=(X_val, y_val),

callbacks=[checkpoint_callback])GPU使用量の制限

無料版のGPU利用には使用量の上限があり、短期間に大量のGPUリソースを消費すると、一時的にGPUアクセスが制限される場合があります。効率的なコードを書き、不要な計算を避けることが重要です。

ファイルの永続性

Colaboratoryの作業ディレクトリ(/content/)に保存したファイルは、ランタイムが切断されると削除されます。重要なデータやモデルは必ずGoogle Driveにマウントしたディレクトリに保存するか、ローカルにダウンロードしてください。

商用利用の制限

Google Colaboratoryの無料版は、個人の学習や研究目的での利用を想定しています。大規模な商用プロジェクトでの利用には、有料版のColab Proの検討が推奨されます。

これらの注意点を踏まえつつ、Google ColaboratoryはPython AI開発の学習と実践に非常に有効なプラットフォームです。環境構築の手間なく、すぐにコーディングを始められる利点を活かして、積極的に活用していきましょう。

“`

“`html

PythonのAI開発における弱点と対策

PythonはAI開発において圧倒的な人気を誇る言語ですが、万能というわけではありません。実際の開発現場では、Pythonならではの弱点に直面することがあります。しかし、これらの課題には適切な対策が存在し、多くの開発者が実践的な解決策を見出しています。ここでは、Python特有の弱点と、それを補うための現実的なアプローチについて解説します。

処理速度の課題

PythonのAI開発における最も顕著な弱点は、実行速度の遅さです。Pythonはインタープリタ型言語であり、コードを1行ずつ解釈しながら実行するため、コンパイル型言語であるC++やJavaと比較すると、実行速度が大幅に劣ります。

この速度差は、特に以下のような場面で問題となります。

- 大規模なデータセットを扱う前処理の段階

- リアルタイム性が求められる推論処理

- 組み込みシステムやエッジデバイスでのAI実装

- 複雑なループ処理を多用するアルゴリズム

例えば、数百万件のデータを繰り返し処理する場合、Pythonの純粋なコードでは数時間かかる処理が、C++では数分で完了することもあります。この速度差は、開発サイクルの効率や製品のパフォーマンスに直接影響を与えます。

ただし、多くのPythonのAIライブラリは内部的にC++やFortranで実装されているため、NumPyやTensorFlowなどのライブラリを適切に使用すれば、実用上十分な速度を確保できます。問題となるのは、主にPythonの標準機能だけで複雑な処理を行おうとする場合です。

処理速度の課題への具体的な対策としては、以下のアプローチが有効です。

- ベクトル化処理の活用:NumPyの配列演算を利用してループを避け、処理を高速化する

- 並列処理の導入:multiprocessingやjoblibを使用して複数のCPUコアを活用する

- JITコンパイラの利用:NumbaやPyPyなどのツールでPythonコードを最適化する

- GPUの活用:CUDAを通じてGPU演算を行い、大規模な行列計算を高速化する

他言語や外部ツールとの連携による対応

Pythonの弱点を補う最も実践的な方法は、他のプログラミング言語や外部ツールとの連携です。実際の企業レベルのAI開発では、Pythonだけで完結させるのではなく、各言語の長所を活かしたハイブリッドアプローチが採用されています。

具体的な連携パターンとして、以下のような手法が広く活用されています。

- C/C++との統合:処理速度が求められる部分をC/C++で実装し、ctypesやPybind11を通じてPythonから呼び出す

- Cythonの活用:PythonコードをC言語に変換してコンパイルし、実行速度を大幅に向上させる

- Rustとの連携:メモリ安全性と高速性を兼ね備えたRustで重要な処理を実装し、PyO3経由で統合する

- 外部APIの利用:推論処理を最適化されたAPIサービスに委託し、Pythonは制御部分のみを担当する

モデルのデプロイメント段階では、さらに多様な連携手法が用いられます。Pythonで開発・学習したモデルを、ONNX(Open Neural Network Exchange)などの中間フォーマットに変換することで、C++やJavaなどの高速な実行環境に移植できます。これにより、開発時はPythonの生産性を活かし、本番環境では他言語の性能を享受するという、理想的な開発フローが実現します。

また、以下のような外部ツールとの連携も効果的です。

| ツール・技術 | 用途 | メリット |

|---|---|---|

| Docker | 環境の標準化と配布 | 依存関係の問題を解消し、デプロイを簡素化 |

| Apache Spark | 大規模データ処理 | 分散処理により膨大なデータを効率的に扱える |

| Kubernetes | AIモデルのスケーリング | 負荷に応じた自動スケールと高可用性を実現 |

| TensorRT | 推論の最適化 | NVIDIAのGPUで推論速度を劇的に向上 |

エッジデバイスやモバイル環境へのデプロイでは、TensorFlow LiteやPyTorch Mobileを使用して、モデルを軽量化・最適化します。これにより、Pythonで開発したAIモデルを、スマートフォンやIoTデバイスなどのリソースが限られた環境でも効率的に動作させることが可能になります。

さらに、クラウドサービスとの連携も重要な対策の一つです。Amazon SageMaker、Google Cloud AI Platform、Azure Machine Learningなどのサービスを活用すれば、インフラの管理負担を軽減しながら、スケーラブルなAIシステムを構築できます。これらのプラットフォームは、Pythonのコードをそのまま利用できる一方で、バックエンドでは最適化された実行環境を提供してくれます。

重要なのは、Pythonの弱点を認識しつつ、適材適所で他の技術を組み合わせるという発想です。すべてをPythonで解決しようとするのではなく、開発効率が求められる部分ではPythonを、実行速度が重視される部分では他言語を、というように柔軟にアプローチすることで、AI開発プロジェクト全体の成功確率を高めることができます。

“`

“`html

よくある質問

PythonとAI開発に関して、初学者や開発者からよく寄せられる質問をまとめました。これからAI開発を始める方や、Pythonの活用を検討している方は、ぜひ参考にしてください。

PythonがAI開発に適している理由は何ですか

PythonがAI開発に適している理由は、大きく分けて技術的な優位性と環境的な充実度の2つの観点から説明できます。

まず技術的な面では、豊富なライブラリとフレームワークが揃っている点が挙げられます。NumPy、Pandas、scikit-learn、TensorFlow、Kerasなど、AI開発に必要な機能がパッケージ化されており、複雑な数学的処理やアルゴリズムを簡単に実装できます。これにより開発者は、アルゴリズムの細部を一から実装する必要がなく、本質的な問題解決に集中できるのです。

次に、Pythonのコードはシンプルで読み書きしやすいという特徴があります。C++やJavaと比較して、少ないコード量で同等の処理を記述でき、可読性も高いため、チーム開発やコードのメンテナンスが容易です。特にAI開発では試行錯誤が多いため、この手軽さが開発スピードの向上につながります。

環境的な面では、コミュニティが非常に活発で、情報が豊富に得られる点が重要です。技術的な問題に直面した際も、Stack OverflowやGitHub、各種フォーラムで解決策を見つけやすく、学習コストが低く抑えられます。また、Google、Facebook、Microsoftなどの大手企業が採用していることから、信頼性と将来性も保証されています。

さらに、オープンソースで無料という点も大きな魅力です。環境構築から本格的な開発まで、コストをかけずに始められるため、個人開発者から企業まで幅広く利用されています。

Pythonで実現できることは何ですか

Pythonは非常に汎用性の高い言語であり、AI分野だけでなく幅広い領域で活用されています。それぞれの分野における具体的な実現内容を見ていきましょう。

AI・機械学習分野では、画像認識や自然言語処理、音声認識などの高度なタスクが実現できます。顔認証システム、物体検出、医療画像の診断支援、チャットボット、感情分析、機械翻訳など、多様なアプリケーションを開発可能です。また、予測分析の分野では、株価予測、需要予測、顧客行動分析なども実装できます。

データ分析・可視化の領域では、PandasやMatplotlibを使って大量のデータを処理し、わかりやすいグラフやチャートで可視化できます。ビジネスインテリジェンス、マーケティング分析、科学研究など、データドリブンな意思決定を支援するツールを構築できます。

Webアプリケーション開発も得意分野の一つです。DjangoやFlaskといったフレームワークを使えば、SNS、ECサイト、管理システムなどの本格的なWebサービスを開発できます。特にAI機能を組み込んだWebアプリケーションの開発において、Pythonは強力な選択肢となります。

その他にも、自動化スクリプト、スクレイピング、IoTシステム、ゲーム開発、科学技術計算など、Pythonの応用範囲は非常に広範です。一つの言語を習得することで、多様なプロジェクトに対応できる点が、Pythonの大きな魅力となっています。

独学でAI開発を習得することは可能ですか

結論から言えば、独学でAI開発を習得することは十分に可能です。ただし、効率的に学習を進めるためには、適切な学習リソースと計画的なアプローチが必要になります。

まず、学習リソースが豊富に揃っている点が独学を可能にしています。オンライン学習プラットフォーム(Progate、ドットインストール、Udemy)、無料のチュートリアル、YouTube動画、技術ブログなど、初心者から上級者まで対応した教材が多数公開されています。書籍も充実しており、体系的な知識を身につけることができます。

また、Google Colaboratoryのような無料の開発環境が利用できるため、高価な機材を購入しなくても実践的な学習が可能です。GPUを使った高速な計算も無料で試せるため、本格的なディープラーニングの実験も行えます。

独学を成功させるポイントとしては、以下のような段階的なアプローチが有効です。まずPython基礎をしっかり固めることから始め、その後NumPyやPandasなどの基本ライブラリを学習します。次に機械学習の理論を理解しながら、scikit-learnで簡単なモデルを実装し、最終的にディープラーニングへと進んでいくという流れです。

ただし、独学にはモチベーション維持の難しさや、エラー解決に時間がかかるというデメリットもあります。これを克服するためには、実際に興味のあるテーマでプロジェクトを作ってみる、オンラインコミュニティに参加する、定期的に成果を発信するなどの工夫が効果的です。必要に応じてプログラミングスクールやメンターのサポートを受けることも、学習効率を高める選択肢となります。

PythonとAIの関係性について教えてください

PythonとAIの関係性は、「AIを実現するための主要なツール」という位置づけで理解すると分かりやすいでしょう。PythonはAI技術そのものではなく、AI開発を効率的に行うためのプログラミング言語です。

歴史的な背景を見ると、AI研究は1950年代から始まりましたが、当初は主にLispやPrologといった言語が使われていました。しかし、2000年代以降の機械学習ブームにおいて、Pythonが科学技術計算分野での実績を背景に、AI開発の標準的な言語として急速に普及しました。

現在のAI開発において、Pythonは「データから学習するプログラムを作成する言語」として機能しています。従来のプログラミングでは、開発者がルールを明示的にコードで記述する必要がありましたが、AI開発では「データを読み込む→学習アルゴリズムを適用する→モデルを評価する→予測に使う」というプロセスをPythonで記述します。

具体的には、Pythonで記述されたコードが、TensorFlowやKerasといったフレームワークを通じてニューラルネットワークの構造を定義し、大量のデータから特徴を自動的に学習させます。この学習プロセスを制御し、最適化するための柔軟性と表現力を、Pythonが提供しているのです。

また、AI開発は研究開発から実用化まで一貫して行う必要があるため、プロトタイピングから本番環境への展開まで対応できるPythonの特性が重要視されています。実験的なモデル構築から、Webサービスへの組み込み、APIの公開まで、一つの言語で完結できる点が、PythonとAIの強固な関係性を支えています。

つまり、AIという目的地に到達するための最適な乗り物がPythonであると表現できます。他の言語でもAI開発は可能ですが、現時点ではPythonが最も効率的で実用的な選択肢として、業界標準の地位を確立しています。

“`

“`html

まとめ

本記事では、PythonとAI開発の関係性について、基礎知識から実践的な開発手順、具体的な活用事例まで幅広く解説してきました。最後に、これまでの内容を振り返りながら、Python×AI開発の全体像を整理しておきましょう。

PythonがAI開発において圧倒的な支持を得ている理由は、豊富なライブラリとフレームワークの存在、初心者にも理解しやすいシンプルな文法、そして活発なコミュニティによる充実したサポート体制にあります。NumPyやPandas、scikit-learn、TensorFlow、Kerasといった強力なツールが無料で利用できる環境は、個人から企業まで幅広い開発者にとって大きなメリットとなっています。

AI技術の中核となる機械学習とディープラーニングは、教師あり学習、教師なし学習、強化学習といった複数のアプローチがあり、それぞれ適用すべき課題や場面が異なります。データの準備から前処理、モデルの構築、評価、調整という一連のプロセスを理解することで、実用的なAIシステムの開発が可能になります。

実践面では、画像認識や自然言語処理、予測分析など、多様な分野でPythonによるAI開発が活躍しています。自動運転技術、顔認証システム、株価予測、医療診断支援など、私たちの日常生活やビジネスシーンにおいて、すでにPythonで開発されたAIが数多く実装されています。

学習方法についても、入門書籍やオンライン学習サイト、プログラミングスクールなど、多様な選択肢が用意されています。特にGoogle Colaboratoryのような無料で高性能な開発環境が利用できることは、初心者がAI開発をスタートする上で大きな後押しとなるでしょう。

Pythonには処理速度の課題という弱点も存在しますが、他言語との連携や外部ツールの活用によって対応可能です。実際の開発現場では、プロトタイピングや研究段階ではPythonを使い、本番環境では必要に応じて高速化を図るといったハイブリッドなアプローチが取られています。

AI技術は日々進化しており、新しいライブラリやフレームワークが次々と登場しています。しかし、Pythonという共通基盤を習得しておけば、これらの新技術にも柔軟に対応できるという点が、Python学習の大きな価値と言えるでしょう。

これからAI開発を始める方は、まず基礎的なPython文法を学び、次に機械学習の基本概念を理解し、実際に手を動かしてサンプルコードを実行してみることをおすすめします。小さなプロジェクトから始めて、徐々に複雑な課題に挑戦していくことで、実践的なスキルが着実に身につくはずです。

PythonとAIの組み合わせは、今後もテクノロジー分野における中心的な存在であり続けるでしょう。本記事で紹介した知識や手法を活用し、ぜひ皆さんも創造的なAI開発に挑戦してみてください。

“`