この記事では、画像認識で広く使われるCNN(畳み込みニューラルネットワーク)の基礎概念から実装まで体系的に学習できます。畳み込み、プーリング、全結合層といった構成要素の仕組みや、局所受容野・重み共有などの特徴を理解し、TensorFlowを使ったMNIST文字認識の実装方法まで習得可能です。AI・機械学習初心者がCNNの全体像を掴み、実践的なスキルを身につけたい悩みを解決します。

目次

畳み込みニューラルネットワークの基礎知識

畳み込みニューラルネットワーク(Convolutional Neural Network、CNN)は、機械学習における深層学習の手法の一つであり、特に画像認識や画像処理において革命的な成果を上げているアーキテクチャです。このセクションでは、CNNの基本的な概念から具体的な特徴、そして実際の応用分野まで、convolution neural networkの全体像について詳しく解説していきます。

CNNの定義と概要

畳み込みニューラルネットワーク(CNN)は、生物の視覚皮質の構造にヒントを得て開発された深層学習モデルです。CNNは畳み込み層(Convolutional Layer)、プーリング層(Pooling Layer)、全結合層(Fully Connected Layer)という3つの主要な層から構成されており、これらの層が階層的に組み合わされることで、複雑なパターン認識を可能にしています。

CNNの核となる畳み込み演算は、入力データに対してフィルター(カーネル)を適用することで特徴を抽出する仕組みです。この処理により、エッジ、テクスチャ、形状などの視覚的特徴を段階的に学習していきます。convolution neural networkの名前の由来でもある畳み込み演算は、数学的には以下のような処理を行います:

- 入力画像に対して小さなフィルター(通常3×3や5×5のサイズ)をスライドさせながら適用

- 各位置でフィルターと入力データの要素同士を掛け合わせて合計値を計算

- この処理を繰り返すことで特徴マップ(Feature Map)を生成

- 複数のフィルターを使用することで、異なる特徴を並行して抽出

プーリング層では、特徴マップのサイズを縮小しながら重要な情報を保持する処理が行われます。最も一般的なマックスプーリングでは、指定された領域内の最大値を取得することで、位置の微小な変化に対する不変性を獲得できます。

従来のニューラルネットワークとの違い

従来の全結合ニューラルネットワーク(Fully Connected Neural Network)と比較すると、convolution neural networkには明確な構造的・機能的な違いが存在します。これらの違いを理解することで、CNNがなぜ画像処理において優れた性能を発揮するのかが明確になります。

最も重要な違いは、CNNが局所的な特徴抽出に特化した構造を持っている点です。従来のニューラルネットワークでは、すべてのニューロンが前の層のすべてのニューロンと接続されているため、画像のような高次元データを扱う際に以下のような問題が発生していました:

| 比較項目 | 従来のニューラルネットワーク | CNN |

|---|---|---|

| 接続方式 | 全結合(すべてのニューロンが接続) | 局所結合(局所的な領域のみ接続) |

| パラメータ数 | 非常に多い | 重み共有により大幅に削減 |

| 空間的構造 | 考慮されない | 保持される |

| 計算効率 | 低い | 高い |

CNNでは重み共有(Weight Sharing)という概念により、同じフィルターを画像全体に適用することで、学習すべきパラメータ数を劇的に削減しています。例えば、32×32ピクセルの画像を扱う場合、従来の全結合層では1024個の入力に対してすべての組み合わせの重みが必要でしたが、CNNでは数個のフィルターで済むため、過学習のリスクが大幅に軽減されます。

また、CNNは平行移動不変性(Translation Invariance)という重要な特性を持っています。これは、画像内のオブジェクトの位置が多少変わっても同様に検出できる能力を指し、実世界の画像認識において非常に重要な特徴となっています。

CNNが解決できる課題と問題領域

Convolution neural networkは、その独特な構造により様々な分野の課題解決に貢献しています。特に視覚的な情報処理において革新的な成果を上げており、従来の手法では困難とされていた多くの問題を解決可能にしました。

画像認識分野では、CNNの導入により認識精度が飛躍的に向上しました。具体的に解決できる課題は以下のようなものです:

- 物体認識・分類:写真に写っている物体が何であるかを判定する問題。ImageNetチャレンジでは、CNNベースのモデルが人間の認識精度を上回る結果を達成しています。

- 物体検出:画像内の複数の物体を検出し、それぞれの位置と種類を特定する問題。自動運転車の歩行者検出や、医療画像での病変部位の特定などに応用されています。

- セマンティックセグメンテーション:画像内のすべてのピクセルに対してクラスラベルを付与する問題。衛星画像の土地利用分類や、医療画像での臓器セグメンテーションに活用されています。

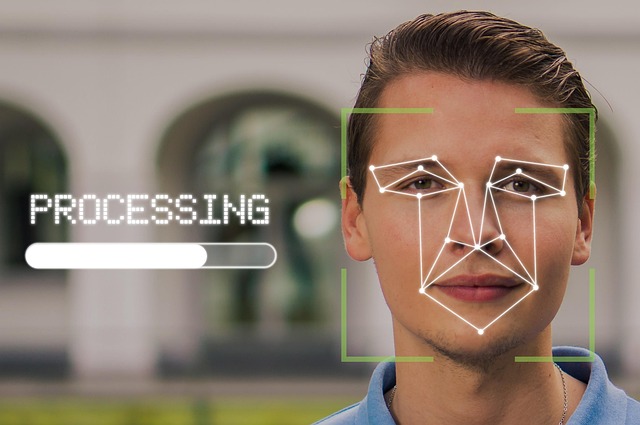

- 顔認識・表情認識:人物の顔を識別したり、感情状態を判定する問題。セキュリティシステムやマーケティング分野での応用が進んでいます。

画像処理以外の分野でも、CNNの応用範囲は拡大しています:

- 自然言語処理:テキストの感情分析や文書分類において、単語の局所的な関係性を捉えるためにCNNが使用されています

- 音声認識:スペクトログラムを画像として扱い、音声パターンの認識にCNNを適用する手法が開発されています

- 時系列データ解析:株価予測や気象予測において、時間的な局所パターンを抽出するためにCNNが活用されています

- 医療診断:X線画像、CT画像、MRI画像などの医療画像から病気の兆候を検出する診断支援システムに応用されています

ただし、CNNにも限界があり、回転に対する不変性が限定的であることや、大量の学習データが必要であること、計算リソースを多く消費することなどの課題も存在します。これらの課題に対しては、データ拡張技術やTransfer Learning、より効率的なアーキテクチャの開発などによって対応が進められています。

畳み込みニューラルネットワークの核となる特徴

Convolution Neural Network(CNN)は、従来のニューラルネットワークと比較して画像認識において革新的な性能を実現する深層学習手法です。その優れた性能の背景には、畳み込み処理、局所受容野、重み共有、平行移動不変性という4つの核となる特徴があります。これらの特徴により、CNNは画像データの空間的な構造を効率的に学習し、高精度な特徴抽出を可能にしています。

畳み込み処理の仕組み

畳み込み処理は、Convolution Neural Networkの名前の由来となる最も重要な演算です。この処理では、入力画像に対して小さなフィルタ(カーネル)を適用し、局所的な特徴を抽出します。

具体的な畳み込み処理の流れは以下の通りです:

- フィルタが入力画像の左上から開始位置を決定

- フィルタの各要素と対応する画像の画素値を掛け合わせ

- すべての積の総和を計算して出力値を生成

- フィルタを一定の間隔(ストライド)で移動させて処理を繰り返し

この畳み込み演算により、エッジ検出、テクスチャ認識、形状パターンの抽出など、様々な視覚的特徴を自動的に学習できます。複数のフィルタを同時に適用することで、多様な特徴を並列に抽出し、豊富な特徴マップを生成することが可能です。

局所受容野による特徴抽出

局所受容野は、各ニューロンが入力データの限定された領域のみに接続する構造を指します。この概念は、人間の視覚野における神経細胞の働きを模倣したものであり、Convolution Neural Networkの効率的な学習を支える重要な要素です。

従来の全結合層では、すべての入力ピクセルがすべての出力ニューロンに接続されていました。しかし、局所受容野を採用することで以下の利点が得られます:

- 計算効率の向上:接続数を大幅に削減し、メモリ使用量と計算時間を削減

- 局所的特徴の強化:近隣ピクセル間の空間的関係性を効果的に捉える

- 過学習の抑制:パラメータ数の削減により汎化性能が向上

- 階層的特徴学習:浅い層で単純な特徴、深い層で複雑な特徴を段階的に学習

この局所受容野の概念により、画像の空間的構造を保持しながら効率的な特徴抽出が実現されています。

重み共有による効率化

重み共有は、Convolution Neural Networkにおける革新的なアプローチの一つです。同一のフィルタを画像全体にわたって適用することで、位置に関係なく同じ重みパラメータを共有します。

重み共有がもたらす具体的な効果は以下の通りです:

| 効果 | 従来手法との比較 | メリット |

|---|---|---|

| パラメータ削減 | 全結合層の数百万から数千への大幅削減 | メモリ効率の向上 |

| 学習安定性 | 少ないパラメータで効率的な最適化 | 学習時間の短縮 |

| 汎化性能 | 過学習リスクの大幅な低減 | 未知データへの適応力向上 |

さらに、重み共有により同一の特徴検出器を画像全体で使用することで、位置に依存しない一貫した特徴抽出が可能になります。この仕組みにより、CNNは効率的でありながら高精度な画像認識を実現しています。

平行移動に対する不変性

平行移動不変性は、Convolution Neural Networkが画像内のオブジェクトの位置変化に対して頑健性を示す重要な特性です。この特性により、同じオブジェクトが画像内のどの位置にあっても、一貫した認識結果を得ることができます。

平行移動不変性は、以下の技術的要素の組み合わせによって実現されています:

畳み込み演算の局所性と重み共有により、フィルタは画像内の任意の位置で同じ特徴を検出できる。さらに、プーリング層による空間的な次元削減が、位置の微小な変化に対する頑健性を提供する。

この不変性がもたらす実用的な利点は多岐にわたります:

- 物体検出の安定性:オブジェクトが画像内で移動しても正確な認識を維持

- データ拡張効果:限られた学習データから多様な位置パターンを学習

- 実用性の向上:カメラ角度や被写体位置の変化に対する頑健性

- 特徴の抽象化:位置情報よりも形状や模様などの本質的特徴に集中

ただし、完全な平行移動不変性は必ずしも全てのタスクで望ましいとは限らないため、近年では位置情報を保持する手法も研究されています。このように、Convolution Neural Networkは平行移動不変性という特性を活用しながら、様々な画像認識タスクに対応する柔軟性を備えています。

CNNを構成する主要レイヤーの詳細

Convolution Neural Network(CNN)は、画像認識や音声処理などの分野で革命的な成果を上げている深層学習アーキテクチャです。CNNの優れた性能は、その構成要素である各レイヤーの特性と役割によって実現されています。本章では、CNNを構成する主要なレイヤーである畳み込み層、プーリング層、全結合層、そして活性化関数について詳しく解説します。

畳み込み層の役割と動作原理

畳み込み層(Convolutional Layer)は、Convolution Neural Networkの核心となる構成要素であり、入力データから特徴を抽出する重要な役割を担っています。この層では、フィルター(カーネル)と呼ばれる小さな重み行列を入力データ上でスライドさせながら畳み込み演算を実行します。

動作原理として、畳み込み層は以下のプロセスで機能します。まず、入力画像に対してフィルターを左上から右下に向かって移動させ、各位置でフィルターと入力データの要素積の和を計算します。この計算により得られた値が特徴マップ(Feature Map)を構成し、エッジ、コーナー、テクスチャなどの局所的な特徴を検出できます。

畳み込み層の最大の利点は、位置不変性と局所的な特徴抽出能力です。同じフィルターを画像全体に適用することで、画像内のどの位置にある特徴も等しく検出でき、パラメータ数を大幅に削減しながら効率的な学習を実現します。また、複数のフィルターを使用することで、さまざまな種類の特徴を同時に抽出することが可能になります。

プーリング層による次元削減

プーリング層(Pooling Layer)は、Convolution Neural Networkにおいて特徴マップのサイズを縮小し、計算量を削減する重要な役割を果たします。この層は畳み込み層の後に配置され、空間的な次元を減少させながら重要な特徴情報を保持します。プーリング操作により、モデルの計算効率が向上し、過学習の抑制にも寄与します。

最大プーリングの特徴

最大プーリング(Max Pooling)は、指定されたウィンドウ内の最大値を選択する操作です。この手法の主な特徴は、局所的な領域で最も強い特徴を保持することにあります。例えば、2×2のウィンドウを使用した場合、4つの値の中から最大値のみを出力として選択し、特徴マップのサイズを半分に縮小します。最大プーリングは、エッジや角などの顕著な特徴を強調し、小さな位置変化に対する不変性を提供します。

平均プーリングの特徴

平均プーリング(Average Pooling)は、指定されたウィンドウ内の全ての値の平均を計算する操作です。最大プーリングとは異なり、局所領域の全体的な情報を滑らかに統合します。平均プーリングの利点は、ノイズの影響を軽減し、より安定した特徴表現を提供することです。特に、テクスチャや色調の変化など、連続的な特徴を扱う場合に有効であり、画像の全体的な傾向を捉えるのに適しています。

グローバル平均プーリングの活用

グローバル平均プーリング(Global Average Pooling)は、各特徴マップ全体の平均値を計算し、1つの値に集約する操作です。この手法は、全結合層を置き換える革新的なアプローチとして注目されています。従来の全結合層と比較して、パラメータ数を大幅に削減でき、過学習のリスクを軽減します。また、特徴マップと出力クラスの対応関係がより直接的になり、モデルの解釈性が向上する利点があります。現代のCNNアーキテクチャにおいて、分類タスクの最終段階で広く採用されています。

全結合層の機能と限界

全結合層(Fully Connected Layer)は、Convolution Neural Networkにおいて最終的な分類や回帰を行う層として機能します。この層では、前の層の全てのニューロンが次の層の全てのニューロンと接続され、抽出された特徴を統合して最終的な出力を生成します。畳み込み層とプーリング層によって抽出された局所的な特徴を、全体的な判断に結びつける重要な役割を担っています。

全結合層の基本的な動作は、入力ベクトルと重み行列の線形変換です。畳み込み層から出力された特徴マップを一次元のベクトルに変換し、重みとバイアスを用いて各出力ニューロンの値を計算します。この計算により、複雑な非線形関係を学習し、高次元の特徴空間から最終的な予測値を導出できます。

全結合層が抱える課題

全結合層には重要な課題が存在します。最も深刻な問題は、パラメータ数の爆発的な増加です。例えば、224×224の入力画像を扱う場合、最初の全結合層だけで数千万のパラメータが必要になることがあります。これにより、メモリ使用量が増大し、学習時間が大幅に延長されます。

さらに、過学習のリスクが高まることも重要な課題です。大量のパラメータにより、モデルが訓練データに過度に適合し、未知のデータに対する汎化性能が低下する可能性があります。また、全結合層は入力サイズが固定されるため、異なる解像度の画像を扱う際の柔軟性に欠けるという制約もあります。これらの課題により、現代のCNNアーキテクチャでは全結合層の使用を最小限に抑える傾向が見られます。

活性化関数の種類と選択指針

活性化関数(Activation Function)は、Convolution Neural Networkにおいて非線形性を導入する重要な構成要素です。線形変換のみでは表現できない複雑なパターンを学習するために、各層の出力に活性化関数を適用します。適切な活性化関数の選択は、モデルの学習効率と性能に大きな影響を与えるため、各関数の特性を理解することが重要です。

ReLU関数の特性

ReLU(Rectified Linear Unit)関数は、現代のConvolution Neural Networkで最も広く使用される活性化関数です。ReLU関数の最大の特徴は、計算の単純さと勾配消失問題の軽減にあります。この関数は、入力が正の場合はそのまま出力し、負の場合は0を出力する単純な構造を持ちます。

ReLU関数の利点として、計算コストが非常に低く、深いネットワークでも勾配が効率的に伝播することが挙げられます。また、スパース性を促進し、ネットワークの表現能力を向上させます。ただし、負の入力に対して完全に不活性になる「Dying ReLU」問題が存在するため、学習率の調整や重みの初期化に注意が必要です。

シグモイド関数の適用場面

シグモイド関数は、出力を0から1の範囲に制限する活性化関数で、特に二値分類問題の出力層で使用されます。この関数の主な特徴は、滑らかな曲線と確率的な解釈が可能な出力にあります。シグモイド関数は、医療診断や異常検知など、予測結果を確率として解釈したい場面で特に有効です。

しかし、シグモイド関数は深層ネットワークの隠れ層では勾配消失問題を引き起こしやすいという課題があります。出力の飽和領域では勾配が非常に小さくなり、深い層への誤差伝播が困難になります。そのため、現代のCNNでは主に出力層での使用に限定される傾向があります。

タンハイパボリック関数の利用

タンハイパボリック関数(tanh)は、出力を-1から1の範囲に制限する活性化関数です。シグモイド関数と比較して、零点対称性を持つことが大きな特徴です。この対称性により、入力データの正規化効果があり、学習の収束が改善される場合があります。

tanh関数は、自然言語処理や時系列データの解析において、双方向の情報を扱う場合に特に有効です。また、LSTMやGRUなどのリカレント層では、ゲート機構の一部として重要な役割を果たします。ただし、シグモイド関数と同様に勾配消失問題の影響を受けやすいため、深層のConvolution Neural Networkでは慎重な使用が求められます。

CNNの学習に関わる重要な技術要素

Convolution Neural Network(CNN)は画像認識や音声処理などの分野で革命的な成果を上げている深層学習アーキテクチャです。しかし、CNNを効果的に学習させるためには、単に畳み込み層を重ねるだけでは不十分で、様々な技術要素を適切に組み合わせることが重要です。これらの技術要素は、学習の安定性、汎化性能の向上、計算効率の改善において中核的な役割を果たしています。

パディング処理による境界対応

パディング処理は、Convolution Neural Networkにおいて入力データの境界部分での情報損失を防ぐ重要な技術です。畳み込み演算を行う際、フィルターが入力画像の端の部分に適用されると、出力サイズが縮小されてしまいます。

パディング処理により、入力データの周囲に値を追加することで、元の入力サイズを保持できます。最も一般的なゼロパディングでは、入力の境界に0の値を埋め込み、畳み込み演算後も空間解像度を維持します。これにより、深いネットワークでも特徴マップのサイズが急激に減少することを防げます。

また、境界部分の画素情報も適切に学習に活用されるため、画像の端に重要な特徴がある場合でも、それらを見逃すことなく検出できるようになります。特に医療画像や衛星画像などの専門分野では、境界情報が診断や解析の精度に大きく影響するため、適切なパディング戦略が不可欠です。

ストライドによる出力サイズ調整

ストライドは、Convolution Neural Networkにおいて畳み込みフィルターの移動幅を制御するパラメータであり、出力特徴マップのサイズと計算量を決定する重要な要素です。ストライド値を調整することで、ネットワークの計算効率と特徴抽出の粒度を最適化できます。

ストライド1の場合、フィルターは1画素ずつ移動するため、入力の詳細な情報を保持できますが、計算量が増加します。一方、ストライド2以上に設定すると、フィルターの移動幅が大きくなり、出力サイズが縮小される代わりに計算量を削減できます。この特性を活用して、プーリング層を使わずにダウンサンプリングを実現することも可能です。

実際の応用では、初期層では細かい特徴を捉えるためにストライド1を使用し、深い層では大局的な特徴を抽出するためにより大きなストライドを採用する階層的な設計が効果的です。また、計算リソースが限られた環境では、ストライドを大きく設定することで、性能を大幅に犠牲にすることなく処理速度を向上させられます。

バックプロパゲーションによる重み更新

バックプロパゲーションは、Convolution Neural Networkの学習において最も基本的かつ重要なメカニズムです。この手法により、ネットワークの出力と正解との誤差を逆方向に伝播させ、各層の重みパラメータを適切に更新していきます。

CNNにおけるバックプロパゲーションは、通常のニューラルネットワークと比較して複雑な計算過程を要します。畳み込み層では、フィルターの重みが複数の出力ユニットで共有されているため、勾配の計算時には全ての共有位置からの寄与を合計する必要があります。この重み共有メカニズムにより、パラメータ数を大幅に削減しながら、効率的な特徴学習を実現できます。

プーリング層におけるバックプロパゲーションでは、最大プーリングの場合は最大値の位置にのみ勾配が伝播され、平均プーリングでは均等に分散されます。これらの勾配計算の精度が、ネットワーク全体の学習性能に直接影響するため、数値的安定性を保つための工夫も重要な技術要素となります。

ハイパーパラメータの最適化手法

Convolution Neural Networkの性能を最大化するためには、学習率、バッチサイズ、エポック数、正則化パラメータなどのハイパーパラメータを適切に調整することが不可欠です。これらのパラメータは相互に影響し合うため、体系的な最適化手法が求められます。

グリッドサーチは従来から使われている手法ですが、パラメータ空間が高次元になると計算コストが指数的に増加します。そこで、ランダムサーチやベイズ最適化などの効率的な探索手法が注目されています。特にベイズ最適化は、過去の試行結果を基に次の探索点を賢く選択するため、少ない試行回数で良好な解を見つけられます。

近年では、学習率スケジューリングや適応的学習率手法(Adam、RMSprop等)の活用により、手動でのハイパーパラメータ調整の負担が軽減されています。また、AutoMLの発展により、Neural Architecture Search(NAS)を用いてネットワーク構造自体を自動最適化する技術も実用化が進んでいます。

バッチ正規化による学習安定化

バッチ正規化は、Convolution Neural Networkの学習を劇的に安定化させる技術として、現代のCNNアーキテクチャに欠かせない要素となっています。この手法は、各層の入力分布を正規化することで、内部共変量シフトの問題を解決し、より高速で安定した学習を可能にします。

具体的には、ミニバッチ内のデータに対して平均を0、分散を1に正規化した後、学習可能なスケールパラメータとシフトパラメータを適用します。これにより、勾配の爆発や消失を抑制し、より大きな学習率での学習が可能になります。また、正則化効果も持つため、過学習の抑制にも寄与します。

バッチ正規化の導入により、従来は困難だった非常に深いネットワークの学習が実現可能になりました。ResNetやDenseNetなどの最新アーキテクチャでは、バッチ正規化が標準的に採用されており、画像認識タスクにおいて人間を上回る精度を達成する重要な要因となっています。ただし、バッチサイズが小さい場合や推論時の統計量の扱いなど、実装上の注意点も存在します。

ドロップアウトによる過学習防止

ドロップアウトは、Convolution Neural Networkにおける過学習を効果的に防止する正則化手法として広く採用されています。この技術は、学習時にランダムにニューロンの一部を無効化することで、特定のニューロンへの過度な依存を防ぎ、汎化性能を向上させます。

CNNにおけるドロップアウトの適用では、全結合層だけでなく畳み込み層にも適用可能です。畳み込み層では、特徴マップ全体をドロップアウトするSpatial Dropoutや、個別の画素をランダムに選択するStandard Dropoutなど、複数の手法が存在します。適切なドロップアウト率(通常0.2~0.5)を設定することで、学習データへの過適合を防ぎながら、テストデータでの性能を向上させることができます。

ドロップアウトの効果は、アンサンブル学習に類似しており、学習時に多数の異なるネットワーク構造を暗黙的に学習することになります。推論時にはすべてのニューロンを使用し、重みをドロップアウト率で調整することで、アンサンブル効果を近似します。ただし、バッチ正規化との併用時には相互作用に注意が必要で、適用順序や設定値の調整が重要になります。

画像認識におけるCNNの応用

Convolution Neural Network(CNN)は、画像認識分野において革命的な変化をもたらした深層学習技術です。従来の機械学習手法では困難だった複雑な画像パターンの認識を可能にし、現在では様々な産業分野で実用化されています。CNNの特徴的な畳み込み層とプーリング層により、画像の局所的な特徴を効率的に抽出し、階層的に学習することで高精度な画像認識を実現しています。

物体検出・分類システム

物体検出・分類システムは、Convolution Neural Networkの最も代表的な応用分野の一つです。このシステムでは、画像内に存在する複数の物体を同時に検出し、それぞれを適切なカテゴリに分類する高度な処理を行います。

CNNベースの物体検出システムでは、主に以下のアプローチが採用されています:

- Two-stage検出方式:候補領域の生成と分類を段階的に実行

- One-stage検出方式:検出と分類を同時に処理し高速化を実現

- Attention機構の活用:重要な領域に焦点を当てた効率的な処理

- マルチスケール特徴抽出:異なるサイズの物体に対応する柔軟性

製造業では品質管理システムにおいて不良品の自動検出に活用され、小売業では商品の自動認識による在庫管理システムに導入されています。また、セキュリティ分野では監視カメラ映像からの異常行動検出など、多岐にわたる用途で実用化が進んでいます。

顔認証技術への応用

顔認証技術におけるConvolution Neural Networkの活用は、セキュリティシステムの精度向上に大きく貢献しています。CNNは人間の顔の複雑な特徴パターンを学習し、個人識別に必要な固有の特徴量を効率的に抽出することができます。

CNN基盤の顔認証システムの核となる技術要素:

- 顔検出フェーズ:画像内から人の顔領域を正確に特定

- 特徴抽出フェーズ:畳み込み層による顔の特徴量の階層的学習

- 特徴マッチングフェーズ:登録済みデータベースとの類似度計算

- 認証判定フェーズ:閾値に基づく最終的な本人確認

現代の顔認証システムでは、照明条件の変化、表情の違い、部分的な遮蔽といった困難な条件下でも高い認識精度を維持できます。スマートフォンのロック解除、空港の出入国管理、オフィスビルのアクセス制御など、日常生活の様々な場面で活用されており、従来のパスワードや物理的な鍵に代わる次世代認証技術として注目されています。

自動運転での画像解析

自動運転技術において、Convolution Neural Networkによる画像解析は車両の安全な走行を支える中核技術として位置づけられています。車載カメラから取得される膨大な視覚情報をリアルタイムで処理し、周囲環境の正確な理解を可能にしています。

自動運転システムでCNNが担う主要な画像解析機能:

| 解析対象 | 機能概要 | 重要度 |

|---|---|---|

| 車線検出 | 道路の車線境界線を識別し走行ルートを決定 | 最高 |

| 交通標識認識 | 速度制限や一時停止などの標識を判別 | 最高 |

| 歩行者検出 | 道路周辺の歩行者を特定し衝突回避 | 最高 |

| 他車両追跡 | 周囲車両の位置と動きを継続的に監視 | 高 |

特に複雑な都市環境では、CNNの深層学習能力により、従来の画像処理技術では対応困難だった動的な環境変化への適応が可能となっています。天候条件の変化、時間帯による照明の違い、複雑な交通状況など、様々な条件下での安定した認識性能を実現し、自動運転の実用化に向けた重要な技術基盤を提供しています。

医療画像診断システム

医療分野におけるConvolution Neural Networkの応用は、画像診断の精度向上と効率化において革新的な成果をもたらしています。放射線科医の診断支援から病変の早期発見まで、CNNは医療現場の様々な課題解決に貢献しています。

医療画像診断でのCNN活用領域の展開:

「CNNによる医療画像解析は、人間の医師が見落としがちな微細な病変パターンも検出可能であり、診断精度の向上と医療従事者の負担軽減を同時に実現している」

具体的な医療画像診断への応用例:

- X線画像解析:肺炎、結核、骨折などの異常所見の自動検出

- CT・MRI画像診断:腫瘍の形状・サイズ・位置の正確な特定

- 病理組織画像:がん細胞の識別と悪性度の評価

- 眼底写真解析:糖尿病網膜症や緑内障の早期診断

- 皮膚画像診断:メラノーマなど皮膚がんの識別支援

これらのシステムでは、大量の医療画像データを学習したCNNモデルが、専門医レベルの診断精度を達成するケースも報告されています。特に画像の微細な変化を捉える能力に優れ、早期段階での疾患発見に大きく貢献しています。医療現場では診断時間の短縮と見落としリスクの軽減により、患者により良質な医療サービスの提供が可能となっています。

実装環境とフレームワーク

Convolution Neural Network(CNN)の実装において、適切な環境とフレームワークの選択は開発効率と性能に大きく影響します。現代のディープラーニング開発では、多様なフレームワークと環境が利用可能であり、プロジェクトの要件に応じて最適な組み合わせを選択することが重要です。

開発環境の構築手順

Convolution Neural Networkの開発環境構築は、システム要件の確認から始まり、段階的にセットアップを進めることが効率的です。まず、ハードウェア要件として、GPUを搭載したシステムが推奨されます。

Python環境の構築が最初のステップとなります。以下の手順で進めることができます:

- Python 3.8以上のバージョンをインストール

- 仮想環境の作成と有効化

- 必要なパッケージマネージャー(pip、conda)の準備

- CUDA環境の構築(GPU使用時)

GPU環境の構築では、NVIDIAドライバーとCUDAツールキットの適切なバージョンの組み合わせが重要です。CUDAバージョンと使用予定のフレームワークの互換性を事前に確認する必要があります。

# 仮想環境の作成例

python -m venv cnn_env

source cnn_env/bin/activate # Linux/Mac

# または

cnn_env\Scripts\activate # Windows

Jupyter NotebookやJupyterLabの導入も、対話的な開発とプロトタイピングに有効です。これらのツールを使用することで、convolution neural networkのモデル構築と実験を効率的に行えます。

主要フレームワークの比較

Convolution Neural Network開発における主要フレームワークには、それぞれ独自の特徴と利点があります。適切な選択のために、各フレームワークの特性を理解することが重要です。

| フレームワーク | 特徴 | 適用場面 | 学習コスト |

|---|---|---|---|

| TensorFlow | 柔軟性と本番環境対応 | 大規模プロジェクト | 中程度 |

| PyTorch | 動的グラフと研究向け | 研究開発 | 低 |

| Keras | シンプルな高レベルAPI | プロトタイピング | 低 |

TensorFlowは、Googleが開発したオープンソースフレームワークで、convolution neural networkの実装において強力な機能を提供します。TensorFlow 2.xでは、Eager Executionがデフォルトとなり、PyTorchに近い使いやすさを実現しています。

PyTorchは、Facebookが開発したフレームワークで、動的計算グラフを特徴としています。研究分野で広く採用されており、convolution neural networkの新しいアーキテクチャの実験に適しています。

Kerasは高レベルAPIとして設計されており、TensorFlowのバックエンドとして統合されています。初心者がconvolution neural networkを学習する際の入門フレームワークとして最適です。

実装時の注意点とベストプラクティス

Convolution Neural Networkの実装において、効率的で保守性の高いコードを書くためには、いくつかの重要な注意点とベストプラクティスを遵守する必要があります。これらの指針に従うことで、開発効率の向上と品質の高いモデルの構築が可能になります。

メモリ管理は最も重要な注意点の一つです。Convolution Neural Networkは大量のメモリを消費するため、適切なバッチサイズの設定とメモリ使用量の監視が必要です。

- バッチサイズの適切な設定

- 不要な中間変数の削除

- グラデーション蓄積の活用

- 混合精度学習の導入

コードの可読性と再利用性を高めるため、モジュール化を積極的に行うことが推奨されます。Convolution Neural Networkの各層やブロックを独立したクラスまたは関数として実装し、組み合わせて使用できるような設計が理想的です。

「良いコードは自己文書化されている」という原則に従い、変数名や関数名を明確にし、適切なコメントを付けることが重要です。

実験管理においては、再現性の確保が不可欠です。ランダムシードの固定、ハイパーパラメータの記録、モデル構成の保存を徹底することで、convolution neural networkの実験結果を確実に再現できます。

# 再現性確保の例

import torch

import numpy as np

import random

def set_seed(seed=42):

torch.manual_seed(seed)

np.random.seed(seed)

random.seed(seed)

if torch.cuda.is_available():

torch.cuda.manual_seed_all(seed)

性能最適化では、データローディングの並列化、モデルの事前コンパイル、適切な損失関数の選択が重要です。これらの要素がconvolution neural networkの学習効率と最終的な性能に大きく影響します。

実践的なCNN構築事例

Convolution Neural Network(CNN)の理論を学んだ後は、実際に手を動かして構築することが重要です。本章では、実践的なCNN構築事例として手書き数字認識システムの開発を通じて、実際の開発プロセスから性能向上までの一連の流れを詳しく解説します。これにより、convolution neural networkの実装スキルを体系的に身につけることができます。

手書き数字認識システムの開発

手書き数字認識は、convolution neural networkの入門として最適なタスクです。MNISTデータセットを使用した手書き数字認識システムは、CNNの基本的な構造と動作原理を理解するのに理想的な例となります。

システム開発において、まずデータの前処理段階では、28×28ピクセルのグレースケール画像を0-1の範囲に正規化します。この前処理により、convolution neural networkの学習効率が大幅に向上します。次に、ラベルデータをone-hotエンコーディング形式に変換し、多クラス分類に適した形式に整備します。

CNN アーキテクチャの設計では、以下の構成要素を組み合わせます:

- 畳み込み層(Convolutional Layer):特徴抽出を担当

- プーリング層(Pooling Layer):次元削減と特徴の統合

- 活性化関数(ReLU):非線形性の導入

- 全結合層(Dense Layer):最終的な分類処理

- ドロップアウト層:過学習の防止

このような構成により、convolution neural networkは段階的に低レベルな特徴から高レベルな特徴へと抽象化を進め、最終的に数字の識別を行います。

実装コードの解説

実際のconvolution neural network実装では、TensorFlowやPyTorchなどのディープラーニングフレームワークを活用します。以下に、効率的な実装のポイントを示します。

# CNN モデルの基本構造

import tensorflow as tf

from tensorflow.keras import layers, models

model = models.Sequential([

layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activation='relu'),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activation='relu'),

layers.Flatten(),

layers.Dense(64, activation='relu'),

layers.Dropout(0.5),

layers.Dense(10, activation='softmax')

])

コードの各層について詳しく解説すると、最初の畳み込み層では32個の3×3フィルタを使用して基本的なエッジや線分などの特徴を抽出します。convolution neural networkの特徴として、階層が深くなるにつれてより複雑な特徴を学習できるため、2層目では64個のフィルタを使用しています。

MaxPooling2D層の実装では、2×2の範囲から最大値を選択することで、計算量の削減と位置不変性の獲得を同時に実現しています。これにより、convolution neural networkは手書き文字の微細な位置ずれに対してロバストな性能を発揮します。

モデルのコンパイルと訓練プロセスでは、以下の設定が重要です:

| パラメータ | 推奨値 | 説明 |

|---|---|---|

| Optimizer | Adam | 適応的学習率による効率的な最適化 |

| Loss Function | categorical_crossentropy | 多クラス分類に適した損失関数 |

| Learning Rate | 0.001 | 安定した学習のためのバランス値 |

| Batch Size | 32-128 | メモリ効率と学習安定性の両立 |

性能評価と改善手法

Convolution neural networkの性能評価は、単純な精度だけでなく多角的な指標を用いて行います。手書き数字認識システムでは、訓練精度と検証精度の推移を監視することで、過学習の兆候を早期に検出できます。

性能評価の主要指標として、以下の項目を継続的にモニタリングします:

- 精度(Accuracy):全体的な分類性能の指標

- 損失値(Loss):モデルの学習進捗を示す数値

- 混同行列(Confusion Matrix):各数字クラスの誤分類パターン

- F1スコア:精度と再現率のバランスを示す指標

性能改善のための具体的な手法として、データ拡張(Data Augmentation)が非常に効果的です。convolution neural networkでは、回転、平行移動、ズームなどの変換を訓練データに適用することで、モデルの汎化性能を大幅に向上させることができます。

さらに、ハイパーパラメータの最適化により性能向上を図ります。学習率スケジューリング、バッチサイズの調整、ドロップアウト率の最適化などを組み合わせることで、convolution neural networkの性能を最大限に引き出せます。

過学習の兆候が見られる場合は、早期停止(Early Stopping)やL2正則化の導入を検討します。これらの手法により、未知データに対する予測精度を維持しながら、安定したconvolution neural networkモデルを構築できます。

最終的に、適切に調整されたCNNモデルは、手書き数字認識において95%以上の高精度を達成することが可能です。この実践例を通じて得られた知見は、より複雑なconvolution neural networkプロジェクトの基盤となります。

CNNと他の深層学習手法との比較

Convolution Neural Network(CNN)は深層学習の代表的な手法の一つですが、機械学習の世界には様々なアプローチが存在します。各手法にはそれぞれ独自の特徴と得意分野があり、適切な選択により最適な結果を得ることができます。CNNの位置づけを理解するためには、他の深層学習手法との違いを明確に把握することが重要です。

リカレントニューラルネットワークとの相違点

Convolution Neural NetworkとRecurrent Neural Network(RNN)は、それぞれ異なるデータ構造と処理方法を持つ深層学習アーキテクチャです。両者の根本的な違いを理解することで、適切な手法選択が可能になります。

CNNの特徴的な構造は、畳み込み層とプーリング層による階層的な特徴抽出にあります。画像データのような空間的な関係性を持つデータに対して、局所的なパターンを効率的に学習できる設計となっています。一方で、RNNは時系列データや順序を持つデータの処理に特化しており、前の時点の情報を記憶しながら次の処理を行う循環構造を持っています。

| 特徴 | CNN | RNN |

|---|---|---|

| データ構造 | 空間的関係性(2D/3D) | 時系列・順序関係 |

| 処理方式 | 並列処理可能 | 順次処理 |

| メモリ使用 | 固定サイズ | 可変長対応 |

| 計算効率 | 高速 | 比較的低速 |

処理速度の観点では、Convolution Neural Networkは並列処理が可能なため、GPUを活用した高速な学習と推論が実現できます。RNNは順次処理が必要なため、長いシーケンスデータでは学習時間が大幅に増加するという課題があります。また、RNNには勾配消失問題があり、長期の依存関係を学習することが困難な場合があります。

パラメータ共有の仕組みも両者で大きく異なります。CNNでは同一の畳み込みフィルタを画像全体で共有することで、位置に依存しない特徴抽出を実現しています。RNNでは同一の重み行列を各時点で共有し、時系列パターンの学習を行います。

各手法の適用場面と使い分け

深層学習手法の選択は、扱うデータの性質と解決したい問題の特性によって決定されます。Convolution Neural Networkと他の深層学習手法の使い分けを適切に行うことで、プロジェクトの成功確率を大幅に向上させることができます。

CNNが最も力を発揮する場面は、画像認識、物体検出、画像分類などの視覚的タスクです。画像データの空間的構造を活かした特徴抽出により、高い精度を実現できます。また、音声認識においても、スペクトログラムを画像として扱うことでCNNの適用が可能です。

- 画像分類・物体検出:ResNet、EfficientNet等のCNNアーキテクチャ

- 医療画像診断:X線、MRI、CT画像の解析

- 自動運転:道路状況の認識と物体検出

- 製造業:品質検査と欠陥検出システム

一方、RNNとその発展形であるLSTMやGRUは、自然言語処理、時系列予測、音声認識などの順序性が重要なタスクに適用されます。文章の翻訳、株価予測、音声合成などがその代表例です。

- 自然言語処理:機械翻訳、文章生成、感情分析

- 時系列予測:金融市場予測、需要予測

- 音声処理:音声認識、音声合成

- 異常検知:時系列データにおける異常パターンの検出

近年では、TransformerアーキテクチャがNLPタスクで主流となり、Vision Transformer(ViT)として画像領域にも展開されています。ただし、Transformerは大量のデータと計算資源を必要とするため、リソースが限られた環境ではCNNの方が実用的な場合も多くあります。

ハイブリッドアプローチも重要な選択肢です。CNN-RNNの組み合わせによる動画解析、画像キャプション生成などは、各手法の長所を活かした効果的な応用例です。Convolution Neural Networkで空間的特徴を抽出し、RNNで時系列情報を処理することで、より複雑なタスクに対応できます。

実際のプロジェクトでは、データの性質、計算資源、精度要件、処理速度要件を総合的に検討し、最適な深層学習手法を選択することが成功の鍵となります。