この記事では、ChatGPTのベースとなったTransformerの基本概念から詳細な仕組みまで初心者向けにわかりやすく解説します。エンコーダ・デコーダ構造やSelf-Attention機能、並列処理による計算効率向上などの特徴を学べるほか、GPT・BERT・PaLMなど実際の応用モデルも紹介。AI・機械学習の基礎知識を身につけたい方や、自然言語処理技術の仕組みを理解したい方の疑問を解決できます。

目次

Transformerの概要と基本的な定義

ChatGPTを支える革新的な技術

ChatGPTやGPT-4などの大規模言語モデルの驚異的な性能を支えているのが、Transformer(トランスフォーマー)と呼ばれる革新的なニューラルネットワークアーキテクチャです。2017年にGoogleの研究チームによって発表された「Attention Is All You Need」という論文で初めて紹介されたTransformerは、自然言語処理分野に革命をもたらしました。

Transformerの最大の特徴は、従来の逐次処理に依存していた手法から脱却し、アテンション機構のみを用いて文脈理解を実現したことにあります。この技術により、ChatGPTは人間と自然な対話を行い、複雑な文脈を理解した高品質な文章生成が可能となっています。現在では、GPTシリーズをはじめとする多くの先進的なAIシステムの基盤技術として広く採用されています。

系列変換を実現するニューラルネットワーク

Transformerとは、入力系列を出力系列に変換することを目的として設計されたニューラルネットワークアーキテクチャです。「系列変換」とは、ある順序を持つデータ(単語の列、音声信号、画像のピクセル列など)を別の順序を持つデータに変換する処理のことを指します。

具体的な応用例として、以下のような変換タスクで威力を発揮します:

- 機械翻訳:英語の文章を日本語の文章に変換

- 文章要約:長い文書を短い要約文に変換

- 質問応答:質問文を適切な回答文に変換

- 文章生成:プロンプトから続きの文章を生成

Transformerの核心は、入力された情報の各要素間の関係性を同時並行で分析し、文脈に応じた適切な出力を生成することにあります。この処理により、従来手法では困難だった長い文章の文脈理解や、複雑な言語的ニュアンスの捉え方が大幅に向上しました。

従来手法との根本的な違い

Transformerが登場する以前の自然言語処理では、RNN(再帰型ニューラルネットワーク)やLSTM(長短期記憶)といった逐次処理に基づく手法が主流でした。これらの従来手法は、文章を単語一つずつ順番に処理していく必要があったため、以下のような課題を抱えていました。

- 処理速度の限界:並列処理が困難で計算時間が長い

- 長期依存関係の問題:文章が長くなると前の情報を忘れやすい

- 文脈理解の制約:局所的な関係性の捉え方に限界がある

一方、Transformerは「アテンション機構のみ」というシンプルかつ強力な仕組みを採用することで、これらの課題を根本的に解決しました。全ての単語を同時に処理し、任意の位置にある単語間の関係性を直接的に学習できるため、従来手法では不可能だった高度な文脈理解が実現されています。

この革新により、Transformerは自然言語処理のデファクトスタンダードとなり、現在の生成AIブームの技術的基盤を築いています。従来の逐次処理パラダイムから並列処理パラダイムへの転換は、AI技術史における重要なマイルストーンとして位置づけられています。

Transformerの内部構造と動作メカニズム

Transformerの革新性を理解するためには、その精密に設計された内部構造と動作メカニズムを深く理解することが不可欠です。このアーキテクチャは複数の専門的なコンポーネントが有機的に連携することで、従来のニューラルネットワークでは実現困難だった高精度な系列変換処理を可能にしています。

エンコーダーとデコーダーの役割分担

Transformerアーキテクチャの中核を成すのが、エンコーダーとデコーダーという2つの主要コンポーネントです。エンコーダーは入力系列を受け取り、その内容を数値ベクトルの形で内部表現として変換する役割を担います。

エンコーダーは通常6層のスタック構造で構成され、各層には以下の要素が含まれています:

- マルチヘッドセルフアテンション機構

- ポジションワイズフィードフォワードネットワーク

- 残差接続とLayer Normalization

一方、デコーダーはエンコーダーで生成された内部表現を基に、目的の出力系列を逐次生成します。デコーダーもエンコーダーと同様に6層構造ですが、追加でエンコーダー・デコーダー間のアテンション機構を持ち、入力情報を参照しながら出力を生成する点が特徴的です。

マルチヘッドアテンション機構の詳細

マルチヘッドアテンション機構は、Transformerが単語間の複雑な関係性を捉える中核技術です。この機構は単一のアテンション計算ではなく、複数の「ヘッド」と呼ばれる並列的なアテンション計算を同時実行します。

各アテンションヘッドは異なる観点から入力系列の関係性を学習します:

- 構文的関係:主語と述語、修飾関係など文法的な結びつき

- 意味的関係:類義語、反義語、概念的な関連性

- 位置的関係:近接する単語や遠距離の依存関係

標準的なTransformerでは8つのアテンションヘッドを使用し、各ヘッドの出力を結合して最終的な表現を生成します。この並列処理により、単一のアテンション機構では捉えきれない多面的な言語パターンの学習が可能になります。

ポジションワイズフィードフォワードネットワーク

各Transformerブロックには、ポジションワイズフィードフォワードネットワーク(FFN)が組み込まれています。このネットワークは系列の各位置に対して独立に適用される2層の全結合ネットワークで、非線形変換を通じて表現力を向上させます。

FFNの構造は以下のような特徴を持ちます:

- 第1層で次元数を大幅に拡張(通常4倍)

- ReLU活性化関数による非線形変換

- 第2層で元の次元数に戻す圧縮処理

この拡張・圧縮の過程で、各位置の情報がより豊かな表現に変換され、アテンション機構だけでは学習困難な複雑なパターンの抽出が可能になります。

セルフアテンション機構による関係性抽出

セルフアテンション機構は、入力系列内の全ての位置ペア間の関連度を同時に計算する革新的な仕組みです。従来のRNNが隣接する要素間の関係を順次処理するのに対し、セルフアテンションは全ての位置間の直接的な関係性を一度に計算します。

この機構の計算プロセスは以下のステップで実行されます:

| ステップ | 処理内容 | 役割 |

|---|---|---|

| Query生成 | 各位置から問い合わせベクトルを生成 | 注目したい情報の指定 |

| Key生成 | 各位置から鍵ベクトルを生成 | 参照可能な情報の表現 |

| Value生成 | 各位置から値ベクトルを生成 | 実際に伝達される情報 |

| アテンション重み計算 | QueryとKeyの内積でスコア算出 | 関連度の定量化 |

| 重み付き和 | アテンション重みでValueを統合 | 最終的な表現の生成 |

この処理により、「この単語は文中のどの単語と最も関連が深いか」という関係性が数値的に抽出され、文脈に応じた動的な意味表現が実現されます。特に長い文章や複雑な構造を持つテキストにおいて、従来手法では困難だった遠距離依存関係の正確な捉え方が可能になっています。

従来技術との比較分析

Transformerの画期的な技術的価値を理解するためには、それまで主流だった従来技術との比較分析が不可欠です。RNNやCNNといった既存のニューラルネットワークアーキテクチャと比較することで、Transformerが自然言語処理の分野に与えた影響の大きさが明確になります。また、アテンションメカニズムの革新性についても詳しく検討することで、現代の生成AIの基盤技術としての重要性を把握することができます。

RNN(再帰型ニューラルネットワーク)との違い

RNNとTransformerの最も本質的な違いは、処理方式の根本的な構造にあります。RNNは系列データを順次処理する逐次的なアプローチを採用しており、前の時刻の隠れ状態を次の時刻の計算に利用する仕組みでした。この方式では、文章の最初の単語から最後の単語まで順番に処理する必要があり、並列処理が困難でした。

一方、Transformerは全ての位置の情報を同時に処理することが可能です。アテンション機構により、文章内の任意の位置同士の関係性を直接的に計算できるため、長距離依存関係の学習が効率的に行えます。この違いにより、Transformerは以下の優位性を実現しています:

- 並列処理による大幅な高速化

- 長期記憶の問題(勾配消失問題)の解決

- 文脈の全体的な理解能力の向上

- 計算効率の大幅な改善

CNN(畳み込みニューラルネットワーク)との比較

CNNは主に画像処理の分野で開発されたアーキテクチャですが、自然言語処理においても一定の成果を上げていました。CNNの特徴は局所的なパターンの検出に優れていることでした。畳み込みフィルターにより、近隣の要素間の関係性を効率的に抽出できる一方で、遠距離の依存関係を捉えることには限界がありました。

Transformerとの比較において、以下の重要な違いが挙げられます:

| 比較項目 | CNN | Transformer |

|---|---|---|

| 処理範囲 | 局所的なパターン | グローバルな関係性 |

| 長距離依存 | 多層化で対応(限界あり) | 直接的な関係性計算 |

| 計算複雑度 | O(n) | O(n²)(アテンション) |

| 解釈可能性 | フィルターの可視化 | アテンション重みの分析 |

特に自然言語処理において、Transformerは文章全体の文脈を同時に考慮できるため、CNNでは困難だった複雑な言語現象の理解を可能にしました。

アテンションメカニズムの革新性

Transformerが従来技術を大きく凌駕する最大の要因は、セルフアテンション機構の革新性にあります。従来のアテンションメカニズムは、エンコーダ・デコーダモデルにおいて、デコーダが入力系列のどの部分に注目すべきかを学習する補助的な役割でした。

しかし、Transformerのセルフアテンションは根本的に異なるアプローチを採用しています:

- 全対全の関係性計算:入力系列の各要素が、系列内の全ての要素との関係性を同時に計算

- マルチヘッド構造:複数の異なる観点から関係性を並行して学習

- 位置情報の明示的な組み込み:ポジショナルエンコーディングによる順序情報の保持

- 階層的な表現学習:複数層により抽象度の異なる関係性を段階的に学習

この革新により、従来技術では困難だった長距離依存関係の学習が効率的に実現され、自然言語処理タスクの性能が飛躍的に向上しました。特に機械翻訳や文書要約などの複雑なタスクにおいて、文脈の深い理解に基づく高品質な出力が可能になったのです。

Transformerがもたらす技術的優位性

Transformerアーキテクチャは、従来のニューラルネットワーク技術に比べて圧倒的な技術的優位性を持っており、これらの特徴が現代のAI技術発展の原動力となっています。特に計算効率、記憶能力、品質向上、適用範囲の4つの側面において、従来手法を大きく上回る性能を実現しています。

並列処理による高速計算の実現

Transformerの最も革新的な特徴の一つは、並列処理による高速計算の実現です。従来のRNNやLSTMでは、系列データを順次処理する必要があったため、前の処理が完了するまで次の処理を開始できませんでした。

これに対してTransformerは、セルフアテンション機構により全ての入力トークンを同時に処理できます。具体的には以下の優位性があります:

- 入力系列の全要素を一度に並列計算可能

- GPUやTPUなどの並列計算ハードウェアを最大限活用

- 学習時間の大幅な短縮(従来手法の数分の一から数十分の一)

- 推論速度の飛躍的向上

この並列処理能力により、大規模なデータセットでの学習や、リアルタイムでの推論処理が現実的になり、商用レベルでのAIアプリケーション展開が加速しました。

長期記憶能力の向上

Transformerは長期記憶能力の飛躍的向上を実現しており、これが高品質な言語理解と生成を可能にしています。従来のRNNベースのモデルでは、勾配消失問題により長い系列での依存関係を捉えることが困難でした。

Transformerのセルフアテンション機構は、この問題を根本的に解決します:

- 入力系列の任意の位置間で直接的な関係性を計算

- 勾配消失問題の回避による長距離依存関係の効果的な学習

- 文脈情報の保持期間の大幅な延長

- 複雑な文章構造や論理関係の正確な理解

この能力により、長い文書の要約、複雑な対話の継続、コード生成における文脈の維持など、従来では困難だったタスクが高精度で実行可能になっています。

翻訳品質の飛躍的向上

機械翻訳分野において、Transformerは翻訳品質の飛躍的向上をもたらしました。従来のSequence-to-Sequenceモデルと比較して、翻訳の自然さ、正確性、文脈理解の全ての面で大幅な改善を実現しています。

具体的な翻訳品質向上の要因は以下の通りです:

- エンコーダー・デコーダー間のより効率的な情報伝達

- アテンション機構による原文との対応関係の明確化

- 並列処理による一貫した翻訳品質の維持

- 多言語間での転移学習効果の向上

Google TranslateやDeepLなどの主要な翻訳サービスがTransformerベースのモデルを採用することで、人間レベルに近い翻訳品質を実現し、国際的なコミュニケーションの壁を大幅に低減しています。

柔軟な適用範囲と汎用性

Transformerアーキテクチャの最も注目すべき特徴の一つは、柔軟な適用範囲と汎用性です。当初は自然言語処理のために開発されましたが、その設計の普遍性により様々な領域への応用が可能となっています。

主要な応用領域と汎用性の特徴:

- 自然言語処理:文章生成、要約、質問応答、感情分析

- コンピュータビジョン:Vision Transformerによる画像認識・生成

- 音声処理:音声認識、音声合成、音楽生成

- マルチモーダル:テキスト・画像・音声の統合処理

- ゲームAI:戦略ゲーム、創作活動支援

- 科学計算:タンパク質構造予測、化学反応予測

この汎用性により、一つのアーキテクチャで多様なタスクに対応できるため、開発効率の向上と技術の標準化が進み、AI技術の民主化と普及に大きく貢献しています。また、異なる領域間での知識転移も可能になり、より効率的なAIシステムの構築が実現されています。

Transformerベースの主要派生モデル

Transformerアーキテクチャは、その革新的な設計思想により数多くの派生モデルを生み出し、現在のAI技術の発展を牽引しています。これらの派生モデルは、それぞれ異なる用途や特性に最適化されており、自然言語処理から画像処理、音声認識まで幅広い分野で活用されています。以下では、主要なTransformerベースの派生モデルについて詳しく解説します。

GPT(生成型事前訓練トランスフォーマー)

GPT(Generative Pre-trained Transformer)は、OpenAIが開発したトランスフォーマーベースの言語生成モデルです。このモデルは自己回帰的な言語生成に特化しており、大量のテキストデータで事前訓練を行うことで、文章の続きを自然に生成する能力を獲得しています。

GPTの特徴は、Transformerのデコーダー部分のみを使用したアーキテクチャにあります。これにより、前の単語列を基に次の単語を予測する一方向的な処理を実現しています。ChatGPTで知られるGPT-3.5やGPT-4は、この設計思想を発展させたモデルであり、対話生成や文章作成において卓越した性能を発揮します。

BERT(双方向エンコーダー表現)

BERT(Bidirectional Encoder Representations from Transformers)は、Googleが開発した双方向トランスフォーマーモデルです。従来のGPTが一方向的な処理を行うのに対し、BERTは文章の前後両方向のコンテキストを同時に考慮することで、より深い言語理解を実現します。

BERTの革新的な点は、マスクされた言語モデリング(MLM)と次文予測(NSP)という2つの事前訓練タスクにあります。MLMでは文中の一部の単語をマスクし、前後の文脈から予測させることで双方向的な理解を促進します。この特性により、BERTは文章分類、固有表現認識、質問応答などのタスクで優れた性能を示します。

PaLM(大規模言語モデル)

PaLM(Pathways Language Model)は、Googleが開発した大規模言語モデルで、数千億パラメータを持つトランスフォーマーベースのモデルです。PaLMはスケールの効果を最大限に活用することで、従来モデルでは困難だった複雑な推論タスクや多段階の問題解決能力を獲得しています。

このモデルの特徴は、単なるパラメータ数の増大だけでなく、効率的な分散学習アルゴリズムと最適化されたアーキテクチャにあります。PaLMは自然言語理解、コード生成、数学的推論など多岐にわたるタスクで人間レベルの性能を示し、汎用人工知能への重要な一歩として注目されています。

T5(Text-to-Text転移トランスフォーマー)

T5(Text-To-Text Transfer Transformer)は、Googleが提唱したユニークなアプローチを採用するトランスフォーマーモデルです。T5の革新性は、すべてのNLPタスクをテキスト生成問題として統一的に扱う点にあります。

従来のモデルが分類や抽出といった異なるタスク形式に個別に対応していたのに対し、T5はすべての入力を「テキストからテキストへ」の変換として処理します。例えば、翻訳タスクでは「translate English to German: Hello」のような形式で入力し、対応するドイツ語テキストを生成します。この統一的なアプローチにより、単一のモデルで多様なNLPタスクに対応できる汎用性を実現しています。

Vision Transformer(画像処理への応用)

Vision Transformer(ViT)は、Transformerアーキテクチャを画像認識分野に適用した画期的なモデルです。従来の画像処理では畳み込みニューラルネットワーク(CNN)が主流でしたが、ViTは画像をパッチ単位に分割してシーケンスとして扱うことで、Transformerの自己注意機構を画像に適用しました。

ViTの処理過程では、入力画像を固定サイズのパッチに分割し、各パッチを線形変換してトークン化します。これらのパッチトークンにポジション埋め込みを加え、標準的なTransformerエンコーダーで処理します。大規模データセットで事前訓練されたViTは、画像分類タスクにおいて従来のCNNベースモデルを上回る性能を達成し、コンピュータビジョン分野に新たなパラダイムをもたらしました。

Conformer(音声認識モデル)

Conformerは、音声認識タスクに特化して設計されたトランスフォーマーベースのモデルです。このモデルはTransformerの自己注意機構とCNNの局所特徴抽出能力を組み合わせることで、音声信号の持つ時系列的な特性と局所的なパターンの両方を効果的に捉えます。

Conformerアーキテクチャでは、従来のTransformerブロックに畳み込み層を統合したConformerブロックを使用します。これにより、音声の長期的な依存関係を捉える能力と、音響的な局所パターンを認識する能力を同時に実現しています。結果として、自動音声認識(ASR)タスクにおいて従来手法を大幅に上回る認識精度を達成し、音声処理分野でのTransformer活用の可能性を示しています。

DeFormer(効率化モデル)

DeFormerは、標準的なTransformerの計算効率を改善することを目的として開発された効率化モデルです。従来のTransformerでは計算量がシーケンス長の二乗に比例するという課題がありましたが、DeFormerはこの問題を解決するための革新的なアプローチを採用しています。

このモデルの核心は、注意機構の計算を線形時間で実行できる近似アルゴリズムの導入です。具体的には、低ランク分解やスパース注意パターンを活用することで、性能の劣化を最小限に抑えながら計算効率を大幅に向上させています。DeFormerにより、限られた計算リソースでもTransformerベースモデルの恩恵を受けることが可能となり、実用的なアプリケーションへの展開が促進されています。

応用分野別のTransformer活用事例

Transformerは単なる技術革新にとどまらず、様々な分野で実用的な価値を生み出している画期的な技術です。自然言語処理の枠を超えて、コンピュータビジョンや音声処理といった異なる領域でも顕著な成果を上げており、AI技術の発展を牽引する中核的な役割を果たしています。ここでは、Transformerが実際にどのような分野でどのように活用されているかを具体的に見ていきましょう。

大規模言語モデルでの実装

Transformerの最も代表的な応用分野は大規模言語モデルです。GPTシリーズやChatGPTといった革新的なサービスは、まさにTransformerアーキテクチャを基盤として構築されています。これらのモデルは、膨大なテキストデータから学習することで、人間のような自然な文章生成や対話が可能になっています。

大規模言語モデルにおけるTransformerの活用は以下のような特徴があります:

- 数十億から数百億のパラメータを持つ大規模なモデル構造

- インターネット上の大量のテキストデータでの事前学習

- 文書作成、翻訳、コード生成、質問応答など多様なタスクへの対応

- 人間のフィードバックを活用した強化学習による性能向上

特に注目すべきは、これらのモデルが単一のアーキテクチャで複数のタスクを高精度で実行できる汎用性です。従来のタスク特化型AIとは異なり、一つのモデルが様々な言語的課題に対応できることで、AI活用の新たな可能性を切り開いています。

コンピュータビジョン領域への拡張

Transformerの革新的な成果は自然言語処理にとどまらず、画像処理の分野でも大きな変革をもたらしています。Vision Transformer(ViT)の登場により、従来のCNN(畳み込みニューラルネットワーク)中心だった画像処理の常識が覆されました。

コンピュータビジョン分野でのTransformer活用事例は多岐にわたります:

- 画像分類:高精度な物体認識と分類処理

- 物体検出:画像内の複数オブジェクトの位置特定

- セマンティックセグメンテーション:画像の各ピクセル単位での詳細な分析

- 画像生成:テキストから画像を生成するモデルの構築

Vision Transformerの特徴的な処理方式は、画像を小さなパッチに分割し、それぞれを単語のように扱うことです。この手法により、画像全体の文脈を効率的に理解し、従来手法では困難だった長距離の依存関係も捉えることができるようになりました。医療画像診断や自動運転システムといった高精度が要求される分野でも実用化が進んでいます。

音声処理技術での活用

音声処理分野においても、Transformerは従来技術を凌駕する性能を発揮しています。音声認識、音声合成、音声翻訳といった様々なタスクで、Transformerベースのモデルが新たな標準となりつつあります。

音声処理でのTransformer活用における主要な技術革新は以下の通りです:

| 技術分野 | 従来技術との違い | 実現される効果 |

|---|---|---|

| 音声認識 | 時系列処理の並列化 | リアルタイム処理の高速化 |

| 音声合成 | アテンション機構による自然性向上 | 人間に近い音声品質の実現 |

| 音声翻訳 | エンドツーエンドの直接変換 | 翻訳精度と処理速度の両立 |

特に注目されるのがConformerモデルです。このモデルはTransformerの自己注意機構とCNNの局所的特徴抽出を組み合わせ、音声認識において従来手法を大幅に上回る精度を達成しています。また、多言語音声処理においても、一つのモデルで複数の言語に対応できる汎用性が評価されています。

これらの技術進歩により、音声アシスタント、リアルタイム通訳システム、音声コンテンツ制作ツールなど、私たちの日常生活に密接に関わるアプリケーションの性能が飛躍的に向上しています。

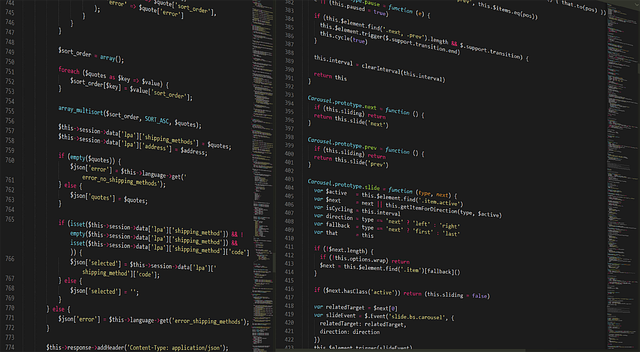

実装環境と開発フレームワーク

Transformerモデルの実装には、適切な開発フレームワークの選択と十分なハードウェア要件を満たすことが重要です。現在では多数のフレームワークが提供されており、それぞれ異なる特徴と利点を持っています。また、Transformerの計算量の大きさから、効率的な実装環境の構築が成功の鍵となります。

主要な実装フレームワーク

Transformerの実装において最も広く利用されているのがPyTorchとTensorFlowの2つのフレームワークです。これらのフレームワークは、それぞれ独自の特徴を持ちながら、Transformer実装に必要な機能を包括的に提供しています。

PyTorchは動的計算グラフを採用しており、研究開発段階でのプロトタイピングに優れています。特にHugging FaceのTransformersライブラリがPyTorchベースで構築されており、事前学習済みのTransformerモデルを簡単に利用できる環境が整っています。直感的なAPIデザインにより、アテンション機構の実装やカスタマイズが容易に行えるのが特徴です。

TensorFlowは本番環境での運用に強みを持ち、TensorFlow Servingによるモデルデプロイメントが効率的に行えます。Kerasとの統合により、高レベルなAPIでTransformerモデルの構築が可能です。また、TPU(Tensor Processing Unit)との親和性が高く、大規模なTransformerモデルの学習に適しています。

その他にも、JAXは関数型プログラミングアプローチを採用しており、自動微分とJITコンパイルによる高速な実行が可能です。FacebookのFairSeqやMicrosoftのDeepSpeedなど、特定の用途に特化したフレームワークも存在します。

- PyTorch + Hugging Face Transformers: 研究開発とプロトタイピング

- TensorFlow + Keras: 本番環境での運用

- JAX + Flax: 高性能計算とスケーラビリティ

- FairSeq: 系列変換タスクに特化

- DeepSpeed: 大規模モデルの分散学習

必要なハードウェア要件

Transformerモデルの実装と運用には、従来のニューラルネットワークよりも大幅に高いハードウェア要件が求められます。特に、アテンション機構の計算量は入力長の二乗に比例して増加するため、適切なハードウェア構成の選択が重要になります。

GPU要件については、最低でもVRAM 8GB以上のGPUが推奨されます。小規模なTransformerモデルの学習や推論にはNVIDIA RTX 3080やRTX 4070クラスが適していますが、大規模言語モデルの開発にはV100、A100、H100といったデータセンター向けGPUが必要となります。特にA100では80GBのHBMメモリを活用することで、より大きなバッチサイズでの学習が可能になります。

| 用途 | 推奨GPU | VRAM | 適用モデル規模 |

|---|---|---|---|

| 研究・プロトタイピング | RTX 4070/3080 | 12-16GB | BERT-Base、GPT-2 |

| 中規模モデル開発 | RTX 4090/A6000 | 24-48GB | BERT-Large、GPT-2 Large |

| 大規模モデル学習 | A100/H100 | 40-80GB | GPT-3、PaLM |

CPU要件では、データ前処理とバッチ生成の効率性から、マルチコア・高クロックのCPUが推奨されます。Intel Xeon Platinum 8000シリーズやAMD EPYC 7000シリーズなど、多数のコアを持つプロセッサが理想的です。また、RAM容量は最低32GB、可能であれば64GB以上を確保することで、大規模データセットの処理がスムーズに行えます。

ストレージ要件については、学習データとモデルパラメータの読み書き速度が重要になります。NVMe SSDの使用により、データローディングのボトルネックを回避できます。大規模モデルでは数百GBから数TBのストレージ容量が必要になる場合もあります。

分散学習環境では、高速ネットワーク接続も重要な要素となります。InfiniBandや100Gbps Ethernetなどの高帯域幅ネットワークにより、複数のGPU間での効率的なデータ交換が実現できます。

Transformerの課題と限界

トランスフォーマーは革新的な技術である一方で、実用化における深刻な課題も抱えています。特に計算リソース、入力長制約、エネルギー消費の3つの問題は、企業や研究機関がTransformerベースのモデルを導入・運用する際の重要な検討事項となっています。これらの限界を理解することで、より効率的なAI活用戦略を立てることが可能になります。

計算リソースの大量消費

トランスフォーマーモデルの最大の課題は、膨大な計算リソースを必要とする点にあります。アテンション機構の計算量は入力系列長の二乗に比例して増加するため、長い文章や大量のデータを処理する際には指数的にリソース消費が拡大します。

具体的なリソース消費の特徴として、以下の問題が挙げられます:

- GPU/TPUメモリの大容量消費により、高性能なハードウェアが必須

- パラメータ数の増大に伴う学習時間の長期化

- 推論時においても高い計算負荷が継続

- 並列処理による高速化にも限界が存在

この課題により、特に中小企業や個人開発者にとってはTransformerベースのモデルを独自に構築・運用することが現実的でない場合が多く、クラウドサービスへの依存度が高まる傾向にあります。

入力長の制約問題

トランスフォーマーには処理可能な入力系列長に物理的な制約があり、この限界が実用アプリケーションの設計に大きな影響を与えています。多くのモデルでは512トークンから4096トークン程度の制限が設けられており、長文書の処理や複雑な対話において課題となります。

入力長制約が引き起こす具体的な問題は以下の通りです:

- 長い文書を分割処理する必要があり、文脈の連続性が失われる

- 書籍や論文全体の理解が困難

- 複数のドキュメントを同時に参照する処理が制限される

- 対話履歴の長期保持ができない

この制約を回避するため、スライディングウィンドウ手法や階層的処理などの工夫が開発されていますが、これらの手法には計算コストの増大や精度低下というトレードオフが伴います。また、入力長を拡張するためのモデル改良は、前述の計算リソース問題をさらに深刻化させる可能性があります。

エネルギーコストの課題

トランスフォーマーベースのAIシステムは深刻なエネルギー消費問題を抱えており、環境負荷と運用コストの両面で企業の持続可能な発展を妨げる要因となっています。大規模言語モデルの学習には数百万kWhの電力が必要とされ、運用時にも継続的な電力消費が発生します。

エネルギーコストの具体的な影響は以下のような形で現れています:

- 学習フェーズでの電力消費が一般家庭の年間消費量の数千倍に達する

- データセンターの冷却コストが運用費の大きな割合を占める

- カーボンフットプリントの増大により企業のESG目標に悪影響

- 電力供給の安定性に対する依存度の高まり

この課題に対応するため、モデルの軽量化技術や効率的なアーキテクチャの研究が活発化しています。プルーニング(枝刈り)、量子化、知識蒸留などの手法により、性能を維持しながらエネルギー消費を削減する取り組みが進められていますが、根本的な解決には至っていないのが現状です。

関連技術用語の理解

トランスフォーマーを正しく理解するためには、関連する技術領域との関係性を把握することが重要です。この技術は単独で生まれたものではなく、深層学習の発展、自然言語処理の進歩、そしてアテンション機構の革新という3つの技術的な流れが融合して生まれた画期的な成果です。

深層学習との関係性

トランスフォーマーは、深層学習の中核技術であるニューラルネットワークアーキテクチャの一種として位置づけられます。従来の深層学習モデルが直面していた課題を解決するために設計されており、特に系列データの処理において革新的な性能を発揮します。

深層学習におけるトランスフォーマーの特徴は以下の通りです:

- 多層のニューラルネットワーク構造を基盤としている

- 勾配降下法による学習アルゴリズムを採用

- 大規模なパラメータ数を持つ深層モデルとして機能

- エンドツーエンドの学習が可能な設計

従来の深層学習モデルと異なる点は、畳み込みや再帰的な処理に依存せず、アテンション機構のみで情報処理を実現することにあります。これにより、並列計算が可能となり、従来モデルでは困難だった長距離依存関係の学習も効率的に行えるようになりました。

自然言語処理における位置づけ

自然言語処理(NLP)分野において、トランスフォーマーはパラダイムシフトを起こした革命的技術として評価されています。言語理解と生成の両方の課題において、従来手法を大幅に上回る性能を実現し、現代のNLP研究の基盤となっています。

自然言語処理におけるトランスフォーマーの重要性は以下の点で示されます:

- 機械翻訳タスクでの飛躍的な品質向上

- 文章生成における自然性と一貫性の大幅改善

- 言語理解タスクでの人間レベルの性能達成

- 多様なNLPタスクへの統一的なアプローチの提供

特に重要なのは、トランスフォーマーが転移学習と事前訓練の概念を自然言語処理に本格導入した点です。大規模なテキストデータで事前訓練されたトランスフォーマーモデルは、少量のタスク固有データでファインチューニングするだけで、多様なNLPタスクに適用できる汎用性を獲得しました。

アテンション機構の基礎概念

アテンション機構は、トランスフォーマーの核心となる技術概念であり、入力系列の各要素間の関係性を動的に計算する仕組みです。この機構により、モデルは処理対象の情報に対して「注意を向ける」箇所を学習によって決定できるようになります。

アテンション機構の基本的な動作原理は以下のプロセスで構成されます:

| ステップ | 処理内容 | 役割 |

|---|---|---|

| 1. クエリ生成 | 入力から注意の焦点となるクエリを作成 | 何に注意を向けるかを決定 |

| 2. キー・バリュー計算 | 入力系列からキーとバリューを抽出 | 注意を向ける対象の特徴を表現 |

| 3. 類似度計算 | クエリとキーの類似度を算出 | 注意の重みを決定 |

| 4. 重み付け和 | 類似度に基づいてバリューを重み付け | 最終的な出力を生成 |

トランスフォーマーでは、この基本的なアテンション機構を発展させたセルフアテンションとマルチヘッドアテンションを採用しています。セルフアテンションは入力系列内の要素同士の関係を捉え、マルチヘッドアテンションは複数の異なる観点から同時に関係性を学習することで、より豊富で精密な表現学習を可能にします。