この記事では、画像認識などで活躍するCNN(畳み込みニューラルネットワーク)の仕組み・構造・特徴から、顔認証や自動運転、医療などの活用事例、実装方法や導入時の注意点までを解説し、基礎理解と応用のヒントが得られます。

目次

畳み込みニューラルネットワーク(CNN)とは

CNNの概要と特徴

畳み込みニューラルネットワーク(Convolutional Neural Network, CNN)は、主に画像認識や映像解析などの分野で高い精度を発揮する深層学習モデルの一種です。人間の視覚野の仕組みに着想を得て開発されており、画像データの局所的な特徴を自動で抽出し、最終的に分類や検出などのタスクに利用します。

CNNの最大の特徴は、畳み込み層による特徴抽出と重み共有のメカニズムです。これにより、従来の全結合型ニューラルネットワークよりもパラメータ数を大幅に削減でき、計算効率や汎化性能が向上します。また、入力画像に対して平行移動や一部の変形に強いロバスト性を持つため、多様な画像認識タスクで優れた結果を残しています。

- 画像や時系列データなどの空間的または時系列的特徴を自動抽出

- パラメータ削減による高速な学習・推論

- 位置の変化や部分的な歪みに対する高い認識精度

従来のニューラルネットワークとの違い

従来の多層パーセプトロン(MLP)などの全結合型ニューラルネットワークでは、入力層から出力層までの全てのニューロンが結合されており、各入力ピクセルごとに重みが必要です。このため、画像のように高次元かつ大きな入力データでは、パラメータ数が膨大になり、学習に必要な計算量とメモリが増加してしまいます。

一方、CNNでは画像の局所領域をスライドして処理する畳み込み層を利用することで、同じフィルタ(カーネル)を複数の領域で適用し、少ないパラメータで効率的に特徴を抽出できます。この「局所受容野」と「重み共有」こそが、CNNと従来型ネットワークを根本的に分ける要素です。

DNNやRNNとの比較

CNNは深層学習の一形態であり、DNN(Deep Neural Network)やRNN(Recurrent Neural Network)とは適用分野や構造が異なります。DNNは全結合層を深く積み重ねたネットワークで、構造はシンプルですが画像処理においてはパラメータが膨大になります。RNNは系列データ、例えば文章や音声の解析に適しており、時系列依存関係を捉えるのが得意です。

一方、CNNは主に空間情報を持つデータ(画像や動画)を効率良く処理できます。近年では、CNNとRNNを組み合わせて動画解析や画像キャプション生成など、空間情報と時間情報の両方を活用するモデルも登場しています。

| モデル | 特徴 | 主な用途 |

|---|---|---|

| CNN | 局所受容野・重み共有による効率的な特徴抽出 | 画像認識、物体検出、映像解析 |

| DNN | 全結合層の多層構造、構造は単純だがパラメータが多い | 表形式データ解析、音声認識など |

| RNN | 時系列データの依存関係を学習 | 自然言語処理、音声解析、時系列予測 |

CNNの歴史と発展

初期の研究と基礎理論

畳み込みニューラルネットワーク(CNN)のルーツは、1980年代後半にさかのぼります。特に、1989年にYann LeCunらが発表した手書き数字認識の研究は、CNNの実用化に向けた大きな一歩となりました。この研究では、LeNet-1と呼ばれるモデルが使用され、畳み込み層・プーリング層・全結合層を組み合わせた基本的な構造が提案されました。

当初のCNNは、現在のような高度な計算資源が存在しなかったため、小規模なネットワークと限られたデータセット上での実験にとどまっていました。しかし、生物の視覚野に着想を得た「局所受容野」や「重み共有」といった基礎理論が確立され、今日のCNN発展の礎を築きました。

代表的なモデル(LeNet、AlexNetなど)

1990年代には、LeNet-5が登場し、特に郵便番号の自動認識などで実用化が進みました。その後、しばらくCNNの研究は停滞しましたが、2012年に発表されたAlexNetが状況を一変させます。ImageNet Large Scale Visual Recognition Challenge(ILSVRC)でそれまでのコンペ記録を大幅に上回り、誤分類率を大きく低減しました。

AlexNetは、GPUを活用した高速な学習、大規模データセットの使用、ReLUによる非線形活性化関数の導入、ドロップアウトによる過学習抑制など、現代のCNNの多くの要素を確立しました。その後、VGG、GoogLeNet、ResNetといったモデルが次々と登場し、精度と効率の両面で進化を遂げました。

近年の進化と応用分野の拡大

近年のCNNは、単なる画像分類だけでなく、物体検出、セグメンテーション、映像解析など多様なタスクに対応するよう進化しています。また、畳み込み層の改良(Depthwise Convolution、Dilated Convolutionなど)や軽量化モデル(MobileNet、ShuffleNetなど)の登場により、スマートフォンや組み込み機器でも高性能な推論が可能になっています。

さらに、医療画像診断、自動運転、監視カメラ映像分析、製造業の検査工程など、産業や社会の幅広い分野でCNNが活用されており、AIによる課題解決の中核技術のひとつとして確固たる地位を築きつつあります。今後は量子計算やマルチモーダルAIとの融合によって、より多面的な応用が期待されています。

CNNの基本構造と仕組み

畳み込み層(Convolution Layer)

畳み込み層は、畳み込みニューラルネットワーク(CNN)の中核を担う層であり、入力データから特徴を抽出する役割を持ちます。画像処理の文脈では、複数のフィルタ(カーネル)を用いて入力画像と畳み込み演算を行い、特徴マップ(Feature Map)を生成します。この過程により、エッジや色、形状などの局所的なパターンを効率的に検出できます。フィルタのサイズや枚数は学習プロセスによって最適化され、入力の階層的な特徴表現を獲得します。

活性化層(ReLUなど)

活性化層は、畳み込み層で抽出した特徴に対して非線形変換を適用し、表現力を高めるための層です。代表的なのがReLU(Rectified Linear Unit)関数で、これは0未満の値を0にし、それ以外はそのまま出力するという動作を行います。ReLUは計算コストが低く、勾配消失問題の緩和にも有効であるため、多くのCNNモデルで採用されています。その他にもLeaky ReLUやELUなどの派生形が存在し、タスクやモデル構造に応じて選択されます。

プーリング層(Pooling Layer)

プーリング層は、特徴マップの空間的サイズを縮小し、計算量を減らしながら位置の変動に対して頑健な特徴を得るために用いられます。典型的には最大値プーリング(Max Pooling)や平均値プーリング(Average Pooling)が使用されます。例えば、2×2のマックスプーリングでは、隣接する4ピクセルの中で最大値だけを出力します。これにより、特徴の抽象度が上がり、過学習を防ぐ効果も期待できます。

全結合層(Fully Connected Layer)

全結合層は、畳み込みやプーリングで得られた高次の特徴をもとに、最終的な分類や予測を行う層です。ここでは各ニューロンが前の層すべての出力と接続され、学習によって重みが最適化されます。CNNでは、畳み込み部分で得られた空間的特徴をフラット化し、この層を通して出力ラベルや数値予測に変換します。最終層にはソフトマックス関数を組み合わせることが多く、多クラス分類に適しています。

パディングとストライド

畳み込み演算においては、パディング(Padding)とストライド(Stride)の設定が特徴マップのサイズに大きく影響します。パディングとは、畳み込みによる画像サイズの縮小を防ぐために入力データの周囲にゼロを追加する手法です。一方、ストライドはフィルタを移動させる歩幅を指し、値を大きくすると特徴マップの解像度は低下しますが、計算コストは削減されます。適切な組み合わせにより、モデルの性能や効率性を最適化できます。

局所受容野と重み共有の考え方

CNNの特徴的な設計哲学として局所受容野と重み共有があります。局所受容野は、各ニューロンが入力の特定の小領域にのみ接続される概念で、これにより空間的な局所性を捉えやすくなります。さらに、同じフィルタ(重み)を画像全体で共有する重み共有の仕組みにより、学習すべきパラメータ数が大幅に削減され、メモリ効率と計算効率が向上します。これらの性質により、CNNは大規模な画像処理タスクにおいて高い性能を発揮しています。

CNNで利用される主要な技術要素

フィルタ(カーネル)と特徴マップ

畳み込みニューラルネットワーク(CNN)の中核を成すのが、フィルタ(カーネル)と特徴マップです。フィルタは画像や特徴量マップに対してスライドしながら畳み込み演算を行う小さな行列で、エッジや模様、色の変化といった特徴を抽出します。フィルタは学習過程で最適化され、局所領域に含まれる情報を捉える役割を持っています。

畳み込み演算の結果生成されるのが特徴マップ(Feature Map)です。これは入力データに対し、特定のフィルタが反応する度合いを数値として持ち、それぞれのフィルタが異なる視点で特徴を抽出した結果が並びます。これにより画像内の「どこに」「どのような特徴が」存在しているのかを効率的に表現できます。

- フィルタサイズ(例: 3×3, 5×5)が小さいと局所的な特徴を捉えやすく、大きいとより広域なパターン認識が可能。

- フィルタの数はモデルの表現力に直結し、多いほど特徴抽出の多様性が増すが計算コストも増加。

- 初期層ではエッジや色変化などの低次特徴、深層部では物体やパターン全体といった高次特徴を捉える。

よく使われる活性化関数

CNNにおいて活性化関数は、フィルタで抽出された特徴マップに非線形性を導入し、より複雑なパターンを学習可能にします。以下は代表的な活性化関数の例です。

- ReLU(Rectified Linear Unit):負の値を0にし、正の値はそのまま出力。計算が軽量で勾配消失問題を軽減。

- Leaky ReLU:負の値にも微小な勾配を持たせることでReLUの「死んだニューロン」問題を緩和。

- Sigmoid:出力を0〜1の範囲に正規化。二値分類の出力層などで利用されるが、深い層では勾配消失を起こしやすい。

- Tanh:出力を-1〜1に収めるため、中心化された学習が可能。

近年のCNNでは、中間層ではReLUやLeaky ReLUが主流であり、分類タスクの最終層ではSoftmaxなどが組み合わされます。

ハイパーパラメータとその調整方法

CNNの性能は、ハイパーパラメータの設定によって大きく左右されます。代表的なパラメータには以下のものがあります。

- フィルタサイズ(カーネルサイズ)

- フィルタ(チャンネル)数

- ストライド(フィルタ移動幅)

- パディング方法(ゼロパディングなど)

- バッチサイズや学習率

これらの調整は、グリッドサーチやランダムサーチ、さらに近年はベイズ最適化やハイパーパラメータチューニング用ライブラリ(Optuna, Hyperoptなど)が活用されます。モデル精度と計算効率のバランスを取るため、データセットの特性や目的に合わせて最適化を行うことが重要です。

モデルの計算効率を高める工夫

畳み込みニューラルネットワークは高い精度を誇りますが、計算コストが大きくなりがちです。効率化のためには、以下のような工夫が有効です。

- 深さ方向の畳み込み(Depthwise Convolution)やポイントワイズ畳み込み(1×1カーネル)による軽量化(例: MobileNetのアーキテクチャ)。

- グループ畳み込みを活用し、計算量を分割して減らす。

- 量子化(Quantization)や蒸留学習(Knowledge Distillation)によるモデル軽量化。

- GPUやTPUなどの専門ハードウェア、並列処理技術の活用。

- 推論時に不要なパラメータを削除するプルーニング(Pruning)。

これらの方法を適切に組み合わせることで、エッジデバイスなどの制約の厳しい環境でもCNNを効率的に動作させることが可能になります。

CNNの主な活用分野

画像認識・分類

畳み込みニューラルネットワーク(CNN)は、その強力な特徴抽出能力により、画像認識や分類タスクで圧倒的な成果をあげています。CNNは、画像からエッジや模様、色のパターンといった低レベル特徴を自動的に抽出し、それらを組み合わせて物体やシーンの高レベルな理解に繋げることができます。これにより、手作業で特徴量を設計する必要がなく、より高精度かつ効率的な画像分類が可能になります。

- 製品の種類や外観特性に基づく自動分類

- 写真や動画の中の風景・動物・人物の判別

- 衛星画像を用いた土地利用分類や環境モニタリング

物体検出と追跡

物体検出は、画像内の特定対象を特定し、その位置をバウンディングボックスとして出力するタスクです。CNNは、YOLOやFaster R-CNNといった高性能な検出アルゴリズムで中核的な役割を担っており、人物や車両、動物など様々なオブジェクトを高精度に検出・追跡できます。さらに、映像解析ではフレーム間の位置変化を追うことで移動経路の把握や行動パターンの分析も可能です。

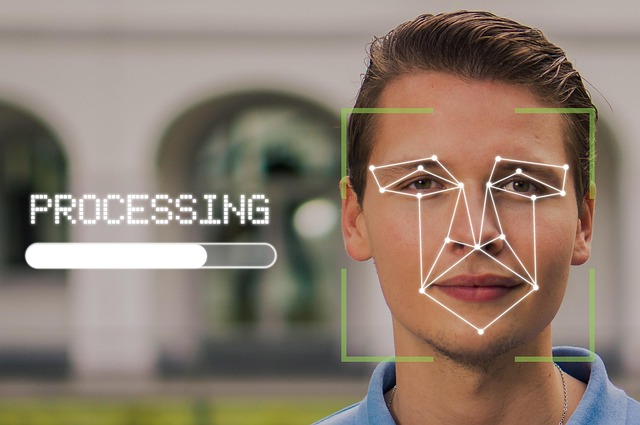

顔認証と映像解析

顔認証技術は、CNNによって大きく進化しました。従来の特徴点抽出アルゴリズムに比べ、CNNベースのモデルは照明変化や表情、角度の違いにも強く、個人の識別精度を飛躍的に向上させています。これにより、スマートフォンのロック解除、入退室管理、店舗での来店者分析など、多様な分野での利用が進んでいます。また、映像解析では、群衆の動きや異常行動の検出なども可能です。

自動運転支援

自動運転車の知覚システムでは、CNNを用いてカメラ映像から道路標識や車線、歩行者、他車両などを認識します。これらの認識結果は経路計画や制御システムに送られ、安全かつ最適な運転判断に反映されます。CNNのリアルタイム処理能力は、自動運転技術の実用化において不可欠な要素となっています。

医療画像診断

医療分野では、X線、MRI、CTなどの医用画像から疾患部位を自動検出・診断するツールとしてCNNが活用されています。例えば、肺がんの結節検出や糖尿病網膜症のスクリーニングなど、人間の専門医と同等またはそれ以上の精度を持つ事例も報告されています。これにより診断効率が向上し、早期発見・早期治療の促進が期待されています。

製造業での検査自動化

製造ラインでは、製品の外観検査や欠陥検出にCNNが導入されつつあります。人間の検査員では見落としがちな微細な傷や形状の異常も、CNNはわずかな画素の差異から検知できます。これにより、品質管理の精度が増し、欠品や不良品の流出を未然に防ぐことが可能になります。

防犯・セキュリティ分野

防犯カメラ映像のリアルタイム解析や、不審者検出、侵入検知といったセキュリティ用途でも、CNNは重要な役割を果たしています。従来の動体検知システムに比べ、CNNは対象の種類や行動の文脈を理解できるため、誤検知を減らし、より精度の高い警戒体制を構築できます。

音声認識や自然言語処理への応用

CNNは本来画像処理に強い構造を持ちますが、その局所的特徴抽出の能力を活かし、音声認識や自然言語処理でも応用されています。音声データをスペクトログラムに変換して画像として扱う方法や、文章を単語ベクトルとして畳み込む方法が存在します。これにより、音声コマンドの認識、感情分析、テキスト分類など、多彩なタスクの精度向上が実現されています。

畳み込みニューラルネットワークの実装例

PyTorchを使った実装手順

畳み込みニューラルネットワーク(CNN)のモデル開発には、ディープラーニングフレームワークであるPyTorchが広く利用されています。PyTorchは動的計算グラフを採用しており、直感的かつ柔軟なモデル構築が可能です。ここでは、PyTorchを用いたCNNのシンプルな実装手順を順を追って解説します。

- 必要ライブラリのインポート

import torch import torch.nn as nn import torch.optim as optim import torch.nn.functional as F - モデルクラスの定義

CNNは通常、

nn.Moduleを継承して作成します。class SimpleCNN(nn.Module): def __init__(self): super(SimpleCNN, self).__init__() self.conv1 = nn.Conv2d(1, 32, kernel_size=3) self.pool = nn.MaxPool2d(2, 2) self.fc1 = nn.Linear(32 * 13 * 13, 10) def forward(self, x): x = self.pool(F.relu(self.conv1(x))) x = x.view(-1, 32 * 13 * 13) x = self.fc1(x) return x - 損失関数と最適化手法の設定

model = SimpleCNN() criterion = nn.CrossEntropyLoss() optimizer = optim.Adam(model.parameters(), lr=0.001)

以上が基本的な手順であり、この後にデータ前処理、学習、評価といったプロセスを組み合わせることで、実用的な畳み込みニューラルネットワークの構築が可能になります。

学習データの前処理

CNNにおいて学習データの前処理は精度向上の鍵となります。画像データをそのまま入力するのではなく、統一フォーマットに変換し、ノイズ低減や特徴の抽出がしやすい形に整えることが重要です。一般的な手順としては次の流れが挙げられます。

- リサイズ:入力寸法をモデルに合わせるため、例えば28×28や224×224などに変換。

- 正規化:ピクセル値を0〜1または-1〜1にスケーリング。

- データ拡張:ランダムクロップ、回転、反転などを行い、過学習を防止。

from torchvision import datasets, transforms

transform = transforms.Compose([

transforms.Resize((28, 28)),

transforms.ToTensor(),

transforms.Normalize((0.5,), (0.5,))

])

train_dataset = datasets.MNIST(root='./data', train=True, download=True, transform=transform)

適切な前処理を行うことで、畳み込みニューラルネットワークの学習効率や汎化性能が向上します。

モデルの学習と評価方法

CNNモデルの学習と評価は、損失関数の最小化を目指して繰り返し重みを更新し、その性能をテストデータで確認するサイクルです。以下は一般的な流れです。

- 学習フェーズ:トレーニングデータをミニバッチに分割してモデルに入力し、誤差逆伝播法でパラメータを更新。

- 評価フェーズ:モデルを評価モード(

model.eval())に切り替え、検証・テストデータで精度や損失を計測。 - パフォーマンス指標:Accuracy、F1スコア、混同行列などを用いて性能を定量的に把握。

for epoch in range(5):

model.train()

for inputs, labels in train_loader:

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

model.eval()

# テスト精度計算処理

このように、PyTorchを活用した畳み込みニューラルネットワークの実装では、モデル定義・データ前処理・学習と評価を循環させながらモデルの性能を向上させます。適切なハイパーパラメータの調整と評価手法の選定が、最終的な成果物の価値を左右します。

導入・運用時の注意点

必要なデータ量と品質の確保

畳み込みニューラルネットワーク(CNN)を高精度に動作させるためには、大量かつ高品質なデータが不可欠です。学習データが不足している場合や、ラベル付けが曖昧なデータを使用すると、モデルの汎化性能が低下し、実運用時に予期せぬ誤分類や精度低下を招くおそれがあります。特に、画像認識や医療画像診断といった精度が求められる分野では、データの質が結果を大きく左右します。

- 十分な枚数の学習データを準備する(数千〜数百万枚規模が理想)

- ドメイン固有のデータを収集し、実環境に近い状況を反映させる

- アノテーション精度を高め、ラベルの一貫性を維持する

- データ拡張(Data Augmentation)で不足部分を補強する

また、モデルの性能検証にはトレーニングデータと異なる検証用データセットを用意し、過学習を防ぐことが重要です。

開発コストと体制整備の重要性

CNNの導入は、単にモデルを構築して学習させれば完了するものではありません。開発初期から本番運用まで、継続的な改善・保守が求められるため、長期的なコストと体制を見越した準備が必要です。GPUなどの高性能計算環境、モデリングやデータ前処理の専門知識を有する人材、そして運用後のモニタリング体制を整えることで、安定したサービス提供が可能となります。

- 初期投資としてのハードウェア・クラウド利用費用

- 学習データ収集・整備にかかる人的コスト

- モデル改善や再学習のための開発期間

- 障害対応や精度劣化時のバックアップ運用計画

特にスタートアップや中小企業ではリソースが限られるため、外部パートナーとの連携やクラウドAIサービスの活用といった選択肢も検討すべきです。

AI活用における過信とリスク管理

CNNは多くの分野で高い性能を示しますが、その結果を盲信することは危険です。学習データに含まれないパターンや異常値に対しては、予測精度が大きく低下する可能性があります。また、透明性の低いブラックボックスモデルであるため、予測理由が説明しづらいという課題も残ります。

- AIの予測結果は必ず人間による確認プロセスを通す

- 異常パターン検出や再学習のための監視指標を設定する

- 誤判定によるビジネス・社会的影響を想定したリスク対応計画を策定する

- 説明可能なAI(XAI)技術との組み合わせで透明性を向上させる

最終的な意思決定は人間が行い、CNNはあくまで支援ツールとして活用する姿勢が、リスクを最小化しつつ持続的に価値を生み出す鍵となります。

発展技術:量子畳み込みニューラルネットワーク(QCNN)

QCNNと古典的CNNの違い

量子畳み込みニューラルネットワーク(QCNN)は、従来の畳み込みニューラルネットワーク(CNN)の構造を量子コンピュータ上に最適化して適用したモデルです。最大の違いは、情報の表現と計算基盤が量子ビット(qubit)に基づく点にあります。古典的CNNはビットによる0と1の離散的な計算を行いますが、QCNNでは量子重ね合わせや量子もつれを活用して計算を行い、同じデータ量に対してより効率的な特徴抽出や並列処理が可能となる潜在能力を持ちます。

また、QCNNは高次元の状態空間を少ない量子ビットで表現できるため、クラシカルなCNNでは扱いが困難な大規模パターン認識や量子状態の分類タスクに適しています。一方で、量子デコヒーレンスや量子ゲートの誤差など、現時点ではハードウェア特有の課題も存在します。このように、QCNNは原理的に古典モデルでは得られない計算効率と表現力を追求する点において異なります。

QCNNの構造要素(畳み込み層・プーリング層)

QCNNの基本構造は古典的CNNに似ていますが、その各要素が量子回路として実装されます。

- 量子畳み込み層: 古典的なカーネルの畳み込み操作に相当する部分は、量子ゲート操作として実行されます。入力量子状態(特徴マップに相当)に対してユニタリ変換を適用し、局所的な相関を抽出します。この際、量子エンタングルメントを活用することで空間的特徴の抽出効率を高められます。

- 量子プーリング層: 特徴マップの空間的サイズを縮小するために量子測定や部分系のトレースアウトといった量子特有の操作が用いられます。これにより、不要な情報やノイズを除去しつつ重要な特徴のみを保持します。

両層とも、量子回路の深さやゲート選択が性能に直結するため、ハードウェア制約と性能向上のバランスが設計上の重要ポイントとなります。

モデリングと学習の流れ

QCNNのモデリングと学習は、大きく以下のステップで進みます。

- データの量子エンコーディング: 古典データや量子状態を量子ビット上にエンコードします。角度エンコーディングやアンプリチュードエンコーディングなど、データの性質に応じて適切な手法を選択します。

- 量子畳み込み・プーリングの適用: 設計された量子回路に沿って畳み込み層とプーリング層を交互に適用し、特徴を階層的に抽出します。

- 測定と損失計算: 出力量子状態を測定して古典データに変換し、タスクに応じた損失関数を計算します。

- パラメータ更新: バックプロパゲーションに相当する手法として、パラメータシフトルールや確率的勾配降下法(SGD)を用いて量子ゲートのパラメータを更新します。

この一連の流れを繰り返すことで、QCNNはタスクに最適化された量子回路へと進化します。特に量子特有の並列性や重ね合わせを活用した学習は、ノイズの影響が低減されたハードウェア環境において大きな可能性を秘めています。

まとめと今後の展望

畳み込みニューラルネットワーク(CNN)は、画像認識をはじめとする多くのAI分野において革新的な成果を上げてきました。その強みは、特徴量を自動で抽出できる構造と、高い汎用性にあります。近年では、計算資源の向上やアルゴリズムの洗練により、より深く複雑なモデルの構築が可能となり、その応用範囲は画像、映像、音声、さらには自然言語処理の領域にまで広がっています。

今後の展望としては、以下の方向性が注目されています。

- 軽量化と高速化の進展:モバイル端末やエッジデバイス上でも動作可能な軽量モデル(例:MobileNet、EfficientNet)の普及が進み、リアルタイム認識への応用が加速。

- 自己教師あり学習や少数データ学習:大規模なラベル付きデータに依存しないCNNモデルの訓練方法が発展し、データ収集コストの削減に貢献。

- 異種データの統合解析:画像、時系列、テキストといった複数モダリティを組み合わせたCNN応用が拡大。

- 量子コンピューティングとの融合:量子畳み込みニューラルネットワーク(QCNN)の研究が進展し、将来的に複雑な特徴抽出や高速化に寄与する可能性。

- AI倫理と公平性:CNNの広範な普及に伴い、バイアス制御や説明可能性の向上といった倫理的課題への対応が不可欠に。

これらの流れは、単に技術面の進化にとどまらず、産業や社会全体の変革を促す可能性を秘めています。特に産業現場や医療分野では、CNNのさらなる発展が安全性・効率性の向上に直結するため、企業や研究機関の取り組みが活発化するでしょう。

総じて、畳み込みニューラルネットワークは今後もAI技術の中核として進化し続け、社会のさまざまな課題解決に寄与することが期待されます。今後の研究動向を注視しつつ、技術活用の最適化と責任ある運用を並行して進めることが、持続的な発展の鍵となるでしょう。