この記事では、無料の画像生成AI「Stable Diffusion」の基本から応用まで完全網羅したガイドを提供しています。初心者でもわかるローカル環境でのインストール方法(Python・Git設定含む)、Google Colabやクラウドサービスでの利用法、プロンプト(呪文)の効果的な書き方、モデル・LoRA・ControlNetの導入方法まで詳しく解説。商用利用の注意点やトラブル対処法も含め、画像生成AIを始めたい方の全ての悩みを解決できる内容となっています。

目次

Stable Diffusionとは?画像生成AIの基本概要

Stable Diffusionは、テキストから高品質な画像を生成できる革新的なAI技術として、2022年8月に一般公開されて以来、クリエイティブ分野に大きな変革をもたらしています。この画像生成AIツールは、単純なテキストプロンプト(指示文)を入力するだけで、驚くほど詳細で美しい画像を自動生成することができます。

オープンソースの画像生成AIツールの特徴

Stable Diffusionの最大の特徴は、完全にオープンソースで公開されている点にあります。これは画像生成AI分野において画期的な出来事でした。オープンソースであることにより、以下のような大きなメリットが生まれています。

- 誰でも自由にダウンロードして利用可能

- 商用利用も基本的に許可されている

- コードの改良や機能追加を世界中の開発者が行える

- 独自のカスタマイズやモデル開発が可能

- 透明性が高く、技術的な仕組みを理解できる

この開放的なアプローチにより、Stable Diffusionは急速に普及し、多様な派生版や改良版が生まれる土壌となっています。企業や個人開発者が自由に活用できることで、イノベーションの加速につながっています。

他の画像生成AIとの違いと優位性

画像生成AI市場には、DALL-E 2やMidjourneyなどの競合サービスも存在しますが、Stable Diffusionには独自の優位性があります。

まず、利用の自由度が圧倒的に高いことが挙げられます。他の多くのサービスがクラウドベースでの利用に限定されているのに対し、Stable Diffusionはローカル環境での実行が可能です。これにより、インターネット環境に依存せず、プライバシーを保護しながら画像生成を行えます。

また、生成回数や利用時間に制限がないため、試行錯誤を重ねながら理想の画像を追求することができます。コスト面でも、初期のハードウェア投資以外は基本的に無料で利用できるため、長期的には非常に経済的です。

技術的な観点では、モデルの入れ替えや拡張機能の追加により、用途に応じたカスタマイズが可能な点も大きな特徴です。アニメ風、リアル系、特定のアーティストスタイルなど、様々な特化型モデルを使い分けることで、より精度の高い画像生成が実現できます。

Stable Diffusionの仕組みと技術的背景

Stable Diffusionは、「拡散モデル(Diffusion Model)」と呼ばれる機械学習技術を基盤としています。この技術は、画像にノイズを段階的に追加していく過程を学習し、その逆のプロセス(ノイズから画像を復元する)を実行することで、新しい画像を生成します。

具体的な生成プロセスは以下のように進行します。まず、入力されたテキストプロンプトが「テキストエンコーダー」によって数値データに変換されます。次に、ランダムノイズから開始して、テキストの指示に従いながら段階的にノイズを除去していくことで、最終的に高品質な画像が生成されます。

この技術の革新的な点は、潜在空間(Latent Space)での処理にあります。フルサイズの画像ではなく、圧縮された潜在表現上で拡散処理を行うことで、計算コストを大幅に削減しながら高品質な結果を得ることができています。これにより、一般的なGPUでも実用的な速度で画像生成が可能になりました。

無料利用の可能性と制限事項

Stable Diffusionの利用方法は大きく分けて3つありますが、それぞれ無料利用の範囲と制限が異なります。

ローカル環境での利用は、適切なPCスペックがあれば完全に無料で制限なく利用できます。ただし、VRAM 4GB以上を搭載したGPUが推奨されるため、初期のハードウェア投資が必要になる場合があります。また、電気代や冷却コストも考慮する必要があります。

クラウドサービスでの利用では、Google Colaboratoryの無料プランを活用することで、一定時間内は無料で利用可能です。ただし、連続使用時間や月間利用時間に制限があり、高負荷な処理では制限に達しやすい傾向があります。

Webサイトやアプリでの利用については、多くのサービスが基本機能を無料で提供していますが、生成回数や画像解像度、商用利用などに制限が設けられているケースが一般的です。

重要な制限事項として、生成された画像の著作権や肖像権への配慮、プラットフォームごとの利用規約の遵守が必要です。また、モデルによってはライセンス条件が異なるため、商用利用を検討する場合は事前の確認が不可欠です。

Stable Diffusionの3つの利用方法とそれぞれの特徴

Stable Diffusionを活用して画像生成を行う際には、利用者のスキルレベルや用途に応じて3つの主要な利用方法から選択することができます。それぞれの方法には独自のメリットとデメリットがあり、自分の環境や目的に最適な選択肢を理解することが重要です。

ローカル環境での構築と利用

ローカル環境での構築は、最も自由度が高く本格的なStable Diffusion利用方法です。この方法では、自分のPCに直接環境を構築することで、完全にオフラインでの画像生成が可能になります。

主なメリットとしては、生成回数の制限がなく、プライバシーが完全に保護され、カスタムモデルやプラグインを自由に追加できる点が挙げられます。また、一度環境を構築してしまえば追加コストが発生せず、長期的な利用において最もコストパフォーマンスに優れています。

一方で、高性能なGPUを搭載したPCが必要で、初期投資が高額になる可能性があります。また、環境構築にはある程度の技術知識が求められ、トラブルシューティングも自分で行う必要があります。Python環境の設定やGitの操作など、プログラミング関連の基礎知識も必要となるため、初心者には敷居が高い方法といえるでしょう。

クラウドサービスでの利用

クラウドサービスを利用したStable Diffusionは、高性能なハードウェアを所有していなくても本格的な画像生成を実現できる方法です。Google ColaboratoryやAWS、GCPなどのクラウドプラットフォームを活用します。

この方法の最大の利点は、初期投資が不要で、必要な時だけ高性能なGPU環境を利用できることです。環境構築も比較的簡単で、ブラウザがあればどこからでもアクセス可能です。また、サーバーの管理やメンテナンスが不要なため、技術的な負担を大幅に軽減できます。

しかし、継続的な利用にはコストがかかり、長期間の利用では結果的に高額になる場合があります。また、インターネット接続が必須で、生成したデータはクラウド上に保存されるためプライバシー面での懸念もあります。利用時間や生成回数に制限がある場合も多く、大量の画像生成には向いていない場合があります。

Webサイト・スマホアプリでの簡単利用

最も手軽にStable Diffusionを体験できるのが、専用のWebサイトやスマートフォンアプリを利用する方法です。複雑な環境構築や技術知識は一切不要で、誰でも簡単に画像生成を始めることができます。

この方法の大きな魅力は、アカウント登録だけですぐに利用開始できる手軽さと、直感的なユーザーインターフェースです。スマートフォンからでも気軽に画像生成が行え、SNSでの共有機能なども充実している場合が多いです。また、サービス提供者が最適化を行っているため、安定した動作が期待できます。

一方で、カスタマイズ性は大幅に制限され、利用できるモデルや機能も限定的です。多くのサービスでは生成回数に上限があり、高品質な画像生成や商用利用には追加料金が必要な場合があります。また、生成した画像の著作権や利用規約についても、各サービスの条件に従う必要があるため、事前の確認が重要です。

これらの3つの利用方法は、それぞれ異なるニーズに対応しており、自分の技術レベル、予算、用途に応じて最適な選択肢を選ぶことが、Stable Diffusionを効果的に活用するための第一歩となります。

ローカル環境でのStable Diffusion構築方法

Stable Diffusionをローカル環境で構築することで、インターネット接続に依存せずに画像生成を行うことができます。しかし、安定した動作を実現するためには、適切なハードウェア環境の準備から各種ソフトウェアのインストールまで、段階的なセットアップが必要です。ここでは、初心者の方でもスムーズに環境構築ができるよう、詳細な手順を解説していきます。

必要なPCスペックと推奨環境

Stable Diffusionを快適に利用するには、まず適切なPCスペックを満たしていることが重要です。特にGPUの性能が画像生成速度に大きく影響するため、事前の確認が欠かせません。

Windows・Macでのシステム要件

Windows環境では、Windows 10以降のOSが推奨されます。システム要件として、メモリは最低16GB、できれば32GB以上を搭載していることが理想的です。ストレージについては、モデルファイルや生成画像の保存を考慮し、50GB以上の空き容量を確保しておきましょう。

Mac環境では、macOS 12.0以降が対応しており、Apple Silicon(M1/M2チップ)搭載機種では特に良好なパフォーマンスを発揮します。Intel Mac でも動作しますが、生成速度は Apple Silicon搭載機に比べて劣る傾向があります。メモリ要件はWindowsと同様で、16GB以上が推奨されます。

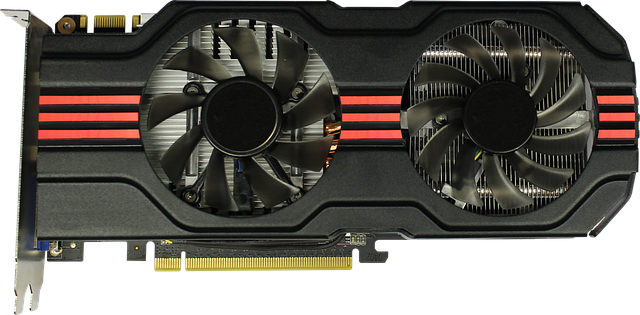

GPU搭載型PCの必要性

Stable Diffusionの画像生成において、GPU(グラフィックス処理装置)は非常に重要な役割を果たします。NVIDIA製GPUの場合、GeForce RTX 3060以上、できればRTX 4070以上の性能があると快適に利用できます。VRAM(ビデオメモリ)については、最低8GB、理想的には12GB以上を搭載したモデルを選択することで、高解像度画像の生成や複雑なプロンプトにも対応できます。

AMD製GPUについても対応していますが、NVIDIA製に比べて最適化が進んでおらず、同等スペックでも生成速度が劣る場合があります。GPU非搭載のPCでも動作しますが、CPU処理となるため生成時間が大幅に延長される点にご注意ください。

PCスペックの確認手順

現在お使いのPCスペックを確認する方法をご説明します。Windows環境では、「設定」→「システム」→「詳細情報」からCPUやメモリ容量を確認できます。GPUの詳細については、「デバイスマネージャー」→「ディスプレイアダプター」で確認可能です。

より詳細な情報が必要な場合は、「dxdiag」コマンドを実行することで、システム全体の詳細情報を取得できます。Mac環境では、「このMacについて」→「詳しい情報」から基本スペックを確認し、「システム情報」アプリでより詳細な情報を取得できます。

Python環境のセットアップ

Stable Diffusion Web UIの動作には、Python環境が必要不可欠です。適切なバージョンのPythonをインストールし、安定した実行環境を構築することが成功の鍵となります。

Python 3.10のインストール手順

Stable Diffusion Web UIは、Python 3.10系での動作が最も安定しているため、このバージョンの導入を推奨します。公式サイト(python.org)からPython 3.10の最新版をダウンロードし、インストーラーを実行してください。

Windowsでのインストール時は、「Add Python to PATH」のチェックボックスを必ず選択してください。これにより、コマンドプロンプトからPythonコマンドを直接実行できるようになります。インストール完了後は、「pip install –upgrade pip」コマンドでパッケージ管理ツールも最新版に更新しておきましょう。

バージョン確認と既存環境の対処法

Python のインストール後は、「python –version」コマンドでバージョンを確認してください。複数のPythonバージョンがインストールされている場合は、「python3.10 –version」のように具体的にバージョンを指定することで、目的のバージョンが正しくインストールされているかを確認できます。

既存のPython環境がある場合は、仮想環境(venv)の利用を検討してください。「python -m venv stable-diffusion-env」コマンドで専用の仮想環境を作成し、「stable-diffusion-env\Scripts\activate」(Windows)で有効化することで、他のPythonプロジェクトと干渉することなくStable Diffusionを利用できます。

インストール時のトラブルシューティング

Pythonインストール時によくある問題として、パス設定の不備があります。「’python’ は、内部コマンドまたは外部コマンド、操作可能なプログラムまたはバッチ ファイルとして認識されていません」というエラーが表示される場合は、環境変数PATHにPythonのインストールパスが正しく設定されているかを確認してください。

また、セキュリティソフトがPythonの実行を阻害する場合があります。このような場合は、一時的にセキュリティソフトを無効にするか、Pythonの実行ファイルを例外リストに追加することで解決できる場合があります。

Git環境の準備とインストール

Stable Diffusion Web UIのソースコードはGitHubで管理されているため、Gitが必要です。公式サイト(git-scm.com)からWindows版Gitをダウンロードし、インストールしてください。インストール時は基本的にデフォルト設定で問題ありませんが、「Git Bash」と「Git GUI」の両方を選択することをおすすめします。

Mac環境では、Homebrewを使用して「brew install git」コマンドでインストールするか、Xcodeコマンドラインツールとして提供されるGitを利用できます。インストール後は「git –version」コマンドで正常にインストールされていることを確認しましょう。

Stable Diffusion Web UIの導入手順

環境準備が完了したら、いよいよStable Diffusion Web UIをセットアップします。複数のバージョンが存在するため、用途に応じた適切な選択が重要です。

AUTOMATIC1111版とForge版の違い

現在主流となっているのは、AUTOMATIC1111版とForge版の2つです。AUTOMATIC1111版は最も普及しており、豊富な拡張機能と詳細な情報が利用できるため、初心者には最適な選択です。一方、Forge版は処理速度の最適化に特化しており、より高速な画像生成が可能ですが、一部の拡張機能に制限がある場合があります。

どちらを選択する場合も、GitHubのリポジトリから「git clone」コマンドでソースコードをダウンロードします。AUTOMATIC1111版の場合は「git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui.git」コマンドを実行してください。

webui-user.batの起動方法

ダウンロードしたフォルダ内にある「webui-user.bat」(Windows)または「webui-user.sh」(Mac/Linux)ファイルを実行することで、Web UIが起動します。初回起動時は必要な依存関係パッケージの自動インストールが行われるため、完了まで時間がかかる場合があります。

起動パラメータをカスタマイズしたい場合は、webui-user.batファイル内の「COMMANDLINE_ARGS」変数を編集してください。例えば、「–medvram」オプションを追加することで、VRAM使用量を最適化できます。

初回起動時の注意点

初回起動時は、インターネット接続が必須となります。必要なPythonパッケージのダウンロードとインストールが自動的に実行されるためです。また、初回起動には通常10分から30分程度の時間を要するため、途中で強制終了しないよう注意してください。

エラーが発生した場合は、まずコマンドプロンプトやターミナルに表示されるエラーメッセージを確認し、不足している依存関係がないかをチェックしてください。正常に起動が完了すると、ブラウザでローカルアドレス(通常は http://127.0.0.1:7860)にアクセスすることで、Web UIを利用できるようになります。

クラウド環境でのStable Diffusion活用法

ローカル環境でのStable Diffusion構築には高性能なPCが必要ですが、クラウド環境を活用することで、手軽に画像生成を始めることができます。クラウドサービスを利用する最大のメリットは、初期投資が不要で、インターネット環境さえあればどこからでもアクセス可能な点です。特に、GPUを搭載していないPCユーザーや、まずは試してみたいという初心者には最適な選択肢といえるでしょう。

Google Colaboratoryでの導入方法

Google Colaboratory(通称Colab)は、Googleが提供する無料のクラウド実行環境で、Stable Diffusion利用方法として非常に人気があります。Pythonの実行環境が既に整っており、GPUも無料で利用できるため、初心者でも簡単に始められます。ただし、無料版では連続使用時間に制限があるため、用途に応じて適切な方法を選択することが重要です。

Googleドライブを使った永続化設定

Googleドライブとの連携により、生成した画像やモデルファイルを永続的に保存できます。まず、ColabノートブックでGoogleドライブをマウントするコードを実行し、ドライブ上に専用フォルダを作成します。

from google.colab import drive

drive.mount('/content/drive')

次に、Stable Diffusion Web UIのインストール先をGoogleドライブ内に指定することで、セッションが終了してもデータが保持されます。この設定により、次回起動時にモデルの再ダウンロードが不要になり、起動時間の大幅な短縮が可能です。ただし、Googleドライブの容量制限に注意が必要で、大容量のモデルファイルを多数保存する場合は容量管理を適切に行いましょう。

直接起動による一時利用方法

永続化設定を行わず、その都度必要なファイルをダウンロードして利用する方法です。この方法はセットアップが簡単で、すぐに始められるのが特徴です。

基本的な手順は以下の通りです:

- AUTOMATIC1111のStable Diffusion Web UIのリポジトリをクローン

- 必要な依存関係を自動インストール

- 基本モデルをダウンロード

- Web UIを起動してブラウザでアクセス

この方法では毎回初期化が必要なため、モデルのダウンロードに時間がかかるデメリットがありますが、Googleドライブの容量を消費せず、一時的な利用には適しています。特に、異なるモデルを試したい場合や、テスト的に使用したい場合に有効です。

GPUクラウドサービスの活用

Google Colab以外にも、より高性能なGPUを提供するクラウドサービスが多数存在します。これらのサービスは有料ですが、より安定した環境と高速な処理性能を提供します。商用利用や大量の画像生成が必要な場合には、専用のGPUクラウドサービスの利用を検討することをおすすめします。

各種クラウドサービスの比較

主要なGPUクラウドサービスには、それぞれ異なる特徴と価格体系があります。選択する際は、以下の要素を比較検討することが重要です。

| 比較項目 | 重要度 | 確認ポイント |

|---|---|---|

| GPU性能 | 高 | RTX 4090、A100等の高性能GPU搭載の有無 |

| 料金体系 | 高 | 従量課金制、月額制、初期費用の有無 |

| 起動速度 | 中 | インスタンス起動からWeb UI利用開始までの時間 |

| ストレージ容量 | 中 | モデルファイルや生成画像の保存可能容量 |

| 利用制限 | 低 | 連続利用時間制限、同時接続数制限 |

特に注意すべきは、料金の計算方法と支払いタイミングです。サービスによっては分単位で課金されるものもあり、長時間放置すると予想以上の料金が発生する可能性があります。

ブラウザベースでの簡単立ち上げ方法

多くのGPUクラウドサービスでは、ワンクリックでStable Diffusion環境を構築できるテンプレートを提供しています。これらのテンプレートを利用することで、複雑な環境構築作業を省略し、数分でWeb UIにアクセスできるようになります。

基本的な利用手順:

- クラウドサービスにアカウント登録

- Stable Diffusion用テンプレートを選択

- 必要なGPU仕様とストレージ容量を指定

- インスタンスを起動

- 提供されるURLからWeb UIにアクセス

この方法の利点は、環境構築の知識が不要で、すぐに高性能な環境で画像生成を開始できることです。また、多くのサービスでは人気の高いモデルが事前にインストールされているため、初回起動時からさまざまなスタイルの画像生成を試すことができます。ただし、カスタマイズの自由度は制限される場合があるため、特定の要件がある場合は事前に確認が必要です。

Stable Diffusion Web UIの基本操作方法

Stable Diffusion Web UIは、直感的なブラウザベースのインターフェースを通じて高品質な画像生成を行うことができます。初めて利用する方でも理解しやすいよう、各機能の操作方法を詳しく解説していきます。

インターフェースの見方と画面構成

Stable Diffusion Web UIの画面は、機能性と使いやすさを両立させた構成となっています。メイン画面は大きく4つのエリアに分かれており、効率的な作業フローを実現しています。

画面上部には「txt2img」「img2img」「Extras」「PNG Info」などのタブが配置されており、用途に応じて切り替えが可能です。左側のパネルにはプロンプト入力欄と各種パラメータ設定が集約されており、右側には生成された画像の表示エリアと履歴が表示されます。

下部のセクションには、モデルの選択やサンプリング方法の設定、バッチサイズの調整など、より詳細な生成条件を指定するオプションが並んでいます。この構成により、初心者から上級者まで、自分のレベルに応じて必要な機能にアクセスできるようになっています。

日本語化設定の手順

Stable Diffusion Web UIはデフォルトで英語表示となっていますが、日本語化することで操作性を大幅に向上させることができます。日本語化の設定は、拡張機能を使用する方法が最も確実で安定しています。

まず、Web UIの「Extensions」タブを選択し、「Available」サブタブに移動します。検索ボックスに「localization」または「ja_JP」と入力し、日本語化拡張機能を検索してください。該当する拡張機能が見つかったら、「Install」ボタンをクリックしてインストールを実行します。

インストール完了後、「Settings」タブから「User interface」セクションに移動し、「Localization」の項目で「ja_JP」を選択します。設定を保存してWeb UIを再起動すると、インターフェースが日本語表示に切り替わり、より直感的な操作が可能になります。

txt2img:テキストから画像生成

txt2img機能は、Stable Diffusion Web UIの最も基本的で重要な機能です。テキストプロンプトを入力するだけで、AIが理解可能な指示に基づいて高品質な画像を生成することができます。

プロンプトの入力方法

プロンプトは画像生成の核となる要素で、生成したい内容を具体的に記述する必要があります。基本的には英語での入力が推奨されており、「beautiful landscape, mountain, sunset, 4k, detailed」のように、カンマで区切って複数の要素を組み合わせます。

重要な要素ほど文章の前半に配置することで、AIがより重視して画像生成に反映させることができます。また、括弧記号「()」や数値による強調表現「(keyword:1.2)」を使用することで、特定の要素を強調することも可能です。

ネガティブプロンプト欄には、生成したくない要素を記述します。「blurry, low quality, distorted」などの品質を下げる要素や、不要なオブジェクトを指定することで、より理想的な画像生成を実現できます。

生成パラメータの設定

画像生成の品質と特徴を決定する各種パラメータの適切な設定は、満足のいく結果を得るために重要です。最も基本的なパラメータには、画像サイズ、サンプリングステップ数、CFGスケールなどがあります。

画像サイズは512×512ピクセルが標準的で、処理速度と品質のバランスが良好です。より高解像度が必要な場合は768×768や1024×1024を選択できますが、VRAM使用量と生成時間が増加することに注意が必要です。

サンプリングステップ数は20-30が一般的で、数値が高いほど詳細な画像が生成されますが、処理時間も長くなります。CFGスケールは7-12の範囲で設定し、プロンプトに対する忠実度を調整できます。値が高すぎると画像が過飽和になる可能性があるため、バランスを見ながら調整することが重要です。

img2img:画像をベースにした新規生成

img2img機能は、既存の画像を参考にして新しい画像を生成する強力な機能です。写真やイラストをアップロードし、プロンプトと組み合わせることで、元画像の構図や要素を活かしながら全く新しい表現の画像を作成できます。

操作方法は、まず「img2img」タブに切り替えて、参考にしたい画像をドラッグ&ドロップまたはファイル選択でアップロードします。その後、変換したいスタイルや要素をプロンプトに記述し、「Denoising strength」パラメータで元画像からの変化度合いを調整します。

Denoising strengthの値が低い(0.3-0.5)場合は元画像により近い結果となり、高い値(0.7-0.9)では大幅な変化が加えられます。この調整により、元画像の特徴を残しつつ、望む方向性での画像変換を実現できます。

インペインティング:画像の部分修正機能

インペインティング機能は、生成済みの画像の特定部分のみを修正・変更できる高度な編集機能です。顔の表情を変更したり、背景の一部を差し替えたりと、細かな調整作業に威力を発揮します。

使用方法は、img2imgタブ内の「Inpaint」モードを選択し、編集対象の画像をアップロードします。内蔵のペイントツールを使用して、変更したい箇所をブラシで塗りつぶしてマスクを作成します。マスクされた領域のみがAIによって再生成されるため、他の部分は元の画像がそのまま保持されます。

「Inpaint area」の設定では、「Whole picture」と「Only masked」から選択でき、処理範囲を最適化できます。また、「Mask blur」パラメータでマスクの境界をぼかすことで、自然な合成結果を得ることができます。

高解像度化機能の使用方法

生成した画像をより高品質・高解像度にアップスケールする機能は、印刷用途や詳細な表示が必要な場合に重要です。Stable Diffusion Web UIには複数の高解像度化オプションが用意されており、用途に応じて選択できます。

「Hires. fix」オプションを有効にすることで、初回生成時から高解像度での出力が可能になります。アップスケール手法として「Latent」「ESRGAN」「SwinIR」などから選択でき、それぞれ異なる特徴を持っています。Latentは処理が高速で、ESRGANは写真的な画像に適しており、SwinIRはアニメ調の画像に効果的です。

「Extrasタブ」を使用した後処理でのアップスケールも可能で、既に生成済みの画像を個別に高解像度化できます。Scale factorで拡大倍率を指定し、目的に応じて最適な手法を選択することで、元画像の品質を保ちながらサイズアップを実現できます。

生成画像の保存場所と管理

効率的な創作活動のためには、生成した画像の適切な保存と管理システムの構築が不可欠です。Stable Diffusion Web UIは自動保存機能を備えており、生成された全ての画像が体系的に保存されます。

デフォルトでは、画像は「outputs」フォルダ内の各機能別サブフォルダに保存されます。txt2imgで生成した画像は「outputs/txt2img-images」に、img2imgの結果は「outputs/img2img-images」に格納され、日付別のサブフォルダで整理されます。

画像ファイルには生成時のパラメータ情報がメタデータとして埋め込まれており、「PNG Info」タブで画像をアップロードすることで、使用したプロンプトや設定値を確認・再利用できます。この機能により、気に入った画像の生成条件を後から参照し、類似の画像を作成することが可能になります。

Settings内の「Saving images/grids」セクションでは、保存形式やファイル名の規則、メタデータの埋め込み設定などをカスタマイズでき、個人のワークフローに最適化した管理システムを構築できます。

モデルの導入と活用方法

Stable Diffusionで高品質な画像を生成するためには、適切なモデルの選択と導入が欠かせません。デフォルトのモデルだけでなく、様々な特徴を持つ専用モデルを活用することで、より理想的な画像生成が可能になります。ここでは、モデルの基本知識から具体的な導入方法まで、体系的に解説していきます。

モデルファイルの基本知識

Stable Diffusionのモデルファイルには、画像生成に必要な学習済みの重みデータが含まれており、これらのファイル形式や入手方法を理解することが重要です。

safetensorsとckptファイルの違い

Stable Diffusionのモデルファイルには主に2つの形式があり、それぞれ異なる特徴を持っています。

safetensors形式は、セキュリティと安全性を重視して開発された新しいファイル形式です。この形式の最大の利点は、悪意のあるコードが埋め込まれるリスクが非常に低く、ファイルサイズも最適化されているため読み込み速度が高速という点です。また、メタデータの管理も効率的で、モデルの詳細情報を確認しやすい構造になっています。

一方、ckptファイル(Checkpoint)は従来から使用されている形式ですが、セキュリティ面でリスクがあるため注意が必要です。ckptファイルにはPythonのコードを実行する機能があるため、悪意のあるスクリプトが含まれる可能性があり、現在では使用が推奨されていません。

安全性を考慮すると、可能な限りsafetensors形式のモデルを選択することをお勧めします。

モデルダウンロード可能なサイト

高品質なモデルファイルを入手できる主要なサイトをご紹介します。

Hugging Faceは、AI・機械学習分野で最も信頼性の高いプラットフォームの一つです。厳格な審査基準があり、多くの公式モデルやコミュニティが開発したモデルが公開されています。ライセンス情報も明確に記載されており、商用利用の可否も判断しやすい構造になっています。

Civitaiは、Stable Diffusion専門のモデル共有プラットフォームで、豊富な種類のモデルが集まっています。ユーザーが生成したサンプル画像とともにモデルが紹介されているため、実際の出力結果を事前に確認できる利点があります。ただし、アップロードされるモデルの品質にばらつきがあるため、評価やレビューを参考にして選択することが重要です。

その他にも、GitHubやGoogle Drive経由で配布されているモデルもありますが、信頼できるソースからのダウンロードを心がけてください。

おすすめモデルの紹介と特徴

Stable Diffusionのモデルは、用途や生成したい画像のスタイルに応じて大きく3つのカテゴリに分類されます。それぞれの特徴を理解して、目的に最適なモデルを選択しましょう。

万能型モデルの特徴

万能型モデルは、様々なスタイルの画像生成に対応できるバランスの取れたモデルです。

このタイプのモデルの最大の特徴は、アニメ調からフォトリアルまで幅広い表現が可能で、初心者から上級者まで扱いやすい点です。特に、複数のジャンルの画像を生成したい場合や、どのモデルを選べばよいか迷っている場合には、万能型モデルから始めることをお勧めします。

代表的な万能型モデルとしては、公式のStable Diffusion 1.5や2.1があります。これらは安定性が高く、豊富なプロンプト例やチュートリアルが存在するため、学習コストが低いという利点があります。

ただし、特定分野に特化したモデルと比較すると、専門性の高い画像生成では若干品質が劣る場合があることを理解しておく必要があります。

アニメ系特化モデル

アニメ系特化モデルは、日本のアニメ・マンガ風のイラスト生成に最適化されたモデルです。

これらのモデルは、アニメキャラクターの特徴的な表現方法や色使い、線の描写などを学習しており、高品質なアニメ調イラストを簡単に生成できるのが最大の魅力です。目の表現、髪の毛の質感、服装のディテールなど、アニメ特有の要素を自然に再現できます。

また、日本のアニメ文化に精通した学習データを使用しているため、学校制服、和服、メイド服などの日本特有の衣装表現も得意とします。キャラクターのポーズや表情の バリエーションも豊富で、物語性のある画像生成が可能です。

一方で、リアルな人物や風景の生成には適していないため、用途を明確にして使用することが重要です。

リアル系特化モデル

リアル系特化モデルは、写真のような高品質でリアルな画像生成に特化したモデルです。

このタイプのモデルの強みは、人物の肌質感や髪の毛の質感、光の反射などを極めてリアルに表現できる点にあります。商業写真レベルの品質を持つポートレートや、建築物、風景写真のような画像生成が可能で、プロフェッショナルな用途にも対応できます。

特に、人物の表情や感情表現、服装のしわや質感、背景との自然な合成などにおいて、他のモデルとは一線を画す品質を実現できます。また、異なる年齢層や人種、体型の人物も自然に生成できるため、多様性のある画像制作にも適しています。

ただし、計算処理が重く、生成時間が長くなる傾向があるため、十分なGPU性能が必要になります。

モデルの導入手順と切り替え方法

実際にモデルファイルを導入する手順と、用途に応じてモデルを切り替える方法について詳しく解説します。

まず、ダウンロードしたモデルファイルの保存場所を確認しましょう。Stable Diffusion Web UIをインストールした場合、通常は以下のパスにモデルフォルダが作成されています:

stable-diffusion-webui\models\Stable-diffusion\このフォルダに、ダウンロードしたsafetensorsまたはckptファイルを直接コピーします。ファイルサイズが大きいため、コピーには時間がかかることがあります。

モデルファイルの配置が完了したら、Web UIを再起動するか、インターフェース上部にある「Refresh」ボタンをクリックしてモデル一覧を更新します。左上のモデル選択ドロップダウンメニューに新しいモデルが表示されるので、使用したいモデルを選択してください。

モデルの切り替えは、生成する画像の種類に応じて行います。例えば、アニメキャラクターを生成する場合はアニメ系モデル、商業写真のような画像を作りたい場合はリアル系モデルといったように、目的に応じた最適なモデル選択が高品質な画像生成の鍵となります。

なお、初回のモデル読み込みは時間がかかりますが、一度読み込んだモデルはメモリにキャッシュされるため、2回目以降の切り替えは高速化されます。

プロンプト(呪文)の効果的な書き方

Stable Diffusionで高品質な画像を生成するためには、プロンプト(呪文)の書き方が極めて重要です。プロンプトは画像生成AIに対する指示文であり、その書き方次第で生成される画像の品質や意図した結果が大きく左右されます。効果的なプロンプト作成には基本的なルールとテクニックがあり、これらをマスターすることで理想的な画像を生成できるようになります。

基本的なプロンプト作成のコツ

プロンプト作成において最も重要な基本原則を理解することで、Stable Diffusion利用方法の効果が劇的に向上します。これらの基本的なコツを押さえることで、初心者でも高品質な画像生成が可能になります。

英語での入力が基本

Stable Diffusionは英語圏で開発されたモデルであるため、プロンプトは英語で記述することが基本となります。日本語でも動作しますが、英語で入力した方が圧倒的に精度の高い結果を得られます。

- 「美しい女性」よりも「beautiful woman」と入力する

- 「風景画」よりも「landscape painting」と記述する

- 専門用語や芸術用語は英語の方が認識精度が高い

- Google翻訳などを活用して適切な英語表現に変換する

英語が苦手な場合でも、翻訳ツールを使いながら段階的に覚えていくことで、より効果的なプロンプト作成スキルが身につきます。

重要なキーワードを前半に配置

プロンプト内でのキーワードの配置順序は生成結果に大きく影響します。最も重要な要素や描写したい内容は、プロンプトの前半部分に記述することが効果的です。

- メインの被写体を最初に記述(例:「portrait of a young woman」)

- 重要な特徴や属性を前半に配置

- 背景や装飾的な要素は後半に記述

- 画風や技法に関する指定も前半で行う

例えば「beautiful landscape, mountain, sunset, digital art style」のように、重要度の高い順序でキーワードを配置することで、意図した画像により近い結果を得られます。

括弧と数字による強調テクニック

特定の要素を強調したい場合には、括弧と数字を組み合わせた強調記法が非常に有効です。この記法を使いこなすことで、生成される画像をより細かく制御できるようになります。

- (keyword) – 軽い強調(1.1倍相当)

- ((keyword)) – 中程度の強調(1.21倍相当)

- (keyword:1.5) – 数値指定による強調

- {keyword} – 別の強調記法(環境により異なる)

ただし、強調を多用しすぎると画像が不自然になる場合があるため、適度な使用を心がけることが重要です。

ネガティブプロンプトの活用法

ネガティブプロンプトは、生成したくない要素を指定する重要な機能です。通常のプロンプトと組み合わせることで、より精密な画像制御が可能になります。

効果的なネガティブプロンプトの活用方法は以下の通りです:

- 画質の劣化を防ぐ基本的な記述(「low quality, blurry, pixelated」)

- 不要な要素の除去(「extra limbs, deformed hands」)

- 特定の表現スタイルの回避

- 年齢制限のあるコンテンツの排除

一般的によく使用されるネガティブプロンプトには「worst quality, low quality, normal quality, lowres, bad anatomy, bad hands, vaginas, monochrome」などがあります。これらを適切に組み合わせることで、高品質な画像生成が実現できます。

おすすめプロンプト集とテンプレート

効率的にStable Diffusionを活用するために、用途別のプロンプトテンプレートを用意しておくことが有効です。以下のようなカテゴリ別のテンプレートを準備することをおすすめします:

- ポートレート系:「portrait of [subject], [style], high quality, detailed, [lighting]」

- 風景系:「beautiful landscape, [location], [time of day], [weather], masterpiece」

- アニメ系:「anime style, [character description], [pose], high resolution, detailed」

- リアル系:「photorealistic, [subject], professional photography, detailed」

これらのテンプレートを基準として、具体的な要素を追加・調整することで、安定して高品質な画像を生成できます。

先輩ユーザーの作品から学ぶプロンプト術

Stable Diffusion利用方法を向上させる最も効果的な方法の一つが、経験豊富なユーザーの作品とプロンプトを研究することです。多くのコミュニティやプラットフォームで、プロンプト情報を含む作品が共有されています。

学習に役立つリソースと活用方法:

- 画像に埋め込まれたプロンプト情報の抽出と分析

- 同じテーマでも異なるアプローチのプロンプト比較

- 成功例と失敗例の違いを理解する

- 特定のスタイルや効果を生み出すキーワードの発見

他者の作品を参考にする際は、著作権や利用規約を十分に確認した上で、学習目的に留めることが重要です。プロンプト研究を通じて得た知識を自分なりにアレンジし、オリジナルの表現を追求することが、Stable Diffusion活用スキル向上の鍵となります。

高度な機能とカスタマイズ方法

Stable Diffusionの基本操作に慣れたら、より高品質な画像生成や細かい制御を可能にする高度な機能を活用していきましょう。VAEやLoRA、拡張機能、ControlNetなどの機能を組み合わせることで、プロフェッショナルレベルの画像生成が実現できます。ここでは、Stable Diffusionの真の力を引き出すための高度なカスタマイズ方法について詳しく解説します。

VAE(Variational Autoencoder)の導入

VAEは画像の色彩やコントラストを大幅に改善する重要なコンポーネントです。通常のStable Diffusionモデルには基本的なVAEが含まれていますが、専用のVAEを導入することで画像品質を飛躍的に向上させることができます。

VAEの導入により、発色の鮮やかさ、色の正確性、細部の表現力が大幅に向上します。特にアニメ系の画像生成では、肌の質感や髪の色合いが自然になり、リアル系では写真のような質感を実現できます。

導入方法は非常にシンプルで、Hugging FaceやCivitaiからVAEファイル(.safetensors形式)をダウンロードし、Stable Diffusion Web UIの「models/VAE」フォルダに配置するだけです。その後、Web UIの設定画面からVAEを選択し、UIを再起動すれば適用されます。

おすすめのVAEとしては、汎用性の高い「vae-ft-mse-840000-ema-pruned.safetensors」や、アニメ系に特化した「kl-f8-anime2.ckpt」などがあります。用途に応じて適切なVAEを選択することで、理想的な画像品質を実現できるでしょう。

LoRA(Low-Rank Adaptation)の活用

LoRAは特定のスタイルやキャラクター、概念を学習させた軽量な追加モデルです。元のモデルを変更することなく、新しい要素を追加できる革新的な技術として多くのユーザーに支持されています。ファイルサイズが小さく、複数のLoRAを同時に適用できるため、非常に柔軟な画像生成が可能になります。

LoRAの導入手順

LoRAの導入は以下の手順で行います。まず、CivitaiやHugging Faceなどからお好みのLoRAファイルをダウンロードします。次に、ダウンロードしたLoRAファイル(.safetensors形式)を「models/Lora」フォルダに配置します。

Web UIを再起動後、生成画面の「LoRA」タブから導入したLoRAを選択できるようになります。プロンプト欄に「

おすすめLoRA一覧

用途別におすすめのLoRAをご紹介します。スタイル系では、水彩画風の「Watercolor_v1」、油絵風の「Oil_Painting」、アニメ調の「Anime_Style_v2」などが人気です。

キャラクター系では、特定のアニメキャラクターを再現するLoRAや、オリジナルキャラクターを生成するLoRAが豊富に公開されています。また、ポーズ制御用の「Pose_Control」、表情制御用の「Expression_Pack」なども実用的です。

技術的な用途では、手の描写を改善する「Better_Hands」、背景の質を向上させる「Background_Enhance」などの品質向上系LoRAも重要な選択肢となります。

自作LoRAの作成方法

独自のスタイルやキャラクターのLoRAを作成することも可能です。自作LoRA作成には、まず学習用の画像データセットを準備する必要があります。一般的に20〜100枚程度の高品質な画像が必要で、統一感のある構図や画風の画像を選定することが重要です。

学習には「Kohya_ss」や「LoRA Easy Training Scripts」などの専用ツールを使用します。これらのツールでは、学習率、バッチサイズ、エポック数などのパラメータを調整しながら、効果的なLoRAモデルを訓練できます。

学習プロセスでは、過学習を避けるためのデータ拡張や正則化の設定が重要になります。また、学習の進行状況を確認しながら、適切なタイミングで学習を停止することで、汎用性の高いLoRAを作成できます。

拡張機能の導入と活用

Stable Diffusion Web UIは拡張機能(Extensions)によって機能を大幅に拡張できます。拡張機能を活用することで、より効率的な作業フローや高度な画像編集機能を実現できるため、本格的な画像生成には欠かせない要素となっています。

おすすめ拡張機能の紹介

必須レベルの拡張機能として「ControlNet」があります。これは後述する高度な制御を可能にする重要な拡張機能です。作業効率向上系では、「Additional Networks」がLoRAの管理を簡単にし、「Dynamic Prompts」が複数のプロンプトパターンを自動生成してくれます。

画像品質向上系では、「Ultimate SD Upscale」が高解像度化処理を最適化し、「Deforum」がアニメーション生成を可能にします。「Tag Autocomplete」はプロンプト入力時の補完機能を提供し、「Image Browser」は生成画像の管理を効率化します。

実用的な拡張機能として、「Aspect Ratio Helper」が画面比率の設定を簡単にし、「Canvas Zoom」が細部編集時の操作性を向上させてくれます。

拡張機能のインストール方法

拡張機能のインストールは、Web UIの「Extensions」タブから行います。「Available」タブで利用可能な拡張機能一覧を確認し、「Load from」ボタンで最新の拡張機能リストを取得できます。

インストールしたい拡張機能の「Install」ボタンをクリックし、インストール完了後にWeb UIを再起動します。「Installed」タブでインストール済みの拡張機能を管理でき、必要に応じて有効/無効の切り替えやアップデートが可能です。

GitHubのURLから直接インストールする場合は、「Install from URL」タブでリポジトリのURLを入力してインストールできます。信頼できないソースからの拡張機能は避け、必ず評判の良い公式リポジトリから導入することを推奨します。

ControlNetによる高度な制御

ControlNetは画像生成において極めて精密な制御を可能にする革命的な拡張機能です。従来のプロンプトだけでは困難だったポーズ、構図、エッジ、深度などの詳細な制御を実現し、思い通りの画像生成を可能にします。

ControlNetには複数のモデルタイプがあり、それぞれ異なる制御方法を提供します。Cannyモデルはエッジ検出による輪郭制御、Openposeモデルは人物のポーズ制御、Depthモデルは深度情報による立体構造制御を行います。

使用方法は、参照画像をControlNetに入力し、適切な前処理を選択してから画像生成を実行するだけです。複数のControlNetモデルを同時に使用することで、より複雑で精密な制御も可能になります。

実際の活用例として、写真のポーズを参考にしたキャラクター生成、建築物の線画からのリアル化、手描きスケッチの高品質化などが挙げられます。ControlNetマスターすることで、プロフェッショナルレベルの画像制御が実現できるでしょう。

生成速度の高速化テクニック

高品質な画像生成には時間がかかることが多いため、効率的なワークフローの構築が重要です。適切な最適化設定により、画質を維持しながら大幅な時間短縮を実現できます。

サンプリング手法の最適化では、「DPM++ 2M Karras」や「Euler a」などの高速なサンプラーを選択し、ステップ数を20〜30程度に調整することで効率的な生成が可能です。CFGスケールも7〜10程度に設定することで、バランスの取れた生成時間と品質を実現できます。

ハードウェア面では、VRAM使用量の最適化設定、xFormersの有効化、mixed precisionの利用などにより大幅な高速化が期待できます。また、バッチ生成機能を活用することで、複数画像の効率的な一括生成も実現できます。

プロンプト最適化では、不要なキーワードの削除、効率的な重み付けの調整により、少ないステップ数でも高品質な結果を得られるようになります。これらのテクニックを組み合わせることで、プロ仕様の高速ワークフローを構築できるでしょう。

Stable Diffusionの応用的な使い方

Stable Diffusionの基本的な操作に慣れてきたら、より高度で実用的な使い方をマスターすることで、画像生成の可能性を大幅に広げることができます。ここでは、表情の細かな制御から技術的な運用方法まで、プロフェッショナルレベルでStable Diffusionを活用するための応用テクニックをご紹介します。

表情コントロールの手法

キャラクターの表情を正確にコントロールすることは、質の高いイラストや画像を生成する上で重要なスキルです。表情の制御には複数のアプローチがあり、それぞれの特性を理解して使い分けることが効果的な結果につながります。

最も基本的な手法は、プロンプトでの感情表現キーワードの組み合わせです。「smile」「happy」「sad」「angry」といった基本的な感情語に加えて、「gentle smile」「melancholic expression」「subtle grin」のように修飾語を組み合わせることで、より繊細な表情のニュアンスを表現できます。括弧と数値を使った強調記法「(happy:1.3)」を活用すれば、表情の強度も調整可能です。

ControlNetを使用した表情制御は、より精密な結果を得るための高度な手法です。OpenPoseやDepthマップを参考画像として使用することで、顔の向きや表情筋の動きを具体的に指定できます。特に、表情豊かな参考画像をControlNetに読み込ませることで、その表情の特徴を新しく生成する画像に正確に反映させることが可能になります。

また、LoRAモデルを活用した表情制御も効果的です。特定の表情パターンに特化したLoRAを導入することで、通常のプロンプトでは表現しにくい微細な表情の変化や、特定のキャラクターらしい表情の癖を再現できます。複数のLoRAを組み合わせて使用する際は、重みの調整により表情の強弱をコントロールできます。

PNG内情報からのプロンプト抽出

Stable Diffusionで生成された画像のPNGファイルには、生成時に使用されたプロンプトやパラメータ情報が埋め込まれています。この機能を活用することで、他のユーザーの優れた作品から学習したり、自分の過去の成功例を再現したりすることができます。

Web UIでのプロンプト抽出は非常に簡単で、生成された画像をPNG Infoタブにドラッグ&ドロップするだけで、元のプロンプト、ネガティブプロンプト、サンプラー設定、ステップ数、CFGスケール、シード値などの全ての生成情報を確認できます。この情報は「Send to txt2img」ボタンを使って直接生成画面に送信できるため、同じ設定での再生成や部分的な修正が容易に行えます。

外部のPNG画像から情報を抽出する場合も同様の手順で可能です。ただし、PNG内に情報が埋め込まれているのはStable Diffusion系のツールで生成された画像に限られるため、他の画像生成AIや通常の画像ファイルからは情報を取得できません。SNSにアップロードされた画像は、プラットフォームによる圧縮処理で情報が削除される場合があることも注意が必要です。

プロンプト情報の活用方法としては、成功したパターンをテンプレート化して保存することが効果的です。特に気に入った結果が得られた場合は、そのプロンプトをベースに部分的な変更を加えることで、一貫した品質の画像を効率的に生成できるようになります。

バージョンアップデートとダウングレード

Stable Diffusion Web UIは定期的にアップデートが行われており、新機能の追加やバグ修正、パフォーマンス向上が図られています。しかし、アップデートによって既存の環境に問題が生じる場合や、特定のバージョンでの動作を維持したい場合には、適切なバージョン管理が必要になります。

アップデートの実行は、Web UIのフォルダ内でGitコマンドを使用します。コマンドプロンプトまたはターミナルでWeb UIのディレクトリに移動し、git pullコマンドを実行することで最新版に更新できます。更新前には必ずgit statusで現在の状態を確認し、重要なカスタマイズファイルは事前にバックアップを取っておくことが重要です。

ダウングレードが必要な場合は、特定のコミットへの巻き戻しを行います。まずgit log --onelineで過去のバージョン履歴を確認し、戻りたいバージョンのハッシュ値を特定します。その後、git checkout [ハッシュ値]でそのバージョンに戻すことができます。ただし、この操作は一時的なものであり、永続的にそのバージョンを使用したい場合は、新しいブランチを作成することを推奨します。

バージョン管理において注意すべきポイントは、拡張機能やカスタムモデルとの互換性です。Web UI本体をアップデートした際に、既存の拡張機能が動作しなくなる場合があります。このような問題を回避するため、アップデート後は段階的に機能をテストし、問題が発生した場合は該当する拡張機能の更新や設定見直しを行います。

Docker版の利用方法

DockerによるStable Diffusionの実行は、環境構築の複雑さを解消し、複数の異なる設定を管理する際に非常に有効な方法です。コンテナ化により、ホストシステムに影響を与えることなく、クリーンで再現可能な環境でStable Diffusionを利用できます。

Docker版のセットアップは、まずDockerとDocker Composeがシステムにインストールされていることを確認します。その後、公式またはコミュニティが提供するStable Diffusion Dockerイメージを使用してコンテナを起動します。代表的なものとしては、AbdBarho氏が提供する「stable-diffusion-webui-docker」があり、AUTOMATIC1111版のWeb UIをDocker環境で簡単に実行できます。

Docker Composeを使用した起動では、設定ファイル(docker-compose.yml)を編集することで、GPUの使用設定、ポート番号、ボリュームマウントなどを調整できます。特に重要なのは、生成した画像やモデルファイルの永続化設定で、適切にボリュームマウントを設定することで、コンテナを再作成してもデータが保持されます。

Docker版の利点として、複数バージョンの並行運用や環境の切り替えが容易である点が挙げられます。異なる設定やバージョンのコンテナを用意することで、実験的な機能のテストや、安定版と開発版の使い分けが可能になります。また、システムのクリーン性を保ちながら、必要に応じて環境を完全にリセットできるのも大きなメリットです。

運用時の注意点として、Dockerコンテナ内でのGPUアクセスにはNVIDIA Container Toolkitの適切な設定が必要です。また、ホストシステムとコンテナ間でのファイル権限の管理や、メモリ使用量の制限設定なども、安定した動作のために適切に設定する必要があります。

よくあるエラーと対処法

Stable Diffusionの利用方法を学ぶ過程で、環境構築や画像生成時にさまざまなエラーに遭遇することがあります。これらのトラブルは初心者にとって大きな壁となりがちですが、適切な対処法を知っていれば多くの問題を解決できます。ここでは、Stable Diffusion利用方法において頻繁に発生するエラーとその具体的な解決策を段階別に詳しく解説します。

環境構築時のトラブル対応

Stable Diffusionの環境構築時は、複数のソフトウェアが連携して動作するため、各種エラーが発生しやすい段階です。特にPython、Git、Web UIの起動に関連するトラブルが多く報告されています。

Python関連のエラー解決

Python関連のエラーは、Stable Diffusionの利用方法において最も頻繁に遭遇する問題の一つです。「Python was not found」というエラーが表示される場合は、Pythonが正しくインストールされていないか、環境変数のPATHが設定されていないことが原因です。

- Pythonのバージョン確認:コマンドプロンプトで「python –version」を実行し、Python 3.10系がインストールされているか確認

- 環境変数の設定:WindowsのシステムプロパティからPythonのインストール先を環境変数PATHに追加

- 複数バージョン競合の解決:古いPythonバージョンをアンインストールするか、pyenvを使用してバージョン管理

- 権限エラーの対処:管理者権限でコマンドプロンプトを起動してインストールを実行

「ModuleNotFoundError」が発生する場合は、必要なPythonライブラリがインストールされていません。「pip install -r requirements.txt」コマンドを実行して、必要なパッケージを一括インストールしましょう。

Git関連のエラー対応

Gitに関連するエラーは、主にStable Diffusion Web UIのクローン時や更新時に発生します。「git is not recognized」エラーが表示される場合は、Gitが正しくインストールされていないか、環境変数が設定されていません。

- Git for Windowsの再インストール:公式サイトから最新版をダウンロードして、環境変数の設定を有効にしてインストール

- プロキシ環境での設定:企業環境ではプロキシ設定が必要な場合があるため、git config –global http.proxyでプロキシを設定

- SSL証明書エラーの解決:「git config –global http.sslVerify false」で一時的に回避(セキュリティリスクがあるため注意)

- リポジトリのクローンエラー:ネットワーク接続を確認し、必要に応じてVPNを切断して再試行

Web UI起動時の問題解決

Stable Diffusion Web UIの起動時には、メモリ不足やGPU認識の問題が発生することがあります。「webui-user.bat」を実行してもエラーで停止する場合の対処法は以下の通りです。

- メモリ不足エラー:「–lowvram」または「–medvram」オプションをwebui-user.batのCOMMANDLINE_ARGSに追加

- CUDA関連エラー:NVIDIAドライバとCUDAバージョンの互換性を確認し、必要に応じて更新

- ポート使用エラー:「–port 7861」オプションを追加して異なるポート番号で起動

- セキュリティソフトの干渉:一時的にウイルス対策ソフトを無効にして起動を試行

画像生成時の一般的な問題

環境構築が完了してStable Diffusionが起動できるようになっても、実際の画像生成時に様々な問題が発生することがあります。これらの問題は主に設定ミスやリソース不足によるものです。

「Out of memory」エラーは最も一般的な問題で、生成しようとする画像サイズや設定が利用可能なVRAMを超えた場合に発生します。解決策として、画像サイズを512×512に下げる、サンプリングステップ数を減らす、バッチサイズを1に設定することが効果的です。

- 生成が途中で停止する問題:プロンプトに使用禁止単語が含まれていないか確認し、ネガティブプロンプトを調整

- 生成速度が著しく遅い問題:「–xformers」オプションを有効にし、不要な拡張機能を無効化

- 生成画像の品質が低い問題:適切なモデルの選択、CFGスケールの調整(7-12推奨)、サンプリング方法の変更

- 同じ画像しか生成されない問題:シード値を-1(ランダム)に設定し、プロンプトのバリエーションを増やす

モデル読み込みエラーが発生する場合は、モデルファイルが破損していないか確認し、safetensors形式のモデルを使用することをおすすめします。また、古いckpt形式のモデルを使用する際は、セキュリティリスクがあることを理解した上で利用してください。

それでも解決しない場合の対処法

上記の対処法を試しても問題が解決しない場合は、より根本的なアプローチが必要になることがあります。トラブルシューティングの最終段階として、以下の方法を体系的に実行してください。

まず、完全なクリーンインストールを検討しましょう。既存のStable Diffusion環境を完全に削除し、Python環境も含めて一から構築し直すことで、蓄積された設定エラーや競合を解消できます。

- ログファイルの詳細確認:エラーメッセージの全文をコピーし、公式GitHubのIssuesページで同様の問題を検索

- コミュニティフォーラムの活用:RedditのStableDiffusionコミュニティや日本語の技術フォーラムで質問を投稿

- 代替版の試用:AUTOMATIC1111版で問題がある場合はStable Diffusion WebUI Forgeを試用

- クラウド環境への移行:ローカル環境での問題が解決困難な場合は、Google Colaboratoryなどのクラウド環境に切り替え

システム環境の確認も重要で、WindowsのバージョンやGPUドライバの更新状況、利用可能なディスク容量(最低20GB必要)を確認してください。また、企業ネットワークやセキュリティソフトがStable Diffusionの通信をブロックしていないかも確認が必要です。

最終手段として、Docker版のStable Diffusionを利用することで、環境依存の問題を回避できる場合もあります。Dockerを使用すれば、ホストOSに依存しない独立した環境でStable Diffusionを実行できるため、複雑な環境問題を一気に解決できる可能性があります。

商用利用と著作権に関する注意点

Stable Diffusionを利用して画像生成を行う際、特にビジネス用途での活用を検討している場合は、商用利用の可能性や著作権に関する法的な側面について十分な理解が必要です。オープンソースの画像生成AIであるStable Diffusionは基本的に商用利用が可能ですが、利用方法や関連する要素によって注意すべき点が多数存在します。

Stable Diffusionの商用利用可能性

Stable Diffusion自体は、CreativeML Open RAIL-M ライセンスの下で公開されており、商用利用が認められています。このライセンスは、研究目的から商業目的まで幅広い用途での使用を許可している一方で、悪意のある利用や有害なコンテンツの生成を制限するための条項も含まれています。

商用利用において重要なポイントは、Stable Diffusionで生成された画像の著作権が利用者に帰属するという点です。つまり、あなたが生成した画像は、あなたの創作物として扱われ、販売や商用サービスでの利用が可能になります。ただし、この権利は他の法的制約や第三者の権利を侵害しない範囲でのみ有効であることを理解しておく必要があります。

また、商用利用時には生成された画像の品質や独自性についても考慮が必要です。同じプロンプトから類似の画像が生成される可能性があるため、商標やブランディング目的で使用する場合は、十分な検討と必要に応じて法的な確認を行うことが推奨されます。

著作権・肖像権への配慮事項

Stable Diffusionを使用する際に最も注意が必要なのが、既存の著作権や肖像権の侵害リスクです。AIが学習データとして使用した膨大な画像の中には、著作権保護下にある作品や実在する人物の画像が含まれている可能性があります。

特定の著名人の名前や有名キャラクターの名称をプロンプトに含めて画像生成を行う場合、肖像権や著作権の侵害にあたる可能性があります。商用利用においては、このようなリスクを避けるため、実在する人物や既存の著作物を明示的に指定するプロンプトの使用は控えることが重要です。

また、生成された画像が既存の著作物と酷似している場合も問題となる可能性があります。偶然の一致であっても、著作権者から指摘を受ける場合があるため、商用利用前には十分な確認と必要に応じて法的なアドバイスを求めることが賢明です。

既存素材をベースにした生成の注意点

img2img機能や既存画像をベースとした画像生成を行う場合、元となる画像の権利関係について特に慎重な確認が必要です。他者が撮影した写真や描いたイラストを無断で使用することは、著作権侵害にあたる可能性があります。

安全な利用のためには、以下の素材を使用することが推奨されます:

- 自分で撮影・制作したオリジナル素材

- 商用利用可能なフリー素材

- 適切なライセンスを取得した素材

- パブリックドメインの素材

また、既存素材をベースとした生成であっても、元の画像が大幅に変更されている場合は著作権侵害のリスクが軽減される可能性がありますが、明確な基準は存在しないため、慎重な判断が必要です。

追加学習時のライセンス確認

LoRAや独自モデルの作成のために追加学習を行う場合、学習用データセットとして使用する画像のライセンスについて詳細な確認が必要です。学習用データに著作権保護下の画像を無断で使用することは、法的リスクを生む可能性があります。

特に商用目的でカスタムモデルを作成し配布する場合、学習データの権利処理が不適切であれば、モデルの利用者にも影響が及ぶ可能性があります。追加学習を行う際は、以下の点を確認することが重要です:

- 学習用画像の著作権状況

- 商用利用許可の有無

- モデル学習への利用許可

- 派生物の商用利用に関する制限

各プラットフォームでのライセンス規約

Stable Diffusionのモデルや関連素材を入手する際に利用する各プラットフォームでは、それぞれ独自のライセンス規約が設定されています。これらの規約は、基本的なStable Diffusionのライセンスに加えて適用される場合があり、商用利用時には特に注意が必要です。

Hugging Faceでの注意事項

Hugging Faceは機械学習モデルの共有プラットフォームとして広く利用されており、多くのStable Diffusion関連モデルがホストされています。Hugging Face上のモデルには、アップロード者が設定した個別のライセンスが適用されます。

商用利用を検討する際は、以下の点を確認する必要があります:

- 各モデルページに記載されたライセンス情報

- 商用利用の可否に関する明示的な記述

- 利用制限や条件の詳細

- クレジット表記の要求

Hugging Face上では、モデルカードに詳細なライセンス情報が記載されているため、ダウンロード前に必ず確認することが重要です。不明な点がある場合は、モデル作成者に直接問い合わせることも可能です。

Civitaiでの利用規約

Civitaiは、Stable Diffusion用のカスタムモデルやLoRAが豊富に公開されているコミュニティプラットフォームです。このプラットフォームでは、独自のライセンスシステムが採用されており、商用利用に関して明確な区分が設けられています。

Civitai上のモデルは以下のようなライセンスカテゴリに分類されています:

- 商用利用可能(Commercial Use Allowed)

- 非商用利用のみ(Non-Commercial Use Only)

- その他の制限付きライセンス

特に注意が必要なのは、一部のモデルが非商用利用に限定されている点です。これらのモデルを使用して生成した画像は、たとえ個人的な用途であっても販売や商用サービスでの利用はできません。モデルのダウンロード前に、ライセンス情報を必ず確認し、用途に適したモデルを選択することが重要です。

また、Civitai上では利用者によるレビューやコメントも参考になります。他のユーザーの利用経験や注意点についての情報が共有されている場合があり、商用利用を検討する際の参考材料として活用できます。

Stable Diffusion利用時の重要なポイントとまとめ

Stable Diffusionを効果的に活用するためには、これまで説明してきた様々な要素を総合的に理解し、適切に運用することが重要です。最後に、Stable Diffusion利用方法における重要なポイントをまとめ、成功への道筋を整理しておきましょう。

まず、利用環境の選択が成功の鍵となります。ローカル環境での構築は初期投資が必要ですが、長期的な利用コストを抑えられ、プライバシーも確保できます。一方、クラウド環境やWebサービスの活用は初期投資を抑えつつ、手軽に始められる利点があります。自身の利用頻度、技術レベル、予算を総合的に判断して最適な環境を選択することが重要です。

技術的な側面では、以下のポイントが特に重要です:

- 適切なモデルの選択と管理 – 用途に応じたモデルを選び、定期的に更新する

- プロンプト技術の向上 – 効果的なプロンプト作成とネガティブプロンプトの活用

- パラメータ調整の理解 – 生成画像の品質と生成時間のバランス調整

- 拡張機能の効果的活用 – LoRAやControlNetなどの高度な機能の習得

法的・倫理的な配慮も必要不可欠です。商用利用時のライセンス確認、著作権や肖像権への配慮、生成画像の適切な管理と表示は常に意識する必要があります。特に業務利用や収益化を検討する場合は、利用するモデルやプラットフォームの規約を事前に十分確認しましょう。

実践的な運用においては、継続的な学習と情報収集が成果向上につながります。コミュニティからの情報収集、新しいモデルや技術の試行、他のユーザーの作品分析を通じて、常にスキルアップを図ることが重要です。

トラブル対応に関しては、基本的なエラー対処法を身につけておくことで、問題発生時も迅速に対応できます。環境構築時のエラー、生成時の問題、パフォーマンスの低下など、よくある問題への対処法を把握しておきましょう。

Stable Diffusionは急速に進化している技術分野であり、新機能や改善が継続的に提供されています。定期的なアップデート確認、新しい手法の学習、コミュニティでの情報交換を通じて、最新の利用方法を習得し続けることが、この強力なツールを最大限活用するための重要なポイントです。適切な準備と継続的な学習により、創造的で効率的な画像生成を実現できるでしょう。